Die Geschichte des WWW aus europäischer Sicht#

von

H. Maurer, TU Graz, Juni 2019

Abstract

Zwischen der Entwicklung des WWW und des Internets wird in vielen Darstellungen wenig unterschieden. Das Internet, wie wir es heute kennen, hat seinen Ursprung zweifelsfrei in den USA. WWW wird aber oft auch als amerikanische Erfolgsgeschichte dargestellt, obwohl es tatsächlich eine europäische ist, die dann die USA sehr geschickt (um nicht zu sagen: gefinkelt) übernahmen. Es wird ferner WWW als ein „offensichtlicher“ Zusammenfluss von Hypertext bzw. Hypermediensystemen mit dem Internet gesehen, obwohl man, wie das in diesem Beitrag dargestellt wird, man auch mit Recht behaupten kann, dass das WWW ganz andere Wurzeln hat, und ganz andere Vorläufer als nur amerikanische Hypertext Systeme und das Internet. Eine solche eher amerikanischer Sicht wird unter Auslassung einiger auch amerikanische Entwicklungen im Beitrag von Schulmeister über Hypertext in diesem Buch angeboten. Daher ist dieser Beitrag einerseits in einigen kleinen Punkten eine Ergänzung, konzentriert sich aber vor allem auf andere und europäische Entwicklungen, die sich aber aus Gründen, die auch angedeutet werden schlussendlich nicht durchgesetzt haben.

1. Robert Licklider, Ted Nelson und Sam Fedida#

Die frühe Geschichte des Internets und der allmähliche Übergang von leitungsorientierten zu Paket- vermittelnden Systemen ist in der Literatur so ausführlich beschrieben, dass ich darauf nicht eingehe will, sondern eher die Personen erwähnen will, die die notwendige vorangehenden geistigen Pionierleistungen erbrachten.

Zu selten wird dabei Robert Licklider erwähnt, der schon in den fünfziger Jahren vom Konzept des „timesharing“ überzeugt war, dass also ein Computer viele Benutzer gleichzeitig bedienen kann. Dies wurde damals von den meisten als zu wenig effizient, als Science Fiktion, abgetan. Einer der wenigen aktiven Unterstützter dieses Konzeptes war übrigens der kürzlich verstorbene Douglas Engelbart, der als Erfinder der Maus zu großen Ehren kam, obwohl seine größten Verdienste eher im konzeptionellen Bereich liegen, ähnlich wie bei Licklider, die beide von der Mensch-Computer Symbiose nicht nur träumten sondern darüber schrieben und an Teilaspekten arbeiteten.

Licklider zeigte in einer erfolgreichen öffentlichen Vorführung 1957 das erste time-sharing System auf einer PDP [1]. Wenn man aber mit einem Rechner viele verteilte Benutzer mit ihren Endgeräten innerhalb einer Firma gleichzeitig bedienen kann, dann erscheint mir der Sprung, über den Bereich eines Firmengeländes hinauszugehen eher ein kleiner, ohne damit die Verdienste früher Pioniere von viel größeren Netzwerken wie es z.B. das Internet wurde, allen voran natürlich Vint Cert und Bob Kahn, schmälern zu wollen.

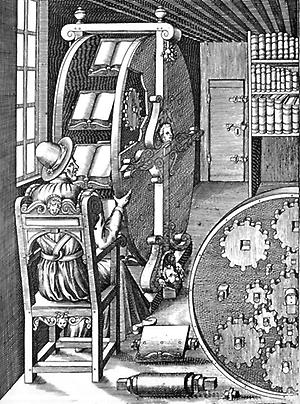

Im Vergleich dazu erscheint mir die Betonung von Vannevar Bush mit seinem Memex immer als unverdientes Hochloben, nur weil im englischen Sprachraum nicht bekannt ist, dass in vielen europäischen Bibliotheken bereits im 16. Jahrhundert mit mechanischen Buchautomaten experimentiert wurde, die ein automatischen Umblättern zu einer zugeordneten Seite eines anderen Buches ermöglichten.

Das Bild in Fig.1. zeigt das „Buchrad“1 von Ramelli aus dem Jahr 1588: man konnte, während man eine Seite las, auf einer Tatstatur etwa 12378 tippen, wodurch dann automatisch die Seite 378 des Buches 12 aufgeschlagen wurde. Es gab viele zum Teil sehr ausgefeilte Versionen solcher Buchräder: trotz aller Einschränkungen (etwa Anzahl der Bücher, die man verlinken konnte, und dass man sinnvoller Weise bei Verweisen gleich die richtige Ziffernfolge, also hier 12378 in die Seite, von der man „verzweigen“ wollte eintrug) ist hier einen Informationsverlinkung gegeben (wo nur der Mausklick durch die Eingabe von einigen Ziffern ersetzt ist) … und plötzlich ist Memex nur noch eine Neuaufwärmung einer uralten Idee mit etwas moderneren Mitteln.

Da ist die Vision von Ted Nelson (1960) schon ein anderes Kaliber: Sein Xanadu Projekt wird oft als konzeptioneller Vorläufer späterer Hypertext Systems gesehen (Nelson prägte auch den Begriff Hypertext), doch werden zahlreiche besonders wichtige Aspekte seiner Vision selten erwähnt. Ich greife drei heraus: (a) Links müssen bidirektional sein; (b) wenn mehrere „Fenster“ geöffnet sind muss es möglich sein, Elemente der beiden Fenster z. B. mit einer Linie zu verbinden; (c) es müssen „transclusions“ möglich sein.

Den Aspekt (a) behandle ich später noch aus technischer Sicht. Für Nelson war es aber auch wichtig, dass man in jedem Dokument feststellen kann, wer auf dieses verlinkt; (b) ist noch immer in kein gängiges Betriebssystem implementiert, obwohl der Nutzen auf der Hand liegt und man sich da noch immer mit Screendumps, die man dann mit einem Grafikeditor bearbeitet, behelfen muss; und dass (c) noch immer sehr selten verwirklicht ist, finde ich fast skuril. Man könnte damit Links (die ja „goto“s in der Programmierung entsprechen) oft durch Unterprogrammsaufrufe ersetzen! In der Programmierung sind „goto“s schon lange verpönt, in fast allen Hypertextsystemen (auch den üblichen WWW Anwendungen) wird aber noch immer mit Links eine Art „Spaghettiprogrammierung“ (ich zitiere Rober Cailliau) anstelle vernünftiger Strukturen verwendet, obwohl es Systeme gab bzw. gibt, die dies durchaus erlauben, wie etwa zwei, in die der Autor selbst involviert war: HM Card (1) und Hyperwave (2), oder die hierarchische Struktur des Gopher Systems, das unter der Leitung von Marc McCahill an der Universität Minnesota um 1990 entwickelt wurde (mehr dazu später).

Während 1969 als das große Jahr des (langsamen) Starts des Internets überall erwähnt wird und von WWW noch weit und breit nichts zu sehen war, hatte der englische Ingenieur Sam Fedida schon 1968 die Visison „Viewdata“ (und sogar ein Patent darauf), das die wichtigsten Elemente von WWW (aus funktionaler Sicht) enthielt. Um nicht unfair zu sein, Fedida sagt selbst, dass er durch den (spekulativen) Beitrag „The Computer as Communciation Device“ von Licklider 1968 auf die Idee kam, aber dann eben nicht lang herumkleckerte, sondern eine damals realistische Version implementierte, die 1974 (mehr als 15 Jahre vor dem WWW!) als Prototyp in Betrieb ging und noch in den 70 Jahren in den UK bereits als kommerzieller Dienst (3) angeboten wurde. ! Der Dienst wurde später Prestel genannt und in Deutschland und Österreich „Bildschirmext“ (BTX), wobei BTX in Deutschland 1977 erstmals groß auf der internationalen Funkausstellung Berlin der Öffentlichkeit präsentiert wurde. Die Einführung als Pilotbetrieb bzw. Dienst erfolgte dann etwas später, Anfang 1981 auch in Österreich. Viele europäische Länder, aber auch zahlreiche außereuropäische boten Varianten davon ab den achtziger Jahren als Dienst oder Pilotdienst an. Darüber wird im nächsten Kapitel berichtet.

2. Die Grundidee des BTX#

1968 gab es noch wenige einigermaßen leistungsfähige Großcomputer. Der erste erfolgreiche Heimcomputer (MITS Altair 8800) kam erst 1976 am Markt, der Apple I ein Jahr später (der erst ernstzunehmende nicht „Bastel“ Computer Apple II erst 1977, gleichzeitig mit dem Commodore PET). 1979 folgte Atari. Der erste echte Farbheimcomputer war dann der Tandy TRS-80 Color Computer und der Sinclair ZX80, beide 1980.

Und trotzdem, da war 1968 Sam Fedida mehr als 10 Jahre vor den ersten Heimcomputern mit seiner Vision, „alle“ Haushalte mit farbtauglichen Geräten auszurüsten, die den Zugriff und die Interaktion mit großen Informationsdatenbanken ermöglichen sollten! Und es blieb keine Vision, sondern eine konkrete Idee, die dann systematisch verwirklicht wurde:

Die meisten Haushalte hatten ein Farbfernsehgerät mit Fernbedienungstastatur und ein Telefon. Warum also nicht über ein Modem die Telefonleitung zur Übertragung von Daten aus einem Netz von Servern verwenden, und diese mit einem einfachen „Decoder“ (als Zusatzgerät oder eingebaut) den Fernseher als Displaygerät einzusetzen, mit der Fernsehtastatur als Eingabegerät?

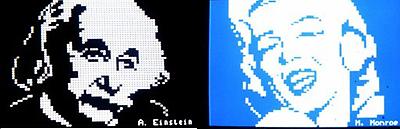

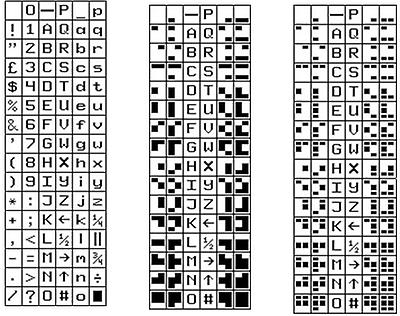

Konkreter, man würde auf den Fernsehgeräten Zeilen mit 40 Zeichen anzuzeigen, wobei 288 anzeigbare Zeichen wie in Fig.2 vorgesehen waren (zusätzlich zu verschiedensten nicht anzuzeigenden Kontrollzeichen.) Neben Groß- und Kleinbuchstaben und Sonderzeichen gab es auch „Mosaikzeichen“, um damit einfache Grafiken erstellen zu können. Sechs Hauptfarben und schwarz/weiß, sowie einigen Besonderheiten (wie Blinken, Umrahmung, doppelte Größe, u.Ä.) waren über Kontrollzeichen wählbar.

So rudimentär das klingen mag, sollte man nicht vergessen, dass auch ein Apple II 1977 noch Fernsehgeräte als Display verwendete und im Textmodus nur 64 druckbare Zeichen hatte. Z.B. hatte der Apple II keine Kleinbuchstaben!

Dass sich, wenn auch mühsam, mit den Mosaiksteinchen ganz nette Bildchen erzeugen lassen zeigen die klassischen „Portraits“ von Monroe und Einstein in Fig. 3.

Das „Netzwerk von Datenbanken“ war am Anfang ein einzelner Rechner, später ein Netz von Rechnern (die sich immer synchronisierten!). Anbieter von Informationen konnten entweder Platz auf so einem Rechner mieten oder (einige Jahre später) einen eigenen Rechner über Datex-P (X25) anschließen.

Da es als Eingabegerät zunächst nur die (numerische) Fernbedienungstastatur gab, war das System sehr stark menügetrieben. Durch wiederholte Auswahlschritte tastete man sich an die gewünschte Information heran. Dennoch war es vom Anfang an möglich, Nachrichten (EMails) an andere Benutzer oder Informationsanbieter zu senden. Am einfachsten war dies natürlich bei vorformatierten Glückwünschen, bei der Auswahl einer Bestellung usw. Aber bald wurde der „Beschriftungstrick“ angewandt: Jede Ziffer auf der Tastatur wurde mit 2 bis 3 Buchstaben belegt. Etwa: 0-ab, 1-cde,2-fgh, 3-ijk, 4-lm, 5-nop, 6-qrs, 7-st, 8-uvw, 9-xyz. Wollte man ein Wort wie „Hallo“ schreiben so tippte man die entsprechenden Ziffern 20445. Man beachte: Die fünf Ziffern ergeben Worte die mit einer der 6 Kombinationen:

fa, fb, ga, gb, ha, hb

beginnen, und die mit einer der 12 Kombinationen

lln, llo, llp, lmn, mlo, mlp, mln ,mlo, mlp, mmn, mmo, mmp

aufhören. Aus den so entstehenden 72 Worten findet sich in einem deutschen Wörterbuch nur das Wort „hallo“. Die (deutsche) Sprache ist also so redundant, dass einer Ziffernfolge meist nur ein Wort entspricht, d.h. man kann getrost mit einer Zifferntastatur Text schreiben[2]. In den wenigen Fällen, wo eine Ziffernkombination mehr als einem Wort entspricht erlaubt man die gewünschte Wahl wieder durch die Eingabe von 1, 2, etc.

In manchen Publikationen findet man bisweilen die Aussage „die erste E-Mail wurde 1983 von x an y übermittelt“. Das ist nur insofern richtig, wenn man eine Nachricht als E-Mail nur dann als solche bezeichnet, wenn das Internet der Transportweg ist. Ansonsten wurden EMails über BTX und ähnliche Systeme schon sehr viel früher versandt!

In diesem Sinn bot BTX nicht nur Informationen an, erlaubte auch Bestellungen und Buchungen, sondern auch das Versenden von Nachrichten und anderer interaktiver Tätigkeiten. Es mag durchaus sein, dass die BOX-7 (wie man sie nannte) der erste Blog, den ein ganzes Land verwenden konnte, gewesen ist, wobei man nicht einmal einen BTX Anschluss benötigte, weil viele Postämter gratis benutzbare öffentliche Terminals anboten. Die österreichische ERDE (Elektronische Rede und Diskussions Ecke) 1987 könnte wohl auch als erste der breiten Öffentlichkeit zugängliche Chat-Plattform gelten!

Schon das Ur-BTX hatte einige interessante Eigenschaften, die dem heutigen Web fehlen: z.B. hatten Nachrichten einen bekannten Absender (SPAM konnte daher nicht existieren), zweitens gab es „gebührenpflichtige Seiten“ die Mikrozahlungen zuließen, wobei diese (da die damaligen Telekoms staatliche Monopole waren) mit der Telefonrechnung ausgewiesen wurden! Damit war es möglich ohne über Benutzerkennung und Passwort hinauszugehen z.B. eine BTX Torte (keine Erfindung!) mit den Zuckerbuchstaben „Unserem Hannes alles Gute“ über BTX zu bezahlen und zu versenden.

Wie schon vorher erwähnt wurde BTX in den verschiedensten Ländern mit zusätzlichen Funktionen ausgestattet, Funktionen die zum Teil dem WWW bis heute fehlen. Darüber wird im nächsten Abschnitt berichtet.

3. Erweiterungen des BTX#

In Kanada ärgerte man sich besonders über die komplexe Mosaik-Grafik und programmierte den Decoder so, dass er automatisch gewisse geometrische Objekte zeichnen konnte. Statt z.B. einen roten Kreis annähernd und mühsam aus Mosaiksteinchen zusammen zu setzen schickte man eine Code der im Wesentlichen besagte: „Zeichne einen rot gefüllten Kreis mit Radius r und Zentrum (x, y).“ Diese Entwicklung von „geometrischer Grafik“ unter dem Namen „Telidon“ wurde dann von AT+T unter „NAPLPS“ weiterverfolgt, ohne aber einen entscheidenden Durchbruch auszulösen. In Japan setzte man mit „CAPTAIN“ nur auf pixelorientierte Bildchen, weil man so gleich japanische Schriftzeichen „mit erschlagen“ konnte, nur gab es da noch kein JPEG und damit waren die Übertragungszeiten unangenehm lang. In Europa wurde von allen damaligen Kommunikationsmonopolbetreibern 1985 einen neue Norm „CEPT II, Level 2 und 3“ (und Level 2 verpflichtend) beschlossen, was eine Umstellung bei den Benutzern, bei den Serverbetreibern und den Decoderherstellern notwendig machte und damit mit Sicherheit die Entwicklung verlangsamte statt beschleunigte. Level 2 der Norm war ein „verbessertes“ (?) BTX: 4096 Farben, 32 verschiedene Blinkfrequenzen, frei definierbare Zeichensätze („dynamically redefinable charactersets, DRCS“), u. Ä., erlaubten zwar die Erstellung sehr schöner Bildchen, freilich mit großem Aufwand. Level 3 war geometrische Grafik, war nicht verpflichtend und wurde (s. u.) nur in Österreich aktiv verfolgt.

Es ist inzwischen so viel Zeit vergangen, dass man wohl ungestraft erklären darf, warum Europa eine so verrückte europäische Grafiknorm für BTX einführte: man konnte damit die ersten am Horizont sichtbaren Heimcomputer aus Japan oder den USA aus Europa fern halten, denn ohne spezielle Hardware waren die eigentümlichen Anforderungen der Grafik erst mit sehr hochwertigen Heimcomputern und nochmals 10 Jahre später (mit dem „Amiga“ als ersten) möglich. Kurzum, die Norm war in Wahrheit ein Schutzschirm gegen Importe nach Europa. Im Schutze dieses Schirms war es vielleicht möglich, eigene europäische Geräte zu erzeugen?

Zwei der wichtigsten europäischen Mitunterzeichner freilich kümmerten sich schon vom Anfang an nicht um die neue Norm. UK machte mit Ur-BTX („Prestel“) weiter wie gehabt, mäßig erfolgreich. Die Franzosen bauten (mit einer gewissen Verzögerung) einen S/W Bildschirm mit alphabetischer Tastatur in das Telefon ein: dieses Minitel war zwar meilenweit von der CEPT II Norm entfernt, aber ideal, um es als elektronisches Telefonbuch, Nachschlagwerk, Buchungsinstrument und es für Nachrichtendienste zu verwenden. Im Laufe der Zeit benutzten 30% der französischen Haushalte (6 Millionen) ein Minitel. Im Jahr 1996 war der mit Minitel erzielte Umsatz in Frankreich noch größer als in den viel größeren USA! Die Verbreitung in Frankreich wurde insofern unterstützt, als man (anfangs) Haushalten, die auf gedruckte Telefonbücher verzichteten das Minitel gratis zur Verfügung stellte.

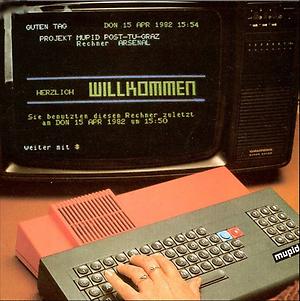

Deutschland und einige Nachbarländer setzten auf den Level 2 Standard, wobei Österreich vom Anfang an, schon zu Ur-BTX Zeiten eine neue Idee verfolgte, die auf meinen damaligen Mitarbeiter Posch (und heutigen CIO der Regierung) und mich zurückging. Wenn wir schon Fernsehgerät mit Elektronik nachrüsteten, warum dann nicht gleich mit programmierbaren Computern, die natürlich nicht nur Level 2 unterstützen konnten, sondern die man auch ohne Telefonverbindung als Kleincomputer verwenden konnte. Da externe Speicher (wie Kassettenlaufwerke) langsam und unzuverlässig waren beschlossen wir, alle Daten und Programme mit Ausnahme eines Kernbetriebssystems in den BTX Zentralrechnern abzuspeichern. Im unveränderbaren ROM des Gerätes, des MUPID (Mehrzweck Universell Programmierbarerr Intelligenter Decoder)[3] befand sich Software zur Anzeige von Daten, für Interaktionen mit den BTX Zentralen, für das Editieren, und für das Programmieren (in einer Grafikversion von BASIC). Alle Daten und selbst programmierte oder komplexe zusätzliche Programme konnte man in den BTX Zentralen ablegen, jederzeit abrufen ... ganz wie man es heute auf Smartphones mit Apps macht oder vom Cloud Computing redet, nur nannten wir es damals Teleprogramme und Zenralrechner. Die Programmierbarkeit des MUPIDS (der 1985 an den CEPT Standard angepasst wurde) erweiterte die Möglichkeiten ungemein: sehr erfolgreiche Berechnungen, Mehrpersonenspiele, Informationsverwaltungsprogramme, die ersten „Social Networks“ entstanden, und vieles mehr. Fig. 4 zeigt den Stichtag 15. April 1982. als wir den ersten MUPID der damals tatsächlich staunenden Welt (auch Fachwelt) zeigten. Der Siegeszug des MUPID im wichtigsten Absatzmarkt Deutschland wurde durch Interventionen der deutschen Post zu Gunsten deutscher Firmen gebremst (ja, auch das gab es), sodass die Gesamtproduktion 50.000 Geräte nicht überschritt, mit 40% Absatz in Österreich.

Natürlich wurde mit der Kombination MUPID/ BTX auch erstmals (landesweit) vernetztes Lernen/ Unterrichten möglich, so dass im Laufe der Zeit über 300 einstündige Unterrichtseinheiten mit Bildern, Animationen, Frage/Antwortspielen usw. entwickelt wurden. So ist es kein Wunder, dass ich bei der IFIP Worldkonferenz 1986 bereits über „Nationwide teaching through a network of microcomputers“ (4) berichten konnte. Das Projekt nannte sich COSTOC (Computer Supported Teaching of Computer Science) und wurde an Dutzenden Universitäten weltweit eingesetzt. Eine partielle Liste findet sich auf http://much.iicm.edu/projects/costoc_2/3.htm . Es gab Kurse in Deutsch und Englisch, einige von Topforschern wie Arto Salomaa, Thomas Ottmann oder Ian Witten verfasst.

Bildmaterial und andere Informationen zu MUPID, COSTOC, BTX, Autool (dem Editierwerkzeug für COSTOC), Hyper-G, Hyperwave, Harmony, Amadeus, HM-Card, GENTLE usw. finden sich unter

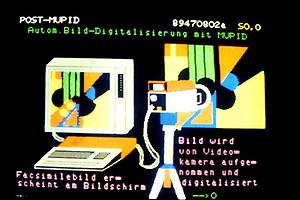

Mit MUPID waren auch schon Pixelbilder leicht generierbar und anzeigbar: die fehlen guten Bildkomprimierungsmethoden und langsamen Leitungen bewirkten freilich, dass der Einsatz anfangs recht beschränkt war. Aber Fig. 5 zeigt, dass man BTX sogar verwendete, um den Prozess der Digitalisierung zu erklären!

Fig. 6. zeigt MUPID-Teleschach: man konnte damit synchron und asynchron auch mit mehreren Personen Schach spielen. Eine Chat-Komponente war eingebaut. Und war grade keine Spieler im System spielte man (ohne das vielleicht zu wissen) gegen ein Schachprogramm, das sogar mit Eliza-ähnlichen Methoden am Chat teilnahm.

Fig.6. : Teleschach. Der Eintrag „2 KOMM.“ Für Kommunikation aktivierte einen Chat Nach all diesen Jubelmeldungen drängt sich die Frage auf: was ging dann daneben, warum wurden BTX in Kombination mit Geräten (Heimcomputern) nicht der wirkliche Erfolg, sondern blieb dies anderen Systemen vorbehalten, so dass nach 2001 allmählich alle BTX Systeme eingestellt wurden, in Frankreich 2006 am spätesten.

Die Antworten sind nicht für jedes Land gleich: der relativ große Erfolg in Frankreich beispielsweise führte dazu, dass WWW dort erst spät eingeführt wurde, was für Frankreich einige Jahre lang sogar nachteilig war. So schildere ich die Situation in Österreich, die in Variationen auch für andere Länder zutrifft.

Die BTX Zentralen waren teure und zunehmend schlecht wartbare bzw. modifizierbare Geräte. Die Strukturierung der Daten in einer einfachen Datenbank über Links war nicht gut genug. Die Protokolle waren zu wenig ausgefeilt, die Benutzbarkeit der Zentralen und der damit verbundenen „externen“ Rechner war schwierig. Aber am schlimmsten aber waren die Kosten für die Benutzer. Die Gerätschaft konnte zwar recht preiswert von der damaligen Post gemietet (und damit auch gratis gewartet) werden. aber Telefonortsgespräche in Österreich kosteten pro Stunde AS 40.- was vermutlich ca. 20 Euros heute entsprechen würde. Wenn also ein Österreicher täglich 20 Minuten BTX benutzte, dann kosteten die reinen Telefonkosten für das BTX pro Monat zusätzlich 200 Euro. Und das zu einer Zeit, wo man in den USA pro Monat nur einen Pauschalbetrag von ca. 10 Euro für beliebig lange Telefongespräche zahlte.

Es wurde den technisch mit BTX Beschäftigten, die zunehmend günstigen Zugriff zum entstehenden weltweiten Internet hatten klar, dass man auf neue Großrechner (in vielen Fällen unter UNIX), auf bessere Protokolle und auf vernünftige und ohnehin immer mehr verfügbare Personalcomputer zurückgreifen würde müssen.

Von den größeren Bestrebungen seien drei, die sich fast zeitgleich entwickelten, erwähnt. Das Projekt Gopher, das in erster Linie von Mark McCahill an der Universität Minnesota vorangetrieben wurde, das Projekt WWW das eine Vierergruppe am CERN vorantrieb, und

das Projekt Hyper-G (später Hyperwave) das auf mehrere Väter wie Ivan Tomek, Fritz Huber, Frank Kappe und mich selbst zurück geht.

Alle drei Systeme bauten auf dem Internet auf, mit etwas verschiedenen Protokollen. Gopher war, was Endgeräte und Serverkonfigurationen sehr liberal, und unterstützte auch die meisten gängigen Terminals bzw. PCs. Es erlaubte Links, Textsuche und hierarchische Gliederung der Daten, war also ein durchaus vernünftiges System. Es wurde 1990 vorgestellt.

Im selben Jahr erscheint er erste Zeitschriftenartikel über Hyper-G (5). Hyper-G bietet statt der starren hierarchischen Gliederung einen flexiblere „DAG“ Gliederung an, natürlich auch Links, Suche und vor allem „Daten zu den Daten“ (die man also heute als „Metadaten“ bezeichnen würde) und nach denen man auch suchen, aber auch Benutzerrechte vergeben kann. Damit kann ein und dasselbe Angebot für verschiedene Benutzer ganz verschieden aussehen. Weitere Datenstrukturen wie Cluster und Sequenzen erleichtern die Datenablagerung und Auffindung weiter. Vor allem aber sind alle Links bidirektional und sind nicht Teil des Dokuments: d.h. wenn ein Dokument seinen Ort (seine URL ändert) kann es alle darauf hinweisenden Links auf anderen Servern automatisch korrigieren: in einem Netzwerk von Hyperwave Servern gibt es die Meldung „es gibt diese Seite nicht mehr“ bei einem Klick auf ein Link nicht.

Es ist ein eigentümlicher Zufall, dass im selben Jahr am CERN der Vorschlag gemacht wird, ein System für wissenschaftliche Artikel anzulegen, das für die ganze Welt über das Internet abrufbar ist. Man beachte: Interaktivität jenseits von Abrufen und Mails wurde nicht als wesentlich betrachtet, neben Suchfunktionen würden Links und Menüs für den Zugriff voll ausreichen. Ein Auszug der Originalmail ist in Fig. 7 (Zitat) zu sehen:

WorldWideWeb: Proposal for a HyperText Project To: P.G. Innocenti, G. Kellner, D.O. Williams, P. Palazzi, N. Pellow, B. Pollermann, E.M. Rimmer From: T. Berners-Lee, R. Cailliau Date: 12 November 1990

Fig. 7.(Zitat): Der Vorschlag eine erste Version eines vernetzten Hypertextsystems zu implementieren

Mir erscheint diese Mail darum so wichtig, weil sie belegt, dass nicht Berners-Lee das WWW allein einführte, sondern ein Vierer-Team, dessen wohl wichtigster Mann (aber zweiter alphabetisch) Robert Cailliau war, und den Berners-Lee, sobald es bequem erschien, immer „vergaß“ zu erwähnen. Dies und nachfolgende Aktionen von Berners-Lee werden von Insidern als nicht besonders vornehm gesehen und haben Cailliau veranlasst, seine Version in dem Buch „How the Web was Born“ (6) fest zu halten, nur wird auch dieses Buch immer wieder verschwiegen. Die Welt hat eben abgestimmt, dass Bernes-Lee der große Erfinder des WWWs ist, und obwohl das nur sehr bedingt die Wahrheit ist wird es immer mehr zur Wahrheit, da anders lautenden Aussagen immer mehr vergessen werden. Mehr zur Fig.5, nämlich den gesamten Vorschlag:

Die drei Systeme: WWW, Gopher und Hyperwave laufen 1991 als erste Versionen. Von den Systemen ist WWW das einfachste, ist einfach zu installieren, und ist kostenlos. Gopher ist doch deutlich komplexer; auch dass die Administration der Universität bei den meist ohnehin kostenlosen Lizenzen eingreift ist bremsend. Hyperwave ist am weitaus mächtigsten, aber auch am kompliziertesten und obwohl „educational institutions“ das System gratis erhalten zahlen große Konzerne (für die es als Wissensmanagementsystem fast noch immer eine Geheimwaffe ist) schon größere Beträge an die Hyperwave.com.

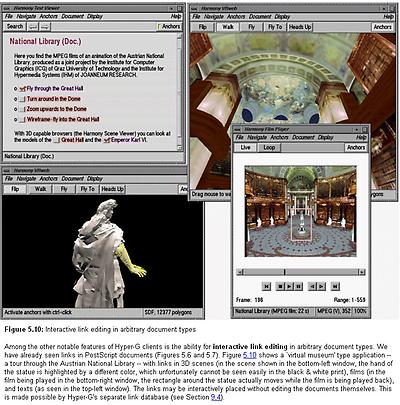

Fig. 8 zeigt das mächtige mehr-Fenster Editierwerkzeuge „Harmony“ von Hyper-G im Einsatz.

4. Der Durchbruch des WWW… und wie die USA die Führung übernehmen#

Im Jahr 1992/1993 hat Gopher weltweit über 50.000 Installationen, WWW einige hundert, Hyperwave einige wenige, allerdings diese bei großen Konzernen wie Boeing, Motorola, Siemens u.a.

Im Jahre 1993 entwickelte das NCSA (National Center for Supercomputing Applications) denn ersten echten grafischen Webbrowser für WWW. Betaversionen für die verschiedensten Betriebssysteme erschienen ab September 1993 und verbreiteten sich lawinenartig. Die Chefentwickler Eric Bina und Marc Andreessen sind damit maßgeblich für den Erfolg des WWW verantwortlich. Der Name Mosaic wurde in den Jahren 1993/1994 kurzzeitig fast zum Synonym für Webbrowser!

Gopher und Hyperwave wurden dadurch rasch in kleinere der Öffentlichkeit weniger bekannte Nischen zurückgedrängt. Die einfache und billige Handhabung der ersten WWW Server und Mosaic überzeugten mehr als einige der wichtigen konzeptionellen Ideen der anderen Systemen: Gopher und vor allem Hyperwave waren für den Einsteiger zu komplex, so wie BASIC für den Programmiereinsteiger geeigneter war als z.B. Pascal. Dass man aber in großen Konzernen mehr braucht als nur WWW Servers ist heute so wahr wie immer, wie die Firma hyperwave.com gut belegt.

Die WWW Hauptentwicklung lag 1993 noch bei CERN. Sowohl der EU wie der USA war aber inzwischen klar, dass hier ein Konsortium, „W3C“, das die weiteren Entwicklungen verfolgen sollte, notwendig sein würde. 1994 wurde am MIT das W3C gegründet und Berners-Lee als Leiter in die USA geholt[4].

Im selben Jahr kam es zu einem „Diskussionstreffen“ in Brüssel, bei dem erarbeitet werden sollte, welche Aufgaben Europa und welche die USA im W3C übernehmen sollten. Ich war als österreichischer Vertreter anwesend: es kam aber zu keiner Diskussion. Vielmehr legte die amerikanische Delegation ein fertiges Dokument auf den Tisch, in dem fast alles Rechte den USA übertragen wurden. Cailliau als Vertreter CERNs erklärte, dass dieses Dokument für CERN nicht akzeptable sei. Da erklärte sich eine andere europäische Forschungsorganisation bereit, die Rolle von CERN zu übernehmen. Einem bleichen Cailliau und uns anderen Europäern war damit klar: WWW war nun eine mehr oder minder US Angelegenheit.

Literaturangaben:

(1) H. Maurer, N. Sherbakov: HM Card; Addison Wesley, Bonn, 1995

(2) H. Maurer: Hyperwave; Addsion Wesley International, 1996

(3) Samuel Fedida & Rex Malik : The Viewadata Revolution; Associated Business Press, London 1979

(4) H. Maurer; Nationwide teaching through a network of microcomputers; IFIP World Congress 1986, Dublin, pp. 429-432

(5) H. Maurer, I. Tomek: Some Aspects of Hypermedia Systems and their Treatment in Hyper-G; Wirtscahftsinformtik 32 (1990), pp. 187-196 (6) J. Gilles & R. Cailliau: How the Web was Born: The Story of the World Wide Web; Oxford, 2000.

[1] Das Bild und eine Abhandlung, warum solche Buchräder durchaus als Vorläufer von Hypertext gesehen werden können finden sich in der Habilitation 1990 von Professor Keil von der Universität Paderborn, dem ich für seine Unterstützung danken möchte.

[2] Diese Idee stammt nach dem Wissen des Verfassers von DI Gerhard Greiner und dem Verfasser, und wurde ja viel später für das versenden von SMS mit numerischer Tastatur wieder entdeckt!

[3] Oder wie Insider wissen „Maurer Und Posch Intelligenter Decoder“

[4] Böse Zungen behaupten weil Berners-Lee alphabetisch vor Cailiau liegt und er daher zuerst das Angebot erhielt. In Wahrheit hatte Berners-Lee wohl nicht nur durch seine britischen Staatsbürgerschaft gegenüber der belgischen von Cailliau einen Vorteil, sondern hatte er schon vor der oben zitierten Email über den Wert von Hypertext für CERN spekuliert.