Die Misogynie der digitalen Welten #

Das Versprechen der Technologie war eigentlich, dass sie Unterschiede kleiner machen sollte, doch es passiert genau das Gegenteil. Mehr Diversität in den Algorithmen als Appell zum Weltfrauentag.#

Von der Wiener Zeitung (7. März 2023) freundlicherweise zur Verfügung gestellt.

Von

Gregor Kucera

Foto: https://pixabay.com

Das große Problem mit Erwartungshaltung ist, dass diese so selten erfüllt werden. So wurde stets erklärt, dass Technologie und Digitalisierung Gräben schließen und die Welt verbessern würden. Gräben zwischen Geschlechtern, Gehältern, Bildung oder Herkunft. Doch hat man vergessen, dass Menschen die Technologie entwickeln, programmieren und trainieren: Auch wenn Künstliche Intelligenz (KI), maschinelles Lernen, Algorithmen nach Objektivität, Fakten, in jedem Fall nach einer unvoreingenommenen schönen neuen Welt klingen mögen, so einfach ist es nicht. Im Digitalen gibt es Bias ("Vorurteile/Verzerrungen") gegenüber Personen, die nicht weiß, heterosexuell und männlich sind, genauso wie es sie in der Gesellschaft gibt. Nur weil etwas digital und nicht menschlich ist, heißt das nicht, dass es nicht diskriminiert. Diskriminierungen werden weitergeschrieben und in manchen Fällen sogar noch verschlimmert und verstärkt.

Stereotype gibt es massenhaft#

Beispiele gibt es dafür inzwischen zuhauf: Sprachassistenten mit weiblicher Stimme, die das Bild der Sekretärin weitererzählen und in die digitale Welt tragen, Kredite oder Versicherungen, die verweigert werden, Jobalgorithmen und -plattformen, die Frauen benachteiligen. Quasi alltäglich sind (Werbe-)Angebote, die nicht alle (gleich) zu sehen bekommen. Bemerkt wird das oft gar nicht, weil Transparenz in diesen Bereichen bisher Fehlanzeige ist. Doch das wäre aber die Voraussetzung für "gerechtere" Systeme und Entscheidungen. Das Problem beginnt schon in der Ausbildung: zu wenig Diversität in den IT-Abteilungen, keine Frauen, die Tools programmieren und wahrgenommen werden, und männliche Gedankenkonstrukte und Überlegungen, die den Apps und Maschinen zugrunde liegen. Die Programmierer sind von den Problemlösern zu Problemerschaffern geworden und der Weg hinaus aus diesen digitalen Stereotypen und Diskriminierungen scheint schwerer zu sein als gedacht.

Viel Diskriminierungspotenzial gibt es anscheinend im Personalwesen. So haben die Empfehlungsalgorithmen auf der Plattform LinkedIn Kandidatinnen in unbeabsichtigter Art und Weise systematisch schlechter bewertet als Männer. Hintergrund sei, dass sich Männern eher auf Stellen bewerben, die über ihre Qualifikationen hinausgehende Berufserfahrung erfordern, während sich Frauen vor allem bewerben, wenn ihre Qualifikationen den Anforderungen des Jobs ziemlich genau entsprechen. Der Algorithmus interpretierte dieses unterschiedliche Verhalten und passte seine Empfehlungen an, was dazu führte, dass Männern höhere Positionen empfohlen wurden. Man bedient sich teilweise jahrzehntealter Datensätze, der Algorithmus liest in denen die diskriminierenden Muster heraus und wendet genau diese dann auf die Zukunft an. Dies ist letztlich eine selbsterfüllende Prophezeiung, man setzt Vergangenheit und Zukunft in eins und leitet daraus die Zukunft ab.

Unsichtbar in der digitalen Welt. Frauen verschwinden in den Algorithmen. - © apa / dpa Unsichtbar in der digitalen Welt. Frauen verschwinden in den Algorithmen. - © apa / dpa

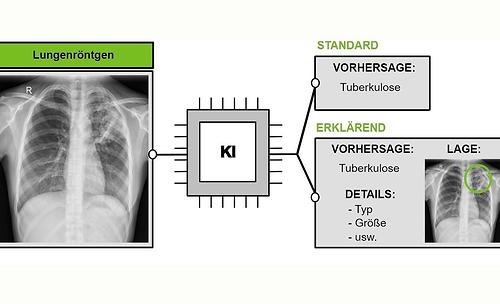

Nicht weniger als 48 Arten von Bias-Typen listet die Website anti-bias.eu auf. Einer ist der "Bias in Künstlicher Intelligenz", der auf unausgewogenen oder fehlerhaften Daten basiert und zu Diskriminierung führen kann. Ein Beispiel aus der medizinischen Forschung, denn hier gibt es ein Datenproblem. Die meisten Studien basieren auf weißen Männern. Bei intergeschlechtlichen Menschen gibt es virtuell keine Daten, nicht einmal Referenzen für Blutwerte. Das liege mitunter an der Wahrscheinlichkeitsmodellierung, denn alles basiert auf Wahrscheinlichkeiten, das ist der Kern. Wenn man eine ziemlich unwahrscheinliche Person ist, wird man immer ausgeschlossen.

Brust und Spiele#

In dieser Hinsicht ginge es nicht diskriminierungsfrei, das sei jedoch weniger das Problem, sondern sowohl unser bewusster wie auch unbewusster Umgang mit möglichen Diskriminierungen. Welche Rolle hat Technologie, das ist eine Frage mit normativem Charakter und da müssen wir uns fragen, was wir eigentlich wollen?

Besonders drastische Fälle von Misogynie finden sich in der Gaming-Branche. Hier fanden sich Frauen meist nur in zwei Rollen wieder - entweder als optischer Aufputz bei Spielemessen oder auch in den Spielen selbst, oder aber als zu rettender Nebencharakter. So befreite der Installateur Mario bereits 1981 heldenhaft seine Freundin Pauline aus den Fängen des bösen Affen Donkey Kong. Ein paar Jahre später, 1985, ist es dann (zum ersten, aber nicht zum letzten Mal) die hilflose, hübsch anzusehende Prinzessin Peach, die ihrer Errettung harrt. 1989 folgte ein Jump’n’Run-Spiel, in dem ein Abenteurer die namenlose Tochter des Sultans vor einem bösen Magier rettet und durch die Heirat mit ihr zum "Prince of Persia" wird. Mitte der Neunziger erobert dann Lara Croft die Computerbildschirme und Herzen der zum Großteil männlichen Spielerschaft. Als einer der ersten spielbaren weiblichen Charaktere kämpft sich die Archäologin vollbusig und knapp bekleidet durch die Welt. Ihre Oberweite verdankt sie - angeblich - einem Rechenfehler beim Design, die Doppel-D-Körbchen wurden aber zunächst beibehalten.

Das Stereotyp des Patriarchats setzt sich fort: Frauen parken schlecht ein, sind schlechte Programmiererinnen und auch schlechte Computerspielerinnen. Auch wenn sich mittlerweile einiges gebessert hat, es gibt noch viel zu tun. Kürzlich gab es erst Hass und toxische Spielermännlichkeit, weil eine Frau eine Hauptfigur in einem Computerspiel sein durfte, und dann, kurze Zeit später, als sich zwei Frauen auch noch küssten.

Wie lässt sich das Problem nun lösen? Zum einen muss die Entwicklung der KI schon anders als bisher aufgesetzt werden. Auch das Training der Maschinen muss ohne Vorurteile und Stereotypen erfolgen Es braucht verbindliche Regulierungen von "oben". Alle Augen sind daher auf den Artificial Intelligence Act der EU gerichtet, der derzeit als Gesetzesvorschlag vorliegt. Allerdings ist es noch ein langer Weg und bis dahin wird man auf Diskriminierung aufmerksam machen müssen.