Kurzer IT Lebenslauf#

Wie sich die IT doch änderte- ein sehr persönlicher Bericht#

H. Maurer, Sommer 2017Inhaltsverzeichnis

- Kurzer IT Lebenslauf

- Wie sich die IT doch änderte- ein sehr persönlicher Bericht

- Anfang in Wien

- Calgary, Kanada

- Regina, Kanada

- Zwischenstation Wien

- Kanada für immer?

- Karlsruhe

- Dynamisierung von Datenstrukturen

- Algol 68

- Kryptographie

- Das Institut in Karlsruhe mit internationalen Kooperationen

- Forschungsaufenthalte

- Graz

- Allgemein

- Wieder Dynamisierung

- Formale Sprachen

- MUPID und BTX

- Hyperwave

- Erfahrungen im Ausland

- Rückblick

- Eine Lückenbiographie

- Schlussbemerkungen

Anfang in Wien#

Ich begann mein Studium der Mathematik/Philosophie an der Universität Wien 1959: Informatik oder so gab es an der Uni Wien noch nicht, ich las nur ab und zu Wunderdinge über Computer in den Zeitungen. So besuchte ich ein Programmierseminar bei Professor Hofreiter (in dem wir nur Flussdiagramme zeichneten; einem Computer nahe kam ich nie; das Höchste war das Betätigen einer Brunswiga Rechenmaschine). Der Statistiker Dozent Roppert hielt auch eine kleine Vorlesung über Programmierung: Da schrieben wir tatsächlich kurze Programme, die nie getestet wurden.Ich war ein schneller Student, begann bereits Frühjahr 1962 mit meiner Dissertation (Zahlentheorie) bei Professor Hofreiter. Im selben Jahr war die erste große Computertagung im deutschsprachigen Europa in München. Neugierig fuhr ich hin, verstand wenig. Beim Dinner saß zufällig neben mir ein netter Herr aus Kanada: Nachdem er mich über das Studium ausgefragt hatte, bot er mir eine Stelle als Graduate Assistant ab Herbst 1962 in Calgary an. Der Mann war Professor Peck, einer der prominentesten Mitglieder der IFIP Algol Working Group WG 2.1.

Das war nun wirklich ein für mich exotisches und reizvolles Angebot. Ich kannte Calgary damals nur aus einer Geschichte im Kurier, wo über einen Mann berichtet wurde, der bei 40 Grad unter Null einen Eislaufplatz für seine Kinder anlegte, indem er einfach mit dem Schlauch eine Stunde lang die Wiese bespritzte... wobei das Wasser immer sofort gefror. Nur er passte nicht auf: Seine Schuhe froren ein, er konnte nicht mehr weg, aber auch die Schuhe nicht öffnen, weil die Schuhbänder ganz eingefroren waren. Seine Frau hörte zum Glück seine Hilferufe.

Mir gefiel diese "witzige" Geschichte. Sie sollte vier Jahre später weniger witzig sein, als ich selbst auf dieselbe Weise einen Schlittschuhplatz anlegte, und mich dann auch nicht mehr bewegen konnte!

Calgary, Kanada#

So kam ich Mitte Juli 1962 nach meiner ersten Flugreise (damals sehr familiär, mit kleiner Maschine und vielen Zwischenstopps: Shannon, Irland; Gander, Neufundland; Montreal, Quebec; Toronto, Ontario; Winnipeg, Manitoba; Saskatoon, Saskatchewan) nach Calgary. Professor Peck holte mich um 4 Uhr früh (!) persönlich ab: Er und seine Frau blieben Freunde bis zu ihrem Tod.

Calgary war damals eine 200.000 Einwohnerstadt in der sonst leeren Prärie, die sich nach Westen in die Rockies erstreckt. Heute ist Calgary eine Millionenstadt! Die Universität (damals noch Zweigcampus der University of Alberta) bestand aus zwei Gebäuden: Arts und Science. Der Computerraum, das Revier von John Peck, war im EG des Science-Buildings mit einer IBM 1620 mit Lochstreifenleser und Drucker.

Peck saß dort nächtelang, ich oft bei ihm, denn ich sollte ab Anfang September eine einführende Programmiervorlesung (Assembler) halten.

Der Crash-Kurs war erfolgreich. Meine Studenten berichteten später: "At the beginning your English was hard to understand; but we got used to it and liked the course."

Nach zwei Semestern Vorlesung bat ich Peck um Vermittlung für einen Sommerjob: Das Uni-Jahr in Kanada ist sehr intelligent geplant:

Es geht mit nur 2 Tagen Unterbrechung vom 1. September bis 31. März, d.h. man hat im Sommer 5 Monate Zeit, um sich genug Geld für das nächste Jahr zu erarbeiten.

Regina, Kanada#

Mein Sommerjob war als Programmierer/Analyst für die Regierung von Saskatchewan in Regina, 800 km östlich von Calgary, in der Prärie. Ich bin Peck ewig dankbar für diesen Job, ich lernte sehr viel.Der Hintergrund war, dass Saskatchewan 1963 die erste Provinz Kanadas mit einer sozialdemokratischen Regierung wurde, die als Wahlversprechen gratis medizinische Versorgung versprochen hatte (Obamacare 50 Jahre früher!). Nun musste aber ein Computerprogramm entwickelt werden, das die detaillierten Gesundheitsdaten für eine Million Einwohner verwaltete, damit z.B. ein Zahnarzt nicht die Plombierung eines Zahnes verrechnen konnte, der schon lange gezogen war.

Das war 1963 mit einer IBM 1410 und einem Dutzend Bandstationen eine noch kaum bewältigbare Aufgabe, für die eines der besten Programmierteams aus den USA geholt wurde, und einige junge Leute, wie mich, als Art Lehrlinge.

Kaum angekommen, gab man mir die dicke Liste eines Assemblerprogramms in die Hand um mich "einzulesen". Nach vielen Stunden war ich total verzweifelt und berichtete meinem Betreuer, dass das Programm anscheinend damit beginnt, drei Spalten von Sternen zu drucken, bis eine externe Unterbrechung eintritt, also etwas ganz Unsinniges macht. Er erklärte mir, dass das genau das Beabsichtigte war, denn so konnte man an Hand der Spalten von Sternen den Drucker so adjustieren, dass er die Formulare richtig bedruckte!

Es war eine aufregende Zeit des Lernens und der 70 Stundenwochen. Ein Problem plagte das Projekt: Das Programm stürzte immer wieder an verschieden Stellen „grundlos“ ab. Nachdem ich das Problem durch Zufall gelöst hatte, wurde ich als echtes Teammitglied anerkannt: Ich hatte bemerkt, dass beim automatischen Aufmachen der Eingangstür, wenn eine bestimmte der Bandeinheiten gerade benutzt wurde, die Fehler auftraten: diese spezielle Bandeinheit war so empfindlich, dass die kleine Schwankung der Spannung durch das elektrische Öffnen der Tür zu einem (unerwünschten) Rückspulen des Bandes führte.

Am 7. September 1963 um 4 Uhr, nach durcharbeiteter Nacht, verkündete der Leiter: „Wir sind fertig“.

Wir feierten, indem wir aus der Stadt hinausfuhren und bei einem großen Feld ohne zu fragen zwei Mähdrescher in Gang setzten und das Feld abernteten. Als um 6 Uhr der Farmer mit Flinte aus dem Haus trat, gab es einen bangen Moment. Aber der Farmer sagte nur: „Well done! Come in, you have earned yourself a breakfast“.

Aber eines muss ich noch erzählen: Ich wohnte in Regina nahe meines Arbeitsplatzes in einer kleinen Wohnung im 2. Stock einer schönen Villa. Die Bewohner wechselten dort oft, es gab im 2. UG Räume, die ich nicht betreten durfte. Obwohl ich kaum jemand kannte, wurde ich immer wieder zu Partys eingeladen. Ich dachte mir nie etwas dabei, auch nicht als ein Beamter der Regierung bei einer Party einmal sagte. „Oh, I did not know you are one of us“. Ja, ich war sehr naiv. Ich staunte nicht schlecht, als ich bei meiner ersten Einreise in die USA Probleme hatte, weil ich im Hauptquartier der kommunistischen Partei von Saskatchewan gewohnt hatte.

Im Oktober wollte ich, auch etwas wehmütig, nach Wien zurück: um den Doktor abzuschließen und um hoffentlich meine Jugendliebe Ursula überzeugen zu können, dass wir permanent zusammen sein sollten. Der Rückflug war zu teuer. So überquerte ich den Atlantik mit dem letzten regulären Linienschiff, der Homeric, in einem Oktobersturm in einer sechser Innenkabine von Montreal nach Le Havre, wo Ursula auf mich wartete.

Zwischenstation Wien#

Ein einfaches Untermietzimmer in Wien nahe des mathematischen Instituts war rasch gefunden, ich hatte meine Dissertation „fertig“ (glaubte ich) und genug Geld erspart, um bis zur erwarteten Promotion Juni 1964 durchzukommen. Aber dann kam die böse Überraschung: Mein Betreuer Professor Hofreiter war Rektor und: „Da habe ich keine Zeit für Dissertationen“. Professor Nöbauer wollte, dass ich ein ganz neues Thema behandle, er war kein Zahlentheoretiker.Das Geld wurde im Sommer 1964 knapp. Da war ich auch schon verheiratet und ein Baby unterwegs. Ich wusste nicht recht weiter. Da traf ich durch Zufall Werner Kuich, einen ehemaligen Studienkollegen (der wenige Jahre später Professor an der TU Wien wurde). Wir setzten uns auf ein Bier und er wusste Rat in meiner misslichen Lage: Im Forschungslabor der IBM (unter Professor Heinz Zemanek, wo er auch arbeitete) suchte man noch Mitarbeiter.

Kurios war auch die Entwicklung des Namens der Sprache. Die erste Version MPPL (Multi Purpose Programming Language) wurde bald verworfen und durch NPL (New Programming Language) ersetzt. Das rief bald ärgste Verlegenheit hervor, als in UK Zeitungen Anzeigen erschienen „NPL needs good programmers", als ob IBM nicht mit der Sprache zu Rande käme. Dabei stand in den Anzeigen NPL für „National Physics Laboratory"! In einer Notstandssitzung konnte man sich auf keinen Namen einigen, aber in den vorläufigen Manuals war ein Platzhalter notwendig: So hieß die Sprache eine kurze Zeit eben „***". Schließlich wurde „Programming Language One", PL/I, geboren. So heißt diese mächtige und komplexe Sprache (soweit sie noch verwendet wird) noch heute.

Bei der Doktorarbeit war Professor Hlawka meine Rettung: Er war bereit, mein Elaborat zu lesen, kommentierte es nach zwei Wochen mit: „Nette Publikation, aber zu wenig für eine Dissertation. Aber: Ich gebe Ihnen ein Thema im selben Gebiet, da müssen Sie sich nicht einarbeiten.“

Er stellte mir die Aufgabe, ein bis dahin ungelöstes Problem der Zahlentheorie zu lösen. Ich stürzte mich darauf und wusste bald: Ich kann das Problem lösen! In intensiver Arbeit schrieb ich einen 60 seitigen Beweis, den Hlawka als Dissertation anerkannte. Viel später erfuhr ich, dass er den Beweis schon selbst gefunden hatte: Er gab oft Themen für Dissertationen aus, deren Lösung er kannte. So konnte er die Forschungsfähigkeiten seiner Schützlinge besonders gut einschätzen. Ich konnte diese Methode später auch manchmal als Doktorvater anwenden.

Ich promovierte im Juni 1965. Bei IBM ging es inzwischen um die formale (= exakte) Definition von PL/I. Für Fachleute: Für mich war klar, dass die Definition der Syntax mit Backus-Naur-Form leicht möglich sein würde. Die Definition der Semantik schien mir aber bei einem Ungetüm, wie es PL/I ist, schier unmöglich. Ich unterschätzte dabei das Management von Dr. Kurt Walk und die Genies Peter Lucas (den ich 30 Jahre später als Professor an die TU Graz holen würde) und Hans Bekic (der durch einen Unfall ums Leben kam). Aber so gelang es doch im Laufe mehrerer Jahre, nicht nur PL/I formal zu beschreiben, sondern die Vienna Definition Language zu entwickeln, die bis heute unter Formal Methods Europe überlebt: Dass etwas in der Informatik nach mehr als 40 Jahren noch immer aktuell ist, ist mehr als ungewöhnlich und spricht für die Talente der von den drei Erwähnten geleiteten Gruppe. Zu dieser Gruppe gehörte ich nicht mehr.

Kanada für immer? #

In den folgenden 5 Jahren beschäftigte ich mich mit Automatentheorie und der Theorie Formaler Sprachen, veröffentlichte einiges, betreute die ersten Studenten und publizierte 1969 das erst deutschsprachige Buch über „Theorie der Programmiersprachen“, sprich formale Sprachen.

Besonders faszinierten mich mehrdeutige Sprachen: Salopp gesagt sind das Sprachen, bei denen es für gewisse Sätze keine eindeutige Grammatik geben kann. Solche "Unmöglichkeitssätze" sind ja Ergebnisse, die erstmals um 1936 durch Ergebnisse wie die Unentscheidbarkeit des Halteproblems von Turing entdeckt wurden und die zunächst jeder Intuition widersprechen. Denn dass Klassen von Problemen existieren, für die es keine Methode gibt, die für jedes Problem in der Klasse feststellt, ob es lösbar ist oder nicht, bedeutet, dass niemand, auch nicht der superintelligente Außerirdische oder der liebe Gott, je eine solche Methoden finden kann... eines der großen, tiefen und überraschenden Ergebnisse der Logik bzw. Informatik des 20. Jahrhunderts.

Einige bekannte Informatiker und Freunde besuchten mich in Calgary: Allen voran muss ich meinen ehemaligen Chef Heinz Zemanek und meinen Freund Werner Kuich aus Wien erwähnen. Kuich und Salomaa revolutionierten mit ihren "Formalen Potenzreihen" (die in einem großartigen Buch erklärt werden) die Arbeitstechnik in diesem Gebiet grundlegend: Es war ein Vergnügen, da am Rande mitwirken zu können.

Mein Buch mit Mike Williams „A collection of programming problems and techniques“ verbreitete sich wegen der Sprache und Anwendungsnähe in Nordamerika recht gut, so dass ich gar nicht registrierte, dass ich über mein deutsches Taschenbuch in Deutschland bekannt wurde.

Da rief mich der Herausgeber meines Buches, Professor Kulisch aus Karlsruhe beim Frühstück an, ob ich mich nicht für eine Professur in Karlsruhe bewerben wollte.

Um die lange Geschichte kurz zu machen: Wir hatten in Calgary gerade ein Haus gekauft, liebten Kanada, ich konnte für die Staatsbürgerprüfung schon die Hymne singen: Uns zog es nicht zurück nach Europa.

Aber das Angebot war letztendlich so gut, dass wir beschlossen, mich zwei Jahre in Kanada beurlauben zu lassen und Karlsruhe auszuprobieren.

Wir krönten unsere Zeit in Nordamerika mit einem damals $99.- Ticket für beliebige Flüge in den kontinentalen USA. Also flogen wir ganz nach Norden an die Beringstraße, dann über viele Stopps nach New Orleans und Florida, und schließlich nach Europa.

Karlsruhe#

So trat ich meinen Dienst als C4 Professor (die höchste Kategorie und mit sagenhaften Bedingungen) zu meinem dreißigsten Geburtstag 1971 an. Erst allmählich verstand ich, warum ich berufen worden war: Die deutsche Regierung hatte den Beginn eines großen Informatikprogramms beschlossen, nur gab es damals einfach nicht genügend gut qualifizierte Kandidaten in Deutschland, so dass ich im Vergleich gut abschnitt, auch wenn man mit ähnlichen Voraussetzungen niemanden in den klassischen Disziplinen berufen hätte!Als ich das verstand, erwachte mein Ehrgeiz. Auch fanden wir Europa und die Nähe der Familie und von Freunden wieder sehr viel schöner als erwartet, sodass ich in Kanada kündigte.

Ich begann nicht nur in der Theorie, sondern auch im Bereich „Datenstrukturen und Programmierverfahren“ zu arbeiten. Mein Buch mit diesem Titel im Teubner Verlag 1974 war ein Erfolg und wurde in mehrere Sprachen übersetzt, darunter eine Raubübersetzung ins Chinesische.

Dynamisierung von Datenstrukturen#

Bei den Datenstrukturen ging es hauptsächlich um „Dynamisierungsfragen“. Um das zu erklären muss ich ein bisschen ausholen und die in der Literatur als „Wörterbuchproblem“ bekannte Aufgabe erläutern: Wenn man in einem Wörterbuch nach einem Wort sucht, findet man das nur darum rasch, weil die Wörter alphabetisch angeordnet sind. Mit der in der Informatik meist empfohlenen Methode schlägt man ungefähr in der Mitte auf, hat dann vielleicht durch Zufall das gesuchte Wort gefunden, ansonsten kann man die Suche auf die vordere oder hintere Hälfte einschränken. Man fährt dort fort, hat dann nur mehr ein Viertel zu betrachten, usw. Im Jargon der Informatiker nennt man das „binäres Suchen“.Als Mensch geht man wohl intelligenter vor. Wenn ich ein Wort habe, das mit A anfängt, werde ich kaum in der Mitte aufschlagen, sondern weit vorne, und dann weiter machen, usw. Diese Methode habe ich als „Interpolationsmethode“ auch für Computer in einer meiner ersten Publikationen vorgeschlagen und an Hand von vielen Beispielen als effizienter belegt. Aber es ist erst 30 Jahre später anderen gelungen nachzuweisen, dass dies Methode mit Ausnahme einiger entarteter Fälle immer sehr viel schneller ist. Für Spezialisten: Das Resultat kann in log log n Schritten statt mit binärer Suche in log n Schritten gefunden werden.

Vereinfacht kann man sich den Speicher eines Computers vorstellen als hintereinander liegende Speicherzellen, von denen jede einen Datensatz enthalten kann. Legt man jetzt also die Datensätze einer Kundendatei hintereinander nach Kundennahmen alphabetisch sortiert in aufeinanderfolgende Speicherzellen an, so kann man binäres Suchen anwenden und in n Schritten einen Kunden unter 2n Kunden finden, also z.B. mit nur 16 „Computeroperationen“ jeden Kunden in einer Datei mit ca. 65.000 Kunden (!) finden, weil ja 216 = 65.536 ist. Freilich, die Kundenbasis ist nie stabil: Es kommen neue dazu, existierende verschwinden.

Will man nun aber einen neuen Kunden neu anlegen (also „einfügen“), dann ist die gewünschte Speicherzelle meist schon belegt, man muss daher vielleicht tausende Kundensätze verschieben, also tausende Computeroperationen durchführen. Und ähnlich ist dies, wenn man einen Kunden entfernen will, denn um ein „Loch“, eine unbelegte Speicherzelle, zu vermeiden, müssen potenziell viele Kundensätze verschoben werden. Mit anderen Worten, bei der Anordnung der Kundensätze in alphabetischer Reihenfolge findet man einen Kundensatz schnell, bezahlt dies aber mit sehr großem Aufwand bei der Veränderung des Bestands von Kunden. Bis Anfang der sechziger Jahre plagte diese Tatsache viele große Anwendungen. Natürlich entwickelte man einige Tricks, die die Situation verbesserten, befriedigend waren sie nicht.

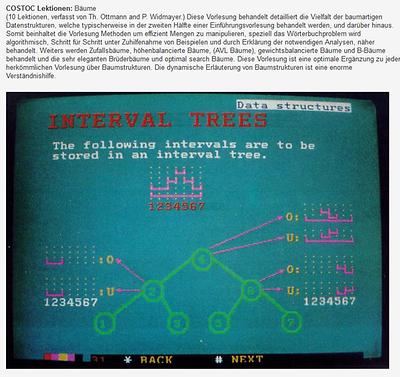

Dann gelang es 1962 den Russen Adelson-Velskii und Landis eine Methode zu finden, die es ermöglichte, fast so rasch wie beim binären Suchen Datensätze zu finden, aber auch genau so rasch Datensätze einzufügen und zu entfernen! Die Arbeit war russisch verfasst. Bis sie im westlichen Sprachraum verfügbar war und das Staunen bzw. die Schockstarre überwunden war, vergingen fast 10 Jahre: Die Struktur heißt den Erfindern zu Ehre „AVL-Baum“ und er erlaubt die effiziente Dynamisierung des Problems, d.h. dass man auch rasch mit sich dynamischen ändernden Datenbeständen arbeiten kann. Meinem Karlsruher Team sind nicht nur massive Verbesserungen durch neue Strukturen gelungen (vor allem Thomas Ottmann und mir), es wurden auch über das Wörterbuchproblem hinausgehende Aufgabenstellungen untersucht und teilweise gelöst.

Wieder sehr vereinfacht ausgedrückt: Es gibt viele Situationen, wo man in einem Datenbestand etwas rasch finden kann, wenn dieser sich nicht verändert und entsprechend vorstrukturiert wurde. Kaum kann sich der Datenbestand aber ändern, wird die Situation knifflig: Das steckt hinter den angesprochenen Dynamisierungsfragen.

Hier darf ich wieder über ein persönliches Erlebnis berichten: Ich kam nach einem Flug von Kanada übernächtig und müde in Frankfurt an und setzte mich in den Zug nach Karlsruhe. Fast schlief ich ein, da kam mir auf einmal eine Idee, wie man viele Arten von Dynamisierungsproblemen mit ein und derselben Methode lösen kann. Ich nahm Block und Bleistift und begann, die Idee zu konkretisieren. Ich war so vertieft, dass ich fast vergaß, in Karlsruhe auszusteigen. Ich hatte aber halb schlafend einen echten Durchbruch erzielt. Was dann folgte, war auch interessant: Ich veröffentlichte ganz rasch das Prinzip, ohne es erst auf Dutzende offene Probleme anzuwenden. Kollegen aber taten dies und wurden dadurch bekannt: Dass sie mein allgemeines Prinzip verwendeten, wurde oft nicht einmal erwähnt. Well, that’s life!

Mein Prinzip löste viele, aber bei weitem nicht alle Dynamisierungsprobleme, wie ich im Abschnitt über Graz noch berichten werde.

Algol 68#

Eine besondere Freude machte es mir, dass ich jenen Mann, der mich seinerzeit nach Kanada geholt und in die Informatik eingeführt hatte, Professor John Peck, als Gastprofessor nach Karlsruhe holen konnte. Er war damals tief in die Entwicklung der Programmiersprache Algol 68 involviert. Es benötigt Monate, um die schönen und komplexen Konzepte der Sprache und ihrer Definition zu verstehen. Aber investierte man diesen Aufwand, so wurden viele Aspekte bei Programmiersprachen plötzlich sonnenklar. Ich bereitete mein Team ein halbes Jahr durch Seminare auf den Besuch Pecks vor. Es war ein Vergnügen zu sehen, dass Peck eine Arbeitsgruppe vorfand, die er sich nie hatte träumen lassen. Freilich, Algol 68 erwies sich als so komplex, dass es sich in der Praxis nicht durchsetzte und von viel weniger eleganten Sprachen wie Pascal überholt wurde. Dass das Beste sich vor allem bei Neuerungen oft nicht durchsetzt erlebt man leider immer wieder: Man denke nur an den Sieg von VHS über bessere Videostandards im schon vergangenen Zeitalter der Videorecorder.Einige Jahre später sollte ich mit einer "hauseigenen" Entwicklung dies auch erleben: Das beste vernetzte Multimedia-System und -Konzept, das es je gab (und noch immer gibt), Hyperwave, hatte gegen die primitiveren WWW Systeme keine Chance, da die Vorteile von Hyperwave erst bei sehr großen Anwendungen zum Tragen kommen. Etwas mehr dazu später!

Kryptographie#

Während meiner Zeit in Karlsruhe bahnte sich eine Umwälzung in der Kryptographie an, die ich verfolgte und mit der ich mich auch forschungsmäßig beschäftigte. Um zu erklären, worum es geht, muss ich ein bisschen ausholen (bitte bei Nichtinteresse erst bei der nächsten Überschrift weiter lesen).

Kryptographie, die Kunst der Verschlüsselung, ist tausende Jahre alt: Es geht dabei darum, ein Textstück so abzuändern, dass nur der intendierte Empfänger es bzw. die in ihm enthalten Botschaft lesen kann. (Es gibt auch andere Methoden der „geheimen“ Kommunikation, wie unsichtbare Tinte, die man irgendwie sichtbar machen kann. Darum geht es hier nicht.)

Bei allen klassischen Verschlüsselungsverfahren gilt: Weiß man, wie eine Botschaft verschlüsselt wurde, dann kann man sie auch entschlüsseln. Am einfachsten ist das mit dem „Caesar’s Cypher“ zu erklären:

Da ersetzt man jeden Buchstaben einfach durch einen alphabetisch folgenden mit einem gewissen Abstand: Also z.B. bei Abstand 5, A durch E, I durch M, Z durch D (d.h. am Ende des Alphabets macht man mit den Anfang des Alphabets weiter). Weiß man aber, dass mit dieser Methode und mit welchem Abstand verschlüsselt wurde, dann ist das Entschlüsseln natürlich ganz einfach, man muss ja jeden Buchstaben nur durch den im Alphabet im gegebenen Abstand früher liegenden ersetzen.

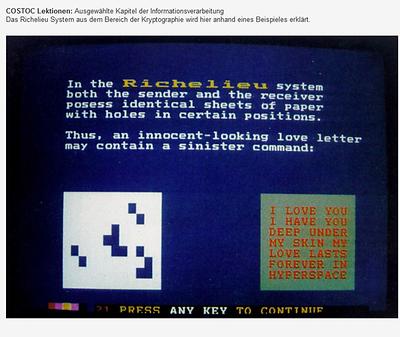

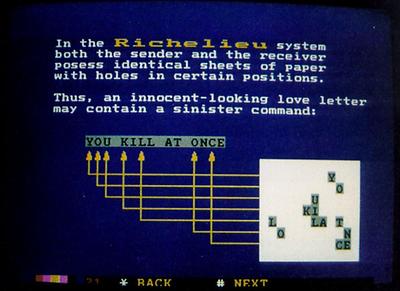

Gleichgültig wie komplex andere Verfahren auch sein mochten (auch Verfahren mit Masken, wie hier gezeigt), Kenntnis des Verfahrens der Verschlüsselung (in den Bildern: Kenntnis der Maske) bedeutete traditionell eben, dass die Entschlüsselung möglich war. Das galt als selbstverständlich und wurde daher bis ungefähr 1960 auch nie weiter untersucht..

Vor 1970 tauchte erstmals da und dort spekulativ die Idee auf, dass es doch vielleicht möglich sein könnte Verfahren zu entwickeln, bei denen man die Verschlüsselungsmethode öffentlich bekannt geben kann, ohne damit die Entschlüsselung möglich zu machen.

Der erste substantielle Beitrag dazu (der auch außerhalb von Geheimdienste lesbar war), der auch die Konsequenzen untersuchte, stammt von W. Diffie und M. Hellmann 1976 in einer Publikation von IEEE. Sie konnten keine überzeugende praktische Methode angeben, aber argumentierten, warum eine solche denkbar wäre, und sagten: "Nehmen wir an, es gibt eine Methode M, die auf zwei Schlüsseln beruht, auf einen V den man öffentlich machen kann, und der zum Verschlüsseln dient und einem dazu passenden Schlüssel E, der das Entschlüsseln erlaubt, der aber von V ( das ist das Entscheidende) nicht ableitbar ist." Sie zeigten, das sich daraus unglaubliche Möglichkeiten ergeben, von denen ich nur die zwei einfachsten kurz erkläre. (Für eine sehr schöne Darstellung der Kryptographie, und besonders der gerade erwähnten „Public Key Cryptography“, empfehle ich das Buch „Public Key Cryptography“ von A. Salomaa, Springer Verlag 1990.)

Nehmen wir zwei Personen A und B, die sich der Methode M bedienen. A und B haben einen öffentlichen Schlüssel („public key“) VA bzw. VB , der öffentlich bekannt ist. Sie haben ferner einen nur ihnen bekannten dazugehörigen Schlüssel EA und EB. Will nun jemand eine geheime Botschaft x an A schicken, dann verschlüsselt er diese mit der Methode M und Schlüssel VA. Er schickt, so wollen wir das schreiben, die Botschaft y= M(VA,x), also die Methode M angewandt auf x mit dem öffentlichen Schlüssel VA. Jeder kann eine so verschlüsselte Botschaft senden, aber nur A hat seinen geheimen Schlüssel EA zum Entschlüsseln von y. Indem er also M auf y mit Schlüssel EA anwendet, bekommt er wieder die ursprüngliche unverschlüsselte Botschaft x, also M(EA, y)= M(EA, M(VA, x)) = x. Die Entschlüsselung hebt also die Verschlüsselung auf, und nur A kann dieses Aufheben bewirken, denn nur A kennt EA. Freilich, A weiß nicht, vom wem die Botschaft kommt: jeder kann ja x mit M und VA verschlüsseln. Aber B kann anders vorgehen. Er schickt nicht einfach M(VA,x), sondern M(VA, M(EB,x)) (!!). Nun kann A darauf M mit seinem Entschlüsselungsschlüssel EA anwenden, erhält damit M(EB,x), und indem er darauf M mit dem öffentlich bekannten Schlüssel VB anwendet, erhält er x. Aber da nur die Person B den Code M(EB,x) erzeugen kann (nur B kennt EB!) wurde x nicht nur sicher übermittelt, sondern A weiß auch mit Sicherheit, dass die Botschaft von B kommt!

D.h. mit öffentlichen Schlüsseln können Botschaften/Dokumente nicht nur sicher, sondern unterschrieben, mit einer „Digitalen Signatur“, übermittelt werden. Viel mehr ist möglich (siehe z.B. das erwähnte Buch) soll aber hier nicht weiter erklärt werden.

Die obige längliche Darstellung habe ich gebracht, weil ich auch in dieser Richtung geforscht habe und dabei etwas Unangenehmes erlebt habe. Wenn man für verschiedenste Aufgaben und Personen public keys verwendet, muss man sich manchmal viele verschiedene Entschlüsselungsschlüssel merken (wie uns das mit Passworten ja immer wieder passiert). Der berühmte Theoretiker K. Culik II und ich haben eine Variante entwickelt, die das vermeidet. Der Artikel wurde publiziert und wohlwollend aufgenommen. Drei Jahre später zeigte der Mathematiker Walter Knödel in Stuttgart, dass unsere Methode nicht sicher war!!

So publizierten wir dann eine abgemagerte richtige Version, doch zeigt diese Richtigstellung die Problematik gedruckter Publikationen: Der ursprüngliche Artikel würde falsch für immer bestehen bleiben… und wie sollte ein Leser je auf die Idee kommen, in viel späteren Ausgaben der Zeitschrift nach einer Korrektur zu suchen? Das ist der Grund, warum wir (Calude, Salomaa und ich) beim späteren Start der elektronischen Zeitschrift JUCS die Möglichkeit vorgesehen haben, auch bei Beiträgen der Vergangenheit diese zwar nicht abzuändern, aber durch einen Kommentar zu ergänzen. In unserem Fall wäre das ein Hinweis auf die später erschienene korrigierte Fassung.

Vollständigkeitshalber sei erwähnt, dass das erste gute und heute stark verwendete Verfahren für public keys RSA Verfahren heißt (zu Ehren der Erfinder Rivest, Shamir und Adelmann, 1998) und auf der Tatsache beruht, dass die Zerlegung sehr großer Zahlen in Primfaktoren heute noch immer praktisch (d.h. in vernünftiger Zeit) unmöglich ist, und bleiben wird, bis vielleicht eines Tages Quantencomputer das ändern könnten.

Das Institut in Karlsruhe mit internationalen Kooperationen#

Das Institut in Karlsruhe entwickelte sich insgesamt gut, nicht zuletzt durch die freundschaftliche, kollegiale Institutsleitung mit Woffried Stucky. Siehe dazu seine umfangreiche Bericht 50 Jahre AIFB.

Aus einer Reihe meiner dortigen Mitarbeiter wurden später bekannte Informatiker, wie etwa die Professoren Thomas Ottmann in Freiburg, Jürgen Albert in Würzburg, Lutz Wegner in Kassel, Hans-Werner Six und Gunther Schlageter in Hagen, oder Mitarbeiter in den höheren Etagen der Computerbranche, wie etwa Klaus Reinhardt bei SAP.

Sehr viel verdanke ich den hervorragenden Forschern, die als Gäste nach Karlsruhe kamen um gemeinsam zu arbeiten, allen voran Arto Salomaa aus Finnland. Mit diesem bedeutendsten Theoretiker Europas entwickelte sich eine wunderbare Zusammenarbeit und eine lebenslange Freundschaft. Das gilt gleichermaßen für Gregorcz Rozenberg und den leider viel zu früh verstorbenen Derick Wood.

Rozenberg verdanke ich, dass er mich in L-Systeme einführte, ein Konzept, das sowohl in der Biologie als auch bei den formalen Sprachen sehr wichtig wurde und uns zusammen arbeiten ließ. Noch mehr bin ich ihm dankbar, dass ich ihn wie Arto zu meinen besten Freunden rechnen darf und so berichte ich hier im Vorgriff über die gemeinsame Geburtstagsfeier für beide in Turku, Finnland im Juni 2017: Sie fand nach einer Komplexitätstagung statt, was vielen Freunden das Mitfeiern erleichterte. Natürlich haben meine Frau und ich ein paar Tage Urlaub in Finnland angehängt, und dabei den versteckten Ort Matilda kennengelernt, in den und dessen Umgebung und Geschichte man sich einfach verlieben muss.

Ich hatte die Chance, dass ich in Karlsruhe und später in Graz mit so vielen hervorragenden Forschern zusammen arbeiten und von ihnen lernen konnte, dass ich unmöglich auch nur einen Teil erwähnen kann. Aber meine lange Publikationsliste zeigt deutlich meine wichtigen Kooperationspartner, mit denen ich auch noch mehrere Bücher verfassen konnte. (Eine Liste meiner 200 wichtigsten Publikationen findet sich bei der Academia Euopaea).

Forschungsaufenthalte#

In die Zeit in Karlsruhe fiel auch mein erstes Freisemester, das mich nach Australien führte. Auch verbrache ich einen Gastaufenthalt an mehreren Universitäten in den USA (etwas mehr dazu in meinem Lebenslauf) und wurde mit einer interessanten Aufgabe vom deutschen auswärtigen Amt in Brasilien betraut:An der Universität der Hauptstadt Brasilia war ein Streit entstanden, wer mit dem Aufbau der Informatik betreut werden sollte:

Das Rechenzentrum? Die Mathematiker? Die Physiker? Die Elektrotechniker? Die Wirtschaftswissenschafter? Eine neue Gruppierung?

Ich hatte die interessante und schönen Aufgabe mit einer Dolmetscherin die Informatikeinrichtungen in allen wichtigen Informatikuniversitäten in Brasilien zu besuchen (damals: zwei in Rio, je eine in Sao Paulo, Campinas landeinwärts von Sao Paulo, und Porto Alegre in Rio Grande do Sul) und dann mit den Kollegen in Brasilia einen gemeinsamen Vorschlag, den alle unterstützen sollten, auszuarbeiten. Trotz langer Diskussionen ging das alle einfacher als erwartet: alle unterschrieben das ausgearbeitete Konzept.

Ich schloss meine Südamerikareise mit einem Gastbesuch an der Universität in La Paz und einigen touristischen Stopps ab und kehrte befriedigt nach Karlsruhe zurück. Wenige Wochen später brach der Streit in Brasilia wieder aus. Man hatte mit meinen Ideen nur mitgemacht, weil man wusste: „Der ist bald wieder weg, dann können wir wieder machen was wir wollen.“

1977 erhielt ich einen Ruf als erster Informatikprofessor an die TU Graz. Sollte ich die dann schon blühende Karlsruher Informatik (damals schon 8 Professoren) verlassen?

Graz#

Allgemein#

Neben persönlichen Gründen gab es aber in Graz nicht nur die Herausforderung, eine Informatik von Grund auf neu aufzubauen, sondern auch eine ungewöhnliche Konstellation, nämlich Professor an der TU zu werden, aber gleichzeitig bei JOANNEUM RESEARCH mitzuwirken, und damit Möglichkeiten zu bekommen, die einem als Professor nicht zur Verfügung standen.So akzeptierte ich zur Verblüffung meiner Kollegen das Angebot „in die Nähe des Balkans“ zu übersiedeln und habe das nie bereut.

Die Zeit 1959- 1997 ist unter "Not only theory" gut dokumentiert.

In Graz konnte ich von Professor Florian zwei Mitarbeiter übernehmen: Günter Haring, der später Professor an der Uni Wien wurde und Reinhard Posch, den ich später als zweiten Professor für Informatik an der TU Graz durchsetzen konnte und der mich im Laufe seiner Karriere weit überholte. Er ist heute CIO unserer Bundesregierung, aber nach wie vor in Graz aktiv.

Die ersten zwanzig Jahre in Graz waren besonders spannend. Einerseits, von der Seite des Aufbaus der Informatik, andererseits aus der Sicht der Forschung. Da verfolgte ich mit jungen, aber sehr begabten Mitarbeitern, sowohl neue Aspekte der Datenstrukturen weiter, wie in Karlsruhe angefangen, als auch formale Sprachen aber auch e-Learning und Medientechniken. Möglich wurde hochkarätige Forschung vor allem, weil das Ministerium (Ministerialrätin Dr. Barbara Borek) in den Berufungsverhandlungen zugesagt hatte, dass ich außergewöhnliche Wissenschafter aus aller Welt auf kurze Forschungsaufenthalte nach Graz einladen durfte. So hatten wir in den ersten 20 Jahren wohl mehr als 200 der besten Informatiker an der TU Graz. Die gesamt Liste kann man in der erwähnten Dokumentation von Sammer nachlesen, aber einige Namen seien hier doch beispielhaft erwähnt:

Albert (D), Azuma (Japan), Barth (D), Bentley (USA), Bode (D), Brauer (D) , Brzozowski (Kanada), Cailliau (Fr), Calude (NZ), deBakker (NL), Engeler (CH), Cremers (D), Gillard (Kanada), Ginsburg (USA) , Havel (CZ), Hule (Brasilien), Kulahturamaiyer (Malaysien), Makedon (USA), Marchionini (USA), Matula (USA), Nagl (D), Neuhold (D), Nivat (Fr), Ottmann (D), Patcchauri (Indien), Paz (Israel), Poole (Australien), Preparata (USA), Reusch (D), Rozenberg (NL), Salomaa (Finnland), Stucky (D), Subborough (USA), vanLeeuwen (NL), Wegner, L. (D), WEgner, P. (USA), Witten (Neuseeland), Wotschke (D), Wood (Kanada), Zima (D),...

Eine weitere ganz wichtige Unterstützung kam von Sektionschef Dr. Norbert Rozsenich, der vor allem bei den Forschungs-und Entwicklungsarbeiten um MUPID/BTX und Hyperwave (s.u.) mein Institut wesentlich unterstützte, und nur durch ihn die Entwicklungen überhaupt möglich waren.

Wieder Dynamisierung#

Bei den Datenstrukturen stand die „Dynamisierung von Verfahren“ im Vordergrund. Wie in dem Abschnitt über Karlsruhe erklärt, gelang da bei einfachen („linearen“) Strukturen ein gewisser Durchbruch. Es war die Frage, ob bei mehrdimensionalen Strukturen auch Fortschritte möglich sein würden.Diese Stoßrichtung verfolgte ich mit meinem Team in Graz. Während es bei Problemen wie dem Wörterbuchproblem ja nur um eine zu suchende Eigenschaft geht, gibt es häufig mehr als eine: Das können die geographische Koordinaten eines Punktes auf der Erde sein (also nicht ein eindimensionales, sondern ein zweidimensionales Problem), aber auch viel höhere Dimensionen treten leicht auf, wo sie vielleicht nicht so auf der Hand liegen, man nehme nur die Temperaturmessungen von Personen zu bestimmten Zeitpunkten (mindestens drei Dimensionen!), usw.

Bei der Behandlung von Datenstrukturen gibt es viele Probleme geometrischer Natur, die schon an sich nicht einfach sein mögen, durch Dynamisierung aber oft bis heute nicht effizient gelöst werden können. Das einfachste bis heute nicht befriedigend gelöste Problem dieser Art ist das „Postamtproblem“, über das man jederzeit im Internet nachlesen kann und das ich hier übergehe.

Aber um doch eine Idee zu vermitteln, worum es geht, beschreibe ich kurz das „Museumswächterproblem“: Wir haben einen große Ausstellungsraum von Bildern, die an diversen Wänden hängen, wodurch viele Teilbereiche entstehen, wobei man von einem Teilbereich an der richtigen Stelle auch große Teile eines anderen Bereichs sehen kann. Wie viele Personen muss ich wo platzieren, dass jedes Bild im möglichen Blickfeld mindestens eines Wächters liegt? Und, Dynamisierung, wie sieht das aus, wenn Wände und Bilder verschoben, entfernt oder hinzugefügt werden?

Die wohl heute als erfolgreichste Person in diesem Bereich anerkannte Person, die bei mir Diplom- und Doktorarbeit machte, ist Herbert Edelsbrunner (Bild und Info siehe weiter unten), aber besonders stolz bin ich auch auf Franz Aurenhammer, der das wichtigste Werkzeug für Untersuchungen in der „algorithmischen Geometrie“ in seiner Habilitationschrift so gründlich erforschte, dass die Publikation in „Computing Surveys“ der C.ACM noch immer DIE Standardarbeit über Anwendung von Voronoi-Diagrammen ist, auch wenn er (nun schon langjähriger Professor an der TU Graz nach einem Berliner Intermezzo) inzwischen viele weiteren Gebiete professionell abdeckt.

Formale Sprachen#

Meine Anfangszeit in Graz war auch der Höhepunkt meiner Karriere im Bereich formale Sprachen, in einem Gebiet wo ich in der MSW Gruppe (MSW= Maurer, Salomaa, Wood) Mitautor bei dutzenden interessanten Publikationen sein durfte, wo Arto Salomaa sicher die wichtigste Rolle spielte und immer, wenn es nicht weiter zu gehen schien, doch eine Lösung fand. Die enge Kooperation mit Rozenberg (den ich als phantasiereichsten Forscher der Welt schätzen lernte) und Karel CuliK II (der genial, aber schlampig, das lange offene DOL Sequence Equivalence Problem löste) darf ich hier stellvertretend für die vielen hochkarätigen Forscher, die ich (durch Unterstützung von Ministerialrätin Dr. Barbara Borek) nach Graz bringen konnte, nennen.Aber einen meiner Ex-Mitarbeiter, den ich für einen der genialsten Theoretiker überhaupt halte, muss ich getrennt erwähnen: Emo Welz. Mit ihm und Arto Salomaa gelang mir ein tiefer theoretischer Beweis über bestimmte formale Sprachen, der- wie wir erst Jahre später verstanden-, ein Jahrzehnte lang offenes Problem der Graphentheorie löste!

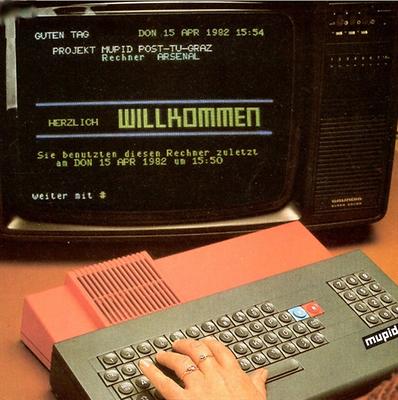

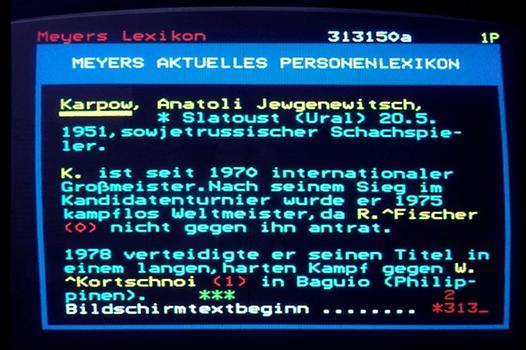

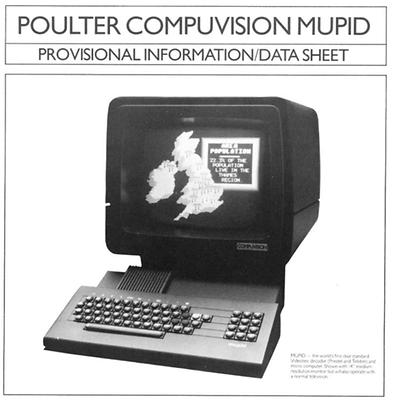

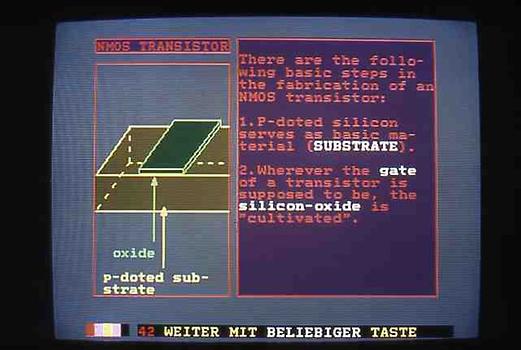

MUPID und BTX#

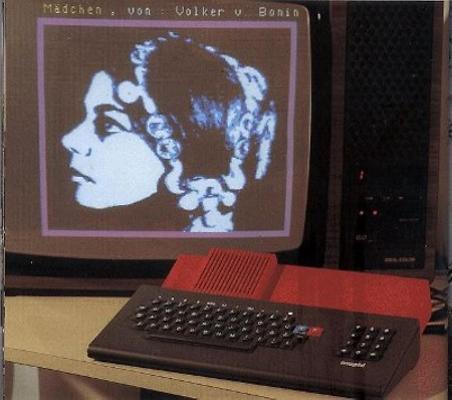

Der Durchbruch für die Informatik in Graz gelang Posch und mir mit der Entwicklung eines netzfähigen, programmierbaren Kleincomputers MUPID zu einer Zeit, wo es noch keine PCs gab. Wir stellten ihn im Juni 1982 der Öffentlichkeit vor und zeigten der Post(Telekom), Informatikfirmen, potentielle Investoren und vor allem dem Forschungsministerium (Sektionschef Rozsenich), dass unsere Arbeit etwas Sinvolles ergeben hatte und nicht nur die Produktion von diesen Geräten in der Steiermark möglich machen würde, sondern auch, dass die Informatik an der TU Graz zusätzlich zur bisherigen großzügigen Projektfinanzierung kräftig ausgebaut werden sollte.Niemand konnte damals ahnen, dass zwar fast 50.000 MUPIDs erzeugt wurden (von denen viele in den Export gingen), dass aber der langfristige Erfolg doch nicht gelingen würde.

Das Besondere am MUPID-BTX Konzept waren nicht nur seine Grafikfähigkeiten und die Unterstützung von Chats und Diskussionsforen (in Vorwegnahme der heutigen Blogs und Social Networks), sondern dass MUPID das Netzwerk als Daten- und Programmspeicher verwendete, und damit das Konzept der Cloud und der Apps (damals nannten wir das "Telesoftware", weil die Software aus dem Netz in den MUPID geladen wurde) vorwegnahm. Es war damit möglich, Systeme zu installieren, die gegen Viren weitgehend, und gegen Trojaner vollständig gefeit waren!

Der Entschluss, MUPID zu entwickeln und zu produzieren (vor allem die weiter verbreitete Version 2) beruhte auf der Tatsache, dass die CEPT für BTX eine Norm vorgeschrieben hatte, die (bewusst) ohne spezielle Hardware von damaligen Kleincomputern wie Atari oder Apple nicht erfüllbar war, d.h. die Norm sollte einen Schutz gegen nicht-europäische Konkurrenz bieten. Damit wäre wohl dem Aufbau einer echten europäischen Computer- und Softwareindustrie nichts im Wege gestanden.

Aber, typisch Europa, alle Staaten unterschrieben die Norm. Nur: England und Frankreich ignorierten sie einfach, andere Länder folgten. Der österreichische Markt war aber zu klein, obwohl z.B. 800 Notare in Österreich MUPID bis nahezu 1990 verwenden mussten, weil das Grundbuch elektronisch nur so abrufbar war!

Dass der Markt in Österreich so klein war, lag auch an der schlechten Telefoninfrastruktur und den überhöhten Preisen der Post: Pro Stunde wurden auch als Ortstarif ca. 3 Euro (!) verrechnet. Auf diese Problematik hat Peter Lechner, der für das Marketing von BTX zuständig war, immer wieder hingewiesen. Trotz dieser Bedenken war der heutige Dr. Peter Lechner einer der wichtigsten Unterstpützer von MUPID und BTS. (danke, Peter!) Siehe auch Bericht MUPID.

Das Ende von BTX hat bei mir Überlegungen zur Stabilität digitaler Informationen geführt.

Hyperwave#

Die Erfahrungen mit BTX lehrten uns Vieles, was man bei großen verteilten Netzen beachten muss, etwa wie man "gebrochene Links" vermeiden kann, indem man bidirektionale Links einführt, die nicht Teil einer Seite sind, sondern unabhängig von ihr verwaltet werden. Mehr als 30 innovative Ideen konnten so in ein vernetztes Multimedia-System Hyper-G (später Hyperwave) umgesetzt werden, siehe das klassische Buch "H. Maurer: Hyperwave- The next generation Web solution; Addison Wesley, 1996."Es ist interessant, dass sich Hyperwave nicht großflächig durchsetzte, sondern das sehr viel einfachere am CERN (von Robert Cailliau und seinen Mitarbeitern, darunter Berners Lee) entwickelte WWW.

Tatsächlich gab es 1991 drei Ansätze für große verteilte Multimedia Systeme. Das einfachste und "dümmste" war WWW, denn es war ja ursprünglich nur als System für die Verteilung von Physikberichten gedacht. Gopher (von Mark McCahill an der Universität Minnesota entwickelt) war mit seinen Strukturmöglichkeiten und seiner Benutzerverwaltung nicht nur viel besser, sondern mit am Höhepunkt 80.000 Servern weltweit am weitesten verbreitet; Hyperwave war technisch das beste System, doch erforderte es eine größeren Lernaufwand, um von seinen Eigenschaften zu profitieren.

Die Erfolgslawine für WWW beruht aber darauf, dass dafür der erste graphische Browser MOSAIC entwickelt wurde. Damit wurde Gopher verdrängt. Hyperwave wurde adaptiert, damit es mit den üblichen Browsern verwendet werden kann. Es ist, von einer kleinen erfolgreichen Firma unterstützt, vor allem als Wissensmanagement in einigen sehr großen Konzernen weltweit im Einsatz, aber z.B. auch als Basis für das erste open-source online Journal JUCS, das ich vor über 20 Jahren mit meinen Kollegen Arto Salomaa und Cris Calude ins Leben rief.

Auf der Basis von Hyperwave wurde auch das Österreich Lexikon AEIOU für die 1.000 Jahrfeier Österreichs entwickelt und führte allmählich zum Austria-Forum. Das ursprüngliche System ist noch immer in Betrieb, obwohl das Austria-Forum heute schon vielfach größer ist. Aber die Zeitleiste von AEOIU zeichnet diesen frühen Versuch noch heute aus!In den Jahren 1985 bis 2005 beschäftigte ich mich auch intensiv mit e-Learning, woraus u.a. auch zwei Bücher (mit meinen Kollegen und Freunden Nick Scerbakov bzw. Joachim Hasebrook) enstanden, aber auch mit Plagiatserkennung. Kurze Zeit arbeitete ich auch zusammen mit dem "Plagiatsjäger" Stefan Weber, dessen Methoden ich allerdings immer mehr ablehnte: Ich halte die Plagiatsprüfung von gerade entstandenen Werken für sinnvoll, aber nicht die Prüfung von Werken, die mehr als einige Jahre in der Vergangenheit liegen, wobei solche Prüfungen oft von Feinden der Person gegen Geld durchgeführt werden, um der Person zu schaden.

Während meiner Zeit in Graz erhielt ich Rufe von mehrere Universitäten. Darunter Auckland und Denver, die ich zwar ablehnte, aber doch für gewissen Perioden zur Verfügung stand (s.u.), aber auch nach Freiburg, an die Humboldt Universität in Berlin, an die Memorial University in St. Johns in Neufundland, u.a. Das verlockendste Angebot kam von der Universität in Victoria, Kanada, wo man mir einen "Endowed Chair" und acht Mitarbeiterstellen anbot. Dass ich in Graz blieb, hatte zwei Gründe: Einerseits erhielt ich vom Ministerium (da war auch Ministerin Dr. Herta Firnberg selbst involviert) ein ungewöhnliches Gegenangebot, und zweitens signalisierte die Sektion Forschung (Sektionschef Dr. N. Rozsenich) weitere Unterstützung, wenn wir unsere Forschungen und Entwicklungen mit Energie vorantreiben würden, siehe etwa die oben dargestellte MUPID Entwicklung.

Erfahrungen im Ausland#

In meiner Zeit in Auckland promovierte ich meine bisher beste Dissertantin Jennifer Lennon, sowie Achim Schneider und Jennifer Shearer. In Denver machte John Buford-Koegel die Doktorarbeit bei mir. Eine partielle Liste meiner Dissertanten und Habilitanten findet sich bei der Academia Europaea.

Alle diese Aufenthalte, wie auch Projektaufenthalte in Indien, Pakistan und Malaysien brachten mir beruflich und privat eine Fülle von Erlebnissen, deren Bericht den Rahmen hier endgültig sprengen würden.

Erwähnen muss ich aber noch eine Aktion, die bis heute starke Folgen hat.

Vor ca. 15 Jahren wurden die ersten Kompetenzzentren ausgeschrieben. Ich erkundigte mich bei meinem Freund und Mentor Sektionschef Dr. N. Rozsenich, ob ich versuchen sollte, ein solches Kompetenzzentrum nach Graz zu bekommen. Seine Antwort werde ich nie vergessen: "Also, die Pflicht hast Du mit Deinen Aktivitäten in Graz schon erfüllt, aber wenn Du für die Kür auch gute Noten bekommen willst solltest Du an ein Kompetenzzentrum denken."

So beantragte ich eine Kompetenzzentrum KNOW für Wissensmanagement. Zu meiner großen Freude wurde es prinzipiell genehmigt, aber es waren natürlich viele Details zu klären. Z.B.: Wer würde es leiten? Sicher nicht mehr ich, damals schon über 60. Ich hatte aber bei Beratertätigkeiten in Deutschland Dr. Klaus Tochtermann kennen gelernt, und war sehr von ihm beeindruckt. Er arbeitete damals am Institut von Professor Radermacher in Ulm, das gerade durch eine Umorganisationphase ging. In zwei Gesprächen konnte ich Tochtermann überzeugen, Leiter des KNOW Centers zu werden.

Wie man weiß, erfüllte er diese Aufgabe viele Jahre sehr gut und übergab, als er das Angebot nach Kiel als Direktor des ZBW – Leibniz Informationszentrum Wirtschaft annahm, die Leitung einer blühenden Einrichtung Professor Stephanie Lindstaedt, die er seinerzeit nach Graz geholt hatte.

Das KNOW Center war und ist eines der Aushängeschilder für die Idee der Kompetenzzentren.

Verbleibt nur zu berichten, dass es auf Grund der Aktivitäten gelang, hervorragende Köpfe zu fördern, wie Herbert Edelsbrunner, heute am IST-A, Dieter Fellner, Chef von Fraunhofer Darmstadt, Emo Welzl, schon lange Professor an der ETH in Zürich, Franz Aurenhammer, nun Professor an der TU Graz, aber auch sowohl in der Industrie wie in der akademischen Welt höchst erfolgreiche Informatiker wie Frank Kappe (Bild weiter unten), nach Mitgründung und CTO der Firma Hyperwave heute Professor und Dekan an der TU Graz, usw. Aufbauend auf den Austria-Forum Aktivitäten (die mit dem letzten österreichischen Lexikon begannen) ist auch das Austria-Forum entstanden, das mit 1. August 2017 offiziell um eine große geographische Komponente erweitert wurde, die zu neuen internationalen Kooperationen führen wird.

Rückblick#

Ein Rückblick zeigt, wie viel sich in der IT in 60 Jahren geändert hat. Von der mühsamen Arbeit mit „Großrechnern“ in den sechziger Jahren mit Lochstreifen/Lochkarten oder Schreibmaschinentastatur Eingabe über „Bootstrapping“ und Druckerausgabe zu S/W Terminals als Eingabe und Anzeigegeräte, über komfortabler Terminals und schließlich alleinstehende PCs, die anfangs selten mit einem Firmennetz, heute dauernd mit dem internen und dem Internet in Verbindung stehen.

So wie sich dies durch große Speicher und Betriebssysteme geändert hat, die nächsten Schritte waren noch spektakulärer: die Verwendung von immer besserer Farbgraphik, bis man sich heute in der virtuellen Realität mit einer 3D Brille fast wie in der realen Welt bewegen kann, ja oft mehr: Denn durch die Blutgefäße eines Menschen zu schwimmen oder im Sonnensystem herumfliegen kann man zwar virtuell, aber nicht real.

Die Maschinen verstehen immer besser Text, ja sogar Sprache, sodass ich mein Smartphone sprachlich nach Informationen fragen kann, die das Smartphone im Internet findet und mir zeigt oder gar vorliest. Auch Bildanalyse und Bildvergleiche werden immer besser.

Aber all das ist nichts im Vergleich zu den Umwälzungen, die das weltweite Netz, das wir über das WWW, über E-Mails, über (Video) Telefonie, über Apps und Social Networks verwenden, gebracht haben. Nicht nur hat sich die Kommunikation zwischen Menschen vollständig verändert und beschleunigt. Nicht nur gibt es inzwischen über eine Milliarde (!) Websites, die uns mit zum Teil falschen Informationen und Gigamengen von Werbung zumüllen, sondern jeder, der es will, kann auch ein neuer Informationsanbieter werden: über Followers bei Twitter oder Postings bei Facebook, über Blogs, oder über YouTube Videos, usw.

Es ist die Informationsflut unkontrollierter Qualität, die zunehmenden „Fake News“ oder „alternativen Fakten“, die vielen Menschen Sorgen bereiten, und gerade sie sind ein Grund, warum ein Server mit qualitätskontrollierter Information bei Beibehaltung der Meinungsvielfalt, wie es das Austria-Forum sein will, so wichtig ist.

Die leichte Verbreitung von Informationen kann man als für eine Demokratie erfreulich sehen, oder als eine Gefahr, dass sie leicht zu Manipulationen, zur Gehirnwäsche, oder zu einer Art “Lynchjustiz“ führt.

Übrigens, werden die Daten, die wir heute speichern, in 60 Jahren noch zu lesen sein? Da kann man berechtigte Zweifel anmelden: Schließlich ist aus der BTX Zeit fast nichts mehr erhalten; fast nichts vom großen Hypermediasystem der Brown University ist noch nachvollziehbar; wir speichern unglaubliche Datenmengen als PDF Files--- es gibt Strömungen, die Adobe nicht nur über Flash sondern auch über PDF in die Knie zwingen wollen; aber, weniger spekulativ, wenn wir heute ein stark graphisch orientiertes hochinteraktives Computerspiel betrachten, ist dieses mit 99% Wahrscheinlichkeit 2080 nicht mehr benutzbar, denn es beruht auf dann hoffnungslos veralteter Hardware, Software, und Graphik- und Interaktionsgeräten und -Standards.

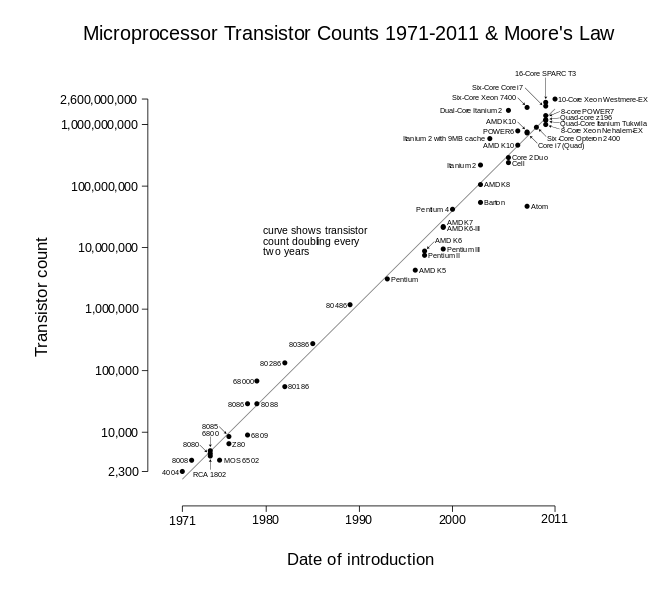

Dass die Entwicklung so rapide immer schnellere und auch physisch kleinere Computer erlaubt, liegt an der Beobachtung, die oft als "Moore'sches Gesetz" bezeichnet wird: Gordon Moore prognostiziert auf Grund seiner Beobachtungen 1965, dass sich die Komplexität integrierter Schaltkreise mit minimalen Komponentenkosten regelmäßig, typisch alle zwei Jahre verdoppelt, was zu sehr viel größerer Geschwindigkeit, aber auch zunehmender Verkleinerung und Verringerung der Kosten trotz steigender Leistung führt. Dieses "Gesetz" gilt noch immer, auch wenn regelmäßig sein Ende vorhergesagt wird.

Die nebenstehende Graphik zeigt die Entwicklung in den 40 Jahren 1971 bis 2011, in 40 Jahren von 2.300 Transistoren auf 2,6 Milliarden, was einem Faktor von etwas über einer Million entspricht. Das passt tatsächlich sehr genau mit der Zahl 220 = 1,048.575 zusammen.

Ohne diese rapide Entwicklung der Hardware, die sich ähnlich auch bei externen Speichermedien vollzogen hat, wären viele heutige Anwendungen und auch das WWW trotz auch stark verbesserter Methoden der Datenstrukturierung und der Algorithmen undenkbar.

Wer hat übrigens vor 60 Jahren Drohnen voraussehen können, die für Erkundungs-, Zustell- oder kriegerische Einsätze verwendet werden können und damit nicht nur die oft beschworene Privatsphäre vernichten? Dass solche Drohnen sogar bis auf Mückengröße schrumpfen werden und als Schwarm agieren können, ist noch nicht Realität, aber wird in meinen Roman „Kampf dem großen Bruder“ (2006), der unter dem angegeben Link online lesbar bzw. als PDF herunterladbar ist, für die frühen 2020 er Jahre für möglich gehalten, ähnlich wie ich schon in einem Buch 2004 den totalen Zusammenbruch der Netze, konservativ erst 2080, beschrieben habe. Diese beiden Bücher sind SF Romane, und in eine (sicher nicht allen gefallende) Rahmenhandlung eingebettet, aber mein zurzeit letzter Roman (2014) „Ende des Traums“ ist hinreichend realitätsnah, dass er nachdenklich stimmen könnte.

Eine Lückenbiographie#

Nachdenklich stimmt mich der Hpye über IoT, das „Internet of Things“, wo etwa die Tatsache, dass die Zahnbürste meines Kindes mit dem Netzwerk verbunden ist und mir meldet, dass das Kind zu flüchtig Zähne putzt, oder umgekehrt, sehr gründlich und damit ein höheres Taschengeld als Belohnung bekommen sollte, als tolle Neuerung beschrieben wird.

Natürlich gibt es beim IoT auch sinnvolle Anwendungen (etwa bei der autonomen Steuerung von Fahrzeugen in Warenlagern, oder als Warnsignale, die mehr auffallen als ein Verkehrsschild und vielleicht sogar in das Fahrverhalten eingreifen). Aber ich glaube, dass man zwar die Vorteile der Digitalisierung erkennen muss, aber auch ihre Nachteile, bzw. dass eben manches nur aus geschäftlichen und nicht aus gesellschaftliche Gründen bewusst gemacht wird, um ein zunächst nicht vorhandenes Bedürfnis zu wecken, mit dem Geld zu verdienen ist.

Schlussbemerkungen#

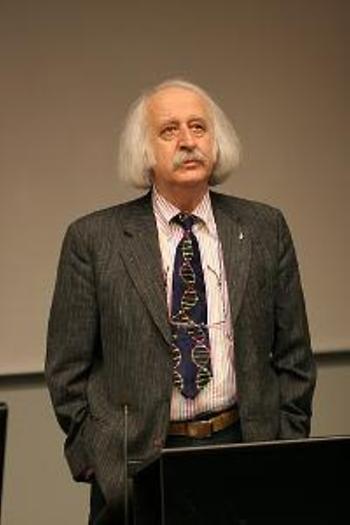

Ich wurde oft gefragt: „Worauf sind Sie, Herr Maurer, am meisten stolz?“. Die Antwort ist einfach: Dass ich einer Anzahl von Menschen helfen konnte, eine erfolgreiche Karriere zu machen, was vielleicht ohne mich (ich bin eingebildet!) nicht geschehen wäre.

„Und wer war für Sie am Wichtigsten?“. Hier ist die Antwort komplex, und ich muss mich sofort für Auslassungen entschuldigen, denn die Liste ist lange. Dennoch, hier ist ein Versuch:

Professor John Peck verdanke ich meine kanadischen Erfahrungen, und dass er mich mit unendlicher Geduld in die Informatik eingeführt hat.

Professor Heinz Zemanek, der immer als der große Computerfachmann Österreichs angesehen wird, war ein genialer Manager und Ingenieur und er bot nicht nur mir die Chance in die Informatik einzutauchen, wo das in Österreich noch ein unbekanntes Wort war. Ihm haben ihre Karriere unzählige Professoren zu verdanken, ich gehöre dazu, wie Alber, Bjoerner, Chroust, Henhapl, Imrich, Kuich, Lauer, Neuhold, Sauer, u.a.

Professor Edmund Hlawka, der mich bei der Dissertationsarbeit wesentlich unterstützte.

Professor Bruno Buchberger, Mathematiker in Linz, der aber kaum wie jemand anderer die Informatikwelt in Innsbruck, in Linz, und in Österreich insgesamt beeinflusst hat. Es ist für mich eine der größten Auszeichnungen, dass wir beide Ehrenmitglieder der OCG sind und Mitglieder der Academia Europaea.

Professor Reinhard Posch, ohne den das MUPID Projekt nie begonnen worden wäre. MUPID steht ja inoffiziell auch für Maurer Und Posch Intelligenter Decoder. Aber ohne MUPID hätte sich die Informatik in Graz viel später und anders (bescheidener) entwickelt.

Sektionschef Dr. Norbert Rozsenich (heute Mitglied des Unirates der BOKU und noch immer ein Unterstützer meiner Aktivitäten beim Austria-Forum), ohne dessen Glauben an und Unterstützung von Posch und mir weder MUPID noch AEIOU und das Austria-Forum möglich gewesen wären.

Dr. Otto Zich, damals Vorstand Elektronik der VOEST, der mir, nachdem er schweigend 30 Minuten zugehört hatte, vier seiner VOEST Mitarbeiter für die Kommerzialisierung von MUPID zur Verfügung stellte.

Die seinerzeitige Ministerialrätin Dr. Barbara Borek, die das Unmögliche möglich machte: Dass ich jahrelang Forscher aus der Weltelite an mein Institut an der TU Graz einladen konnte.

Die steirische Landeregierung, die mir mehrfach unglaublich unbürokratisch unter die Arme griff, um Projekte vor dem Scheitern zu bewahren, oder um neue Ideen umsetzen zu können.

Insgesamt, ich bin, wie wir fast alle verblüfft, wie stark sich die IT seit 1960 entwickelt hat. Ich sehe kein Ende der Entwicklung, aber, kleinkarierter, auch kein Ende des Ausbaus und der Verbesserung des Austria-Forums!

Ich hoffe, dass viele Leser dieses Beitrags das Austria-Forum (weiter) unterstützen werden und vor allem bei Highlights und Geography/Highlights vorbeischauen werden!

Ich sehe auch kein Ende in meinen Bemühungen, mit etwas Phantasie den Blick in die Zukunft zu richten, nicht nur in der Informatik, und zu ermutigen oder zu warnen.

- Lieber Hermann Maurer: Ich bin von Deiner beneidenswerte Karriere beeindruckt. Was mich wundert ist, dass Du kaum über Deine Gastaufenthalte in Japan, Australien oder den USA berichtet hast, obwohl Du mir mehrmals Interessantes oder nette Ankedoten davon erzählt hast!

-- gamauf gerald antal, Dienstag, 1. August 2017, 18:33

- Lieber Gerald, ich glaube ich habe ohnehin schon sehr lange geschrieben, drum wollte ich nicht noch mehr über Aufenthalte in Japan, Australien Neuseeland, USA oder Süfafrika berichten. Aber seis drum, hier alsozwei Anekdoten.

Ich verbrachte einmal drei Wochen am RITE in Tokio. Alle bemühten sich sehr um mich, jeden Tag wurde ich am Abend eingeladen, wobei die exotischten Dinge serviert wurden. Nach zwei Wochen roher geschabter Kartofelln, diverser Maden und Insekten freute ich mich auf den Mittwoch der dritten Woche: Da hatte ich keine Einladung und ich wollte einfach in den nahen Mc Donald's gehen.

Als ich um 17 Uhr das Büro verließ, fing mich der Chef von RITE ab. Er meinte (ich sage es hier Deutsch): "Ich habe gehört, Sie haben heute Abend frei. Da darf ich Sie gut ausführen."

Ich war entsetzt, konne aber nicht ablehnen. Um 19 Uhr wurde ich mit Limousine abgeholt. Unmittelbar nach dem Einsteigen sagte mein Gastgeber: "Ich glaube, Sie haben nach mehr als zwei Wochen ungewöhnlicher japanischer Delikatessen genug. Ich habe im besten französischen Restaurant für uns reserviert."

Muss ich noch sagen, dass wir gute Freunde wurden?

Und hier eine allerletzte Draufgabe. Während meines Semesters an der SMU in Dallas durchstreifte ich oft den Campus, denn er ist im eher langweiligen Dallas wirklich eine Ausnahme. Einmal ging ich wieder durch eine offene Tür (üblich) in eine Klasse. Ich sah zu meinem Erstaunen, dass es eine Aktzeichenklasse war und wollte verlegen verschwinden. Der Professor ließ es nicht zu. "Kommen sie nur, und probieren sie"! So bekam ich Unterricht im Zeichnen eines hübschen Models. Na ja, ich bin zwar ganz unbegabt, aber ich habe schon Unangenehmeres erlebt.

Over and out!

-- Maurer Hermann, Freitag, 18. August 2017, 17:47

Ich bin nach wie vor Obmann des gemeinnützigen Vereins "Freunde des Austria-Forums" und leite mit mehreren Mitarbeiter*innen die Aufrechterhaltung des Systems und die Forschung und Entwicklung von NID, das sich immer mehr als international angesehene Entwicklung mit vielen Einladungen für Vorträge und Publikationen erweist. Ich werde mich um die Verlängerung meiner Aktivitäten als Obmann des Vereins im Februar 2024 bewerben, und hoffe als Obmann oder unter einem neuen Obmann bis 2027 aktiv zu bleiben.

-- Maurer Hermann, Mittwoch, 20. September 2023, 10:34