Was bleibt? Kontinuität und Wandel einer Disziplin.#

Von Th. Ottmann, Institut für Informatik, Technische Fakultät

ottmann nospam@TUGraz.at @informatik.uni-freiburg.de

Erstpublikation unter "Erzählte Erfahrungen" im Heft 200 (2013), 47-67, der "Freiburger Universitätsblätter", im Rombach Verlag, vom Verlag freundlicher Weise zur Verfügung gestellt.

Anfang in Münster#

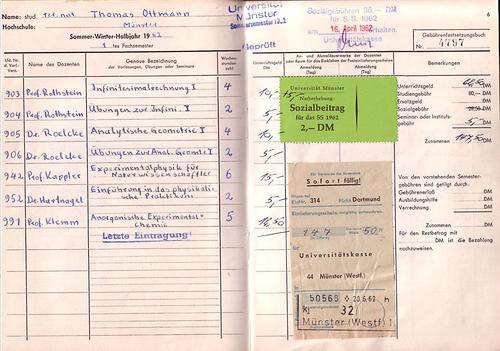

Als ich im Frühjahr 1962 das Studium begann (damals endete das Schuljahr noch zu Ostern), gab es das Fach Informatik als studierbare akademische Disziplin an deutschen Universitäten noch nicht. Nach dem Abitur an einem humanistischen Gymnasium in Münster (mit 9 Jahren Latein und 6 Jahren Griechisch Unterricht, und nur geringen Kenntnissen in Englisch als einziger „lebender“ Fremdsprache) entschied ich mich, die Fächer Mathematik und Physik an der Universität Münster für das Lehramt an Gymnasien zu studieren. Die Motivation mag gewesen sein, dass ich diese Fächer in der Schule als angenehm empfand, weil man da anders als in den Sprachen, relativ wenig auswendig lernen musste sondern das, was man wissen musste, meistens einfach aus wenigen Fakten und Grundkenntnissen ableiten konnte.Der Schock nach Studienbeginn war allerdings gewaltig: Die Vermittlung von Mathematik (und etwas weniger auch von Physik) an der Universität unterschied sich von dem, was ich aus der Schule gewohnt war, drastisch. Abstraktionsniveau und Tempo waren so hoch und ungewohnt, dass ich bereits nach sechs Wochen nahezu gar nichts mehr verstand. Daran gedacht, aufzuhören und das Studienfach zu wechseln, habe ich allerdings zu keinem Zeitpunkt: Mit großem Arbeitseinsatz und der moralischen Unterstützung einer Lerngruppe von ebenfalls großes Standvermögen zeigenden Kommilitonen habe ich mich durch die ersten zwei Semester durchgebissen. Dann lief es ziemlich glatt. Ich habe fleißig Scheine und Leistungsnachweise gesammelt und dabei sogar meistens so gut abgeschnitten, dass ich „Gebührenerlass“ beantragen konnte: Denn in den ersten Semestern des Studiums mussten Vorlesungen noch belegt und vom Dozenten testiert werden. Für jede Semesterwochenstunde waren 2,50 DM als „Unterrichtsgeld“ (an den Dozenten) zu entrichten mit dem Effekt, dass die großen Einführungs-Vorlesungen von den „gestandenen“ Ordinarien gelesen wurden, weil das auch finanziell attraktiv war. Die jeweils sechsstündige zweisemestrige Einführung in die Experimentalphysik hatte beispielsweise mehr als 1000 Hörer und war eine offenbar über viele Jahre gereifte, wirklich großartige Einführung in die gesamte Physik!

Lehramtskandidaten mussten auch damals schon nicht nur zwei Fächer studieren sondern auch ein philosophisch-pädagogisches Begleitstudium absolvieren - wie neuerdings wieder. Üblicherweise legte man so um das sechste Semester herum ein sogenanntes „Philosophikum“ ab, das diese nichtfachlichen Inhalte zum Gegenstand hatte. In Münster konnten Lehramts Kandidaten des Fachs Mathematik damals die philosophischen Vorlesungen auch in der Mathematischen Logik belegen. Dieses Fach hatte an der Mathematisch-Naturwissenschaftlichen Fakultät der Uni Münster eine längere Tradition, die von Heinrich Scholz begründet war. Das Fach wurde damals von Hans Hermes vertreten, der allerdings 1966 nach Freiburg wechselte.

Sein Schüler und Nachfolger Dieter Rödding setze die Münsteraner Tradition fort. Ein Schwerpunkt der Lehr- und Forschungstätigkeit des Instituts für Mathematische Logik und Grundlagen der Mathematik war nicht nur die Aussagen- und Prädikatenlogik (Logik erster Stufe) sondern insbesondere die Beschäftigung mit abstrakten Maschinen und Kalkülen, ein Gebiet, das man vielleicht etwas irreführend als „Rekursionstheorie“ bezeichnet. Ich besuchte alle Vorlesungen des Fachs Mathematische Logik und legte das Philosophikum in diesem Fach ab. Auch die schriftliche Zulassungsarbeit zum Staatsexamen habe ich schließlich bei D. Rödding geschrieben. Als ich im Juli 1969 das Staatsexamen in Mathematik erfolgreich absolviert hatte, wurde ich einer seiner drei Assistenten.

Es gab am Institut für Mathematische Logik eine sehr fruchtbare Forschungsatmosphäre in einem für die damalige, durch Bourbaki geprägte Sicht der Mathematik sehr unkonventionellen Gebiet, dem der abstrakten Maschinen und Kalküle, in das viele später erfolgreiche Doktoranden und Mitarbeiter eingebunden waren (Beispiele: H. Schwichtenberg, heute Prof. an der LMU, E. Böger, Prof. in Pisa, E. Cohors-Fresenborg, Prof. in Osnabrück, … uva.). Welch großen Einfluss die Münsteraner Schule der Mathematischen Logik im allgemeinen und Dieter Rödding im Besonderen auf die Anfänge der Informatik in Deutschland hatte kann man beispielsweise an der langen Liste prominenter Logiker und Informatiker ablesen, die einen Beitrag zum Festband für Dieter Rödding im Jahre 1987 lieferten [1]. Dieser Band erschien im Jahre 1987, in dem der bereits im Alter von 47 Jahren im Jahre 1984 verstorbene D. Rödding 50 Jahre alt geworden wäre.

Nach nur zwei Jahren als Assistent konnte ich im Sommer 1971 meine Promotion bei D. Rödding erfolgreich abschließen. Solche nach heutiger Praxis vergleichsweise kurzen Promotionszeiten waren damals üblich. Für manche Doktoranden war die Promotion sogar die erste und einzige Prüfung zum Studienabschluss, d.h. es gab noch die sogenannte „grundständige Promotion“, die kein anderes Examen (Staatsexamen oder Diplom) als Zulassungsvoraussetzung hatte. Die Folge war, dass das Rigorosum, also die zum Promotions-Verfahren dazugehörige Fachprüfung, eine wirklich harte Prüfung war. Für mich war es die härteste Prüfung meines Lebens (in den Fächern Mathematik, Physik und Mathematische Logik)! Studienabschluss und Promotion ließen wenig Zeit für Anderes, sodass die mit der sogenannten 68-er Revolution über die Universitäten hereinbrechenden Umbrüche an meinem Fach und mir selbst ziemlich spurlos vorübergingen. Der Aufbruch kam eher von einer anderen Seite, nämlich vom Aufstieg des Computers als universellem Arbeitsmittel für die Wissenschaft: Überall, auch an der Universität Münster, wurden Rechenzentren gegründet, die zentrale Rechner, sogenannte „Mainframes“, betrieben, riesige Maschinen, die in gekühlten Räumen von einer neuen Klasse von Dienstleistungspersonal betrieben wurden und auf kryptische Art programmiert werden mussten.

Natürlich habe ich auch in Münster meinen ersten Programmierkurs (in Fortran, einer sogenannten imperativen Programmiersprache, die heute immer noch lebt!) gemacht und Programme auf Lochkarten gestanzt, im Rechenzentrum abgegeben, und nach ein bis zwei Tagen ein Resultat oder aber eine Fehlermeldung auf einem Stück Endlospapier zurück erhalten. Faszinierend daran war, dass damit auf einmal das mir aus der Logik längst bekannte, theoretische Konzept des speicherprogrammierbaren Rechners Realität wurde und eine konkrete Gestalt bekam.

Ohne zu wissen was „Informatik“ ist, hatte ich durch Studium und Promotion in der Mathematischen Logik ein für dieses Fach bis heute grundlegendes Verständnis für zentrale Begriffe und Konzepte erworben, und auch das „Programmieren“ abstrakter Maschinen gelernt, freilich in einer von der aktuellen technischen Realisierung unabhängigen Form. Traditionell (bis heute) legte allerdings die Mathematische Logik mehr Wert auf das Einschätzen der Möglichkeiten und Grenzen algorithmischer Verfahren als auf das Entwickeln neuer Algorithmen für konkrete Anwendungen und das Training des für die Informatik typischen konstruktiven Vorgehens und des Entwickelns von Systemen im Team.

Es gibt viele weitere Beispiele dafür, dass die Mathematische Logik Wesentliches zur konzeptionellen Begründung der Informatik beigetragen hat. Bereits Mitte der 30-er Jahre hatte Alan Turing sein Konzept universeller programmierbarer Rechner eingeführt und nachgewiesen, dass es algorithmisch, d.h. mit Computern überhaupt nicht lösbare Probleme gibt. Das berühmte Haltproblem für Turingmaschinen ist das Standard Referenzbeispiel dafür. Mehr noch: Es gibt in einem präzisen Sinne viel mehr nicht mit Computern lösbare Probleme als solche, die algorithmisch lösbar sind. Und für die algorithmisch „im Prinzip“ lösbaren Probleme kommt es darauf an, ob sie auch „praktisch“ lösbar sind, d.h. in vernünftiger Zeit mit vertretbaren Ressourcen, d.h. genauer, ob sie mit polynomiellem Zeit- und Platzbedarf gelöst werden können. 1971 haben Cook und Karp den Begriff der praktischen Lösbarkeit von Problemen präzisiert und die Klassen P und NP der in Polynomzeit lösbaren bzw. der in Polynomzeit verifizierbaren Probleme eingeführt und damit den Grundstein für eine Komplexitätstheorie gelegt. Bis heute ist die Frage, ob die beiden Klassen P und NP identisch sind oder nicht, das wichtigste und bekannteste offene Problem der (theoretischen) Informatik geblieben. Bereits 1936 hat Kurt Gödel Beweiskalküle untersucht und ihre Möglichkeiten und Grenzen abgesteckt. Sie bilden die Basis für Verfahren zur Programmverifikation in der Softwaretechnik und das formale Gerüst für Sprachen zur Extraktion von Daten aus Datenbanksystemen. Das Konzept des endlichen Automaten wurde von Büchi und Kleene bereits Anfang der 60-er Jahre eingeführt und wird bis heute zur Beschreibung von Rechnern und Kommunikationsprotokollen benutzt. Ein anderes Beispiel ist die von C. Shannon 1948 eingeführte Informationstheorie; sie hat ihre Bedeutung für die Verschlüsselung und Komprimierung von Daten bis heute behalten. Alle diese hier nur angedeuteten Beispiele belegen, dass die konzeptuellen Grundlagen des neuen Fachs viel älter sind als ihr offizielles Erscheinen gegen Ende der 60-er Jahre.

Während im angelsächsischen Sprachraum der Begriff „Computer Science“ bereits Ende der 60-er Jahre gebräuchlich war, setzte sich etwa ab 1967 ausgehend von Frankreich der umfassender zu verstehende Begriff „Informatik“ als Bezeichnung für die neue Wissenschaft auch im deutschen Sprachraum durch. In Deutschland wurde der Begriff Informatik 1968 auf wissenschaftlichen Kolloquien und durch den damaligen Bundesforschungsminister Gerhard Stoltenberg eingeführt. Er bezeichnete mit Informatik den wissenschaftlichen Hintergrund eines Forschungsprogramms des Bundes auf dem Gebiet der Datenverarbeitung.

Die Mathematik ganz allgemein und die Mathematische Logik im Besonderen kann man also sicher als eine der Wurzeln der Informatik ansehen. Die andere Wurzel war die Elektrotechnik. Zwar gilt heute ein deutscher Bauingenieur, Konrad Zuse, als Konstrukteur der ersten Computer (Z1 bis Z4, 1936 bis 1945). Es war aber die Erfindung des Transistors und die Möglichkeit zur Integration vieler Schaltelemente auf einem einzigen „Chip“, die die rasante Entwicklung programmgesteuerter Rechner erst möglich gemacht haben. Die Integrationsdichte, also die Anzahl der Transistoren pro Flächeneinheit, hat sich seither (entsprechend dem 1965 von Gordon Moore formulierten und noch immer gültigen „Gesetz“) etwa alle 20 Monate verdoppelt und hat damit zu einer bis heute ungebrochenen Leistungssteigerung von Computern geführt. Weil die traditionelle Elektrotechnik aber nicht nur die Informationstechnik im Blick hatte (und hat) sondern auch Starkstromtechnik, elektrische Anlagen und Maschinen u.v.a. ist die „Technische Informatik“ als natürliche zweite Wurzel der Informatik aus der Elektrotechnik ausgewandert und in die Informatik integriert worden. Die Leistung der Informatik bestand darin, eine neue Abstraktionsebene, die man als digitale Ebene bezeichnen kann, oberhalb der physikalisch-technischen Verhaltensebene bereitzustellen, die die Handhabung dieser neuen Maschinen erst möglich machte.

So wurden dort an der Fakultät für Wirtschaftswissenschaften zwei neue Lehrstühle eingerichtet, die künftige Wirtschaftsingenieure mit Informatik Kenntnissen und Kompetenzen versorgen sollten. Auf einen dieser Lehrstühle wurde ein junger österreichischer Wissenschaftler, Hermann Maurer, berufen, der zuvor an der Universität in Calgary, Canada, tätig war und einige vielbeachtete Informatik Lehrbücher geschrieben hatte. Ihn traf ich kurz nach meiner Promotion während einer Tagung im Mathematischen Forschungsinstitut Oberwolfach, wo Informatiker, vor allem theoretisch interessierte, als Gäste des eigentlich für die Mathematik reservierten, schon weltberühmten Instituts ein- bis zweimal pro Jahr aufgenommen wurden. Viel später (im Jahre 1989) wurde auch für die Informatik ein ganz ähnliches (und vielleicht sogar noch „perfekteres“) Forschungsinstitut im Saarland gegründet, das heute ebenfalls weltbekannt und wie das Forschungsinstitut Oberwolfach seit dem 1.1.2005 Mitglied der Leibniz-Gemeinschaft ist.

Wechsel nach Karslruhe#

Hermann Maurer suchte neue Mitarbeiter und fragte mich, ob ich nicht zu ihm nach Karlsruhe als Assistent kommen wollte. Die Alternative wäre gewesen, in Münster zu bleiben und den Referendardienst für das Lehramt an Gymnasien in den Fächern Mathematik und Physik zu beginnen. Weil ich das nach der Promotion und der allgemein zu spürenden Aufbruchstimmung der Informatik zu Beginn der 70-er Jahre wenig attraktiv fand, sagte ich zu.In Karlsruhe erlebte ich dann eine völlig andere Atmosphäre als in dem doch sehr abgeschlossenen und introvertierten Münsteraner Logik Institut. In Karlsruhe waren regelmäßig internationale Gäste aus aller Welt zu Besuch, man publizierte auf Englisch, und trug Arbeitsergebnisse auf internationalen Tagungen (natürlich ebenfalls in Englisch) vor. Zwar hat mir das Englisch Sprechen und Schreiben anfangs durchaus Probleme bereitet. Dennoch habe ich von dieser weltoffenen, sehr kompetitiven, internationalen Atmosphäre gerade zu Beginn meiner akademischen Laufbahn ganz erheblich profitiert und viele Arbeiten mit heute zum Teil weltbekannten Fachleuten geschrieben. Damals waren die meisten ebenfalls noch am Anfang ihrer Karriere. Nennen möchte ich hier Arto Salomaa, Derick Wood (der leider vor wenigen Monaten verstorben ist), Arnie Rosenberg, Karel Culik, Philipp Phlajolet, Jan van Leeuwen, Eljas Soisalon Soininen, Franko Preparata und Jon Bentley.

Ich habe insbesondere die Anfänge eines neuen Forschungsgebietes, „Algorithmische Geometrie“, miterlebt und teilweise mit geprägt. Damals war es noch möglich, auch für ganz einfache Fragen neue Lösungen zu finden, die heute zum Standardrepertoire des Fachs gehören. Ein Beispiel mag das heute in jedem Lehrbuch über Algorithmische Geometrie zu findende Sweep-Line-Verfahren zur Bestimmung aller Schnitte einer Menge von Liniensegmenten in der Ebene sein [2]. Von einem rein mathematischen Standpunkt aus betrachtet erschienen viele Probleme trivial lösbar zu sein. Der neue durch die Informatik in diesen Kontext eingebrachte Aspekt ist der der Effizienz (oder: Komplexität) der Lösungsalgorithmen. Da kann der Unterschied zwischen einem in quadratischer oder kubischer Zeit ausführbaren Algorithmus und einem in Zeit O(n log n) ausführbaren Verfahren bedeuten, dass sich ein Verfahren für die interaktive Benutzung am Rechner eignet oder auch nicht.

Dies Gelände der für viele Anwendungen grundlegenden Algorithmen und Datenstrukturen ist dann mein eigentliches Forschungsgebiet geblieben. Vergleicht man den Stand der Wissenschaft und Forschung auf diesem Gebiet zu Beginn der 70-er Jahre mit dem heutigen kann man einen enormen Fortschritt feststellen, zu dem viele Wissenschaftler in aller Welt immer wieder neue und überraschende Beiträge geleistet haben. Ich hatte das Glück, nahezu von Anfang an dabei zu sein und habe im Verlauf von mehr als 30 Jahren auch das eine oder andere dazu beigesteuert.

Das Karlsruher Institut für „Angewandte Informatik und Formale Beschreibungsverfahren, AIFB“ kümmerte sich mit großem Erfolg um die praktische Ausbildung künftiger Wirtschaftsingenieure im Programmieren und in konkreten Algorithmen und Datenstrukturen, die für Anwendungen im Operations Research und für die Lösung und Optimierung wirtschaftlicher Prozesse wichtig waren.

Ich lernte, den neuen institutseigenen Mini-Rechner „der mittleren Datentechnik“, eine PDP-11 der Firma DEC (Digital Equipment Corporation, damals ein sehr erfolgreicher Konkurrent der Firma IBM) zu bedienen und zu programmieren. Aus heutiger Sicht war der 16 Bit Rechner mit 64 kbit Hauptspeicher, Unibus und Unix Betriebssystem ein „Winzling“. Ein Vorteil war allerdings, dass es für diesen Rechner bereits einen Übersetzer für Programme gab, die in der von Niklaus Wirth entwickelten Programmiersprache Pascal geschrieben waren. (Genauer, im sogenannten USCD Pascal, das auch auf Apple II Rechnern lief.) Ferner konnten Peripheriegeräte, wie Drucker und Platten, einfach angesprochen werden. Und so nutzen mein damaliger Mitarbeiter Peter Widmayer und ich diesen Rechner zur Herstellung eines unserer ersten gemeinsam verfassten Bücher, einer Sammlung von Programm-Beispielen für die Ausbildung in der Sprache Pascal: Alle Programme wurden auf der PDP-11 getestet und der Programmtext dann direkt in den Buchtext übernommen und ausgedruckt (mit einem Nadeldrucker, Laser- oder Tintenstrahldrucker gab es noch nicht), sodass das fehleranfällige Abschreiben von Programmtexten vermieden werden konnte (heute natürlich eine Selbstverständlichkeit).

Meinen ersten Artikel habe ich auf Deutsch im „Archiv für Mathematische Logik und Grundlagen der Mathematik“ publiziert. Da war noch ein Setzer, also ein Spezialist für mathematischen Formelsatz nötig, der das mühsam mit Schreibmaschine erzeugte Manuskript für den Druck aufbereitete und mich sogar persönlich konsultierte, um Zweifelsfragen des Formelsatzes zu klären. Wir alle wissen, dass das heute ganz anders ist: Der Autor macht alles selbst. Er ist nicht nur für den Inhalt verantwortlich, sondern auch für Layout und Satz und liefert dem Verlag ein für die Produktion komplett aufbereitetes druckfertiges Manuskript.

Ohne neue Werkzeuge wie das von D. Knuth speziell für mathematische und technische Texte entwickelte Satzsystem TeX (ab 1976 begonnen und 1986 fertig gestellt) und später LaTeX von L. Lamport wäre das wohl unmöglich. Peter Widmayer und ich haben also bereits Mitte der 80-er Jahre eine der ersten Installationen dieses Satzsystems TeX in Karlsruhe auf einem Mainframe des Rechenzentrums zum Laufen gebracht und für die Produktion von Vorversionen unseres Buches „Algorithmen und Datenstrukturen“[3] genutzt.

1975 habe ich mich in Karlsruhe für das Fach Informatik habilitiert. Wenig später, im vergleichsweise jungen Alter von 33 Jahren wurde ich „Wissenschaftlicher Rat und Professor“, eine heute verschwundene Personalkategorie, die wenig später nach C3 übergeleitet wurde. Im Jahr 1978 folgte mein Mentor Hermann Maurer einem Ruf an die Technische Universität Graz, sodass der Lehrstuhl zur Wiederbesetzung ausgeschrieben wurde. Ich selbst erhielt Anfang 1978 einen Ruf auf einen Lehrstuhl für Informatik an der Fern-Uni Hagen. Dadurch war das sog. Hausberufungsverbot außer Kraft gesetzt und ich hatte das Glück, zunächst in Karlsruhe als Nachfolger von Hermann Maurer bleiben zu können. Damit war ich mitverantwortlich für die Informatikausbildung künftiger Wirtschaftsingenieure. Das schloss u.a. auch die Ausbildung von mehreren Hundert Studierenden im imperativen Programmieren ein, was nur durch Einsatz erheblicher Ressourcen für Programmeingabe und Test und weitgehende Automatisierung von Prüfungen zu bewältigen war.

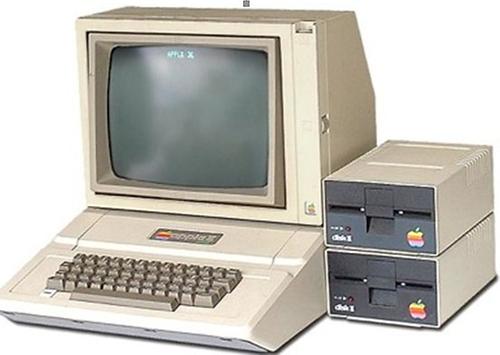

Anfangs haben die Studierenden den im URZ vorhandenen Pool von ca. 50 Fernschreibern zur Programmeingabe benutzt. Man muss sich einmal klar machen, was es bedeutet, wenn man einen Fehler in einem auf einem mit Hilfe eines Fernschreibers auf einem Lochstreifen geschriebenen Programmtextes korrigieren muss: Der Lochstreifen wird bis zur Fehlerstelle kopiert, das fehlerhafte Stück herausgeschnitten, die Korrektur (ein kurzes Lochstreifenstück) eingefügt und der Rest wieder unverändert kopiert und angehängt. Alles wird mit Schere und Klebstoff zu einem neuen Papierstreifen zusammengesetzt. Das ist mühsam und zeitaufwendig. Daher hatten wir eine Vereinbarung mit dem URZ getroffen, die es Studierenden erlaubte, Programme in Prüfungssituationen genau einmal zu korrigieren. Der Lochstreifen wurde also eingelesen, und eine halbe Stunde später erhielten die Studenten das Ergebnis des Übersetzungsversuchs mit Erfolgs- oder Fehlermeldung. Im Falle eines oder mehrer Fehler hatten die Studierenden genau einen weiteren Versuch, dann musste alles stimmen oder man war durchgefallen. Später (Anfang der 80-er Jahre) haben wir statt Programme auf Mainframes zu testen die ersten interaktiven Rechner, Apple II Computer, für die Programmier-Ausbildung und interaktive Prüfungen benutzt.

Bemerkenswert ist, dass die Prüfungsergebnisse nicht signifikant von der früheren Lochstreifen Methode abwichen, - ein klares Indiz dafür, dass es sich auszahlt, erst nachzudenken und Programme Schritt für Schritt gleich richtig (korrekt) zu entwickeln und nicht, wie beim Apple II (und bei den heutigen Rechnern erst recht) erstmals möglich, nach der Trial-and-Error-Methode zu verfahren und drauflos zu programmieren, bis am Ende ein hoffentlich korrektes Programm entsteht.

1983 erhielt ich einen Ruf an die RWTH Aachen, den ich ablehnte, 1987 gleichzeitig je einen Ruf an die Uni Oldenburg und an die Uni Freiburg. Aus fachlicher Sicht wäre es sicher attraktiver gewesen, nach Oldenburg zu wechseln, weil es dort bereits eine voll ausgebaute und gut etablierte Informatik gab, die Informatik Hauptfachstudenten, also Diplominformatiker, ausbildete. Das wäre eine Verbesserung gegenüber der Situation in Karlsruhe gewesen, wo ich es nur mit Wirtschaftsingenieuren zu tun hatte, für die die Informatik höchstens den Umfang eines Nebenfachs im Studium hatte.

In Freiburg dagegen gab es noch nichts. Vielmehr hatte die Mathematische Fakultät offenbar die Absicht, für Ihre Studierenden Informatik als ein mögliches Nebenfach neu einzuführen, wohl aus der Erkenntnis heraus, dass auch Mathematiker inzwischen Grundkenntnisse in der Informatik haben müssten, um im Beruf erfolgreich bestehen zu können. Natürlich hätte ich auch in Karlsruhe bleiben können. Aber wie in solchen Fällen meistens, trifft man eine emotionale Entscheidung und legt sich dann eine rationale Begründung zurecht. Ich war jedenfalls eigentlich von Anfang an entschlossen, nach Freiburg zu gehen und noch einmal etwas Neues zu beginnen.

Wechsel nach Freiburg#

Ein Wechsel nach Freiburg hatte gegenüber dem nach Oldenburg immerhin den Vorteil, dass ich zunächst einmal zwischen Karlsruhe und Freiburg (mit der Bahn) pendeln konnte und einen für die Familie günstigen Umzugstermin abwarten konnte.

Als ich in Freiburg zum WS 1987/88 begann, gab es wirklich nichts! Keine Büros, keine Ausrüstung, keine Informatik Bibliothek, kein Personal. Also habe ich zunächst eine Sekretärin gesucht und eine Schreibmaschine beschafft. Dann wurde Zug-um-Zug eine arbeitsfähige Umgebung in den Räumen des ehemaligen „Rheinstüble“, dem heute vom Personalrat genutzten Gebäude an der Ecke Rheinstraße/Merianstraße, errichtet. In dem kleinen Pavillon wurde ein Pool von Arbeitsplatzrechnern installiert.

Wir beschafften Silicon Graphics Workstations mit Unix Betriebssystem für die Forschung und Apple Macintosh Rechner für die Ausbildung der Studenten. „Wir“, das waren meine mit mir von Karlsruhe noch Freiburg gewechselten Mitarbeiter und wenig später die weiteren Kollegen. Denn das Fach Informatik als „Nebenfach-Lieferant“ in der Mathematischen Fakultät sollte nach der Planung der Universität und der Mathematischen Fakultät in Freiburg von zwei C4 und einer C3 Professur vertreten werden. Im Sommer 1988 wurde Peter Widmayer, jetzt ETH Zürich, auf den zweiten Lehrstuhl berufen (er hatte gleichzeitig mit dem Ruf nach Freiburg Angebote nach Bochum, Hagen und Osnabrück), im Herbst 1988 Heinrich Müller, (ging 1992 an die Uni Dortmund), auf die C3-Professur für das Gebiet Graphische Datenverarbeitung.

In Freiburg habe ich von Anfang an versucht, die Basis für Lehre und Forschung in der Informatik zu verbreitern und Ausschau gehalten nach möglichen Mitstreitern innerhalb der Uni. Sie fand ich vor allem in den Geisteswissenschaften, der von Hans Spada vertretenen Allgemeinen Psychologie, den Kolleginnen und Kollegen im gerade (im Jahre 1989) neu gegründeten Institut für „Informatik- und Gesellschaft“ (G. Strube, G. Müller, B. Schinzel) und der (Computer-)Linguistik, vertreten durch J. Dittmann und U. Hahn, jetzt Uni Jena. Im zweiten Anlauf gelang es uns, ein von der DFG gefördertes interdisziplinäres Graduiertenkolleg zum Thema „Menschliche und Maschinelle Intelligenz“ einzuwerben. Ich habe die Mitarbeit in diesem Kolleg immer als sehr fruchtbar auch für das eigene Fach empfunden und habe in den neun Jahren der Förderung durch die DFG eine Hochachtung für die doch ganz andersartige Forschungsmethodik der Psychologen und Kognitionswissenschaftler bekommen: Während Informatiker bei der Konzeption und Entwicklung neuer Systeme eher hemdsärmelig vorgehen und darauf vertrauen, dass gute Ideen sich schon am Markt durchsetzen werden stellen Psychologen und Kognitionswissenschaftler Hypothesen zur Messung bestimmter (mir allerdings manchmal sehr begrenzt erscheinender) Wirkungen auf, die dann nach allen Regeln der Kunst mit sauberen statistischen Mitteln auf Validität geprüft werden. Sie haben also eine experimentelle Kultur entwickelt, die Informatikern weitgehend fremd ist.

In den ersten Jahren war die Informatik in Freiburg nur als Nebenfach in anderen Studiengängen, insbesondere für Mathematiker, wählbar. Es schien, als habe es in Freiburg bis Ende der 80-er Jahre keine Bestrebungen zum weiteren Ausbau der Informatik gegeben, obwohl die stürmische Nachfrage nach Informatikern auf dem Arbeitsmarkt fast überall auch einen Ausbau der Studienplatz Kapazitäten für Diplom Informatiker zur Folge hatte.

Umso mehr waren mein gerade neu berufener Kollege Peter Widmayer und ich überrascht, als zu Anfang des Jahres 1989 in der Zeitung zu lesen war, dass das gerade neu aufgelegte neue Förderprogramm des Bundes zum Ausbau der Informatik („Möllemann-III-Programm“) an fast allen BW Unis zur Schaffung neuer Professuren und Studienplätze führte, nicht aber in Freiburg! Wir nahmen das zum Anlass, ein mehrseitiges Memorandum zum Ausbau der Informatik an der Universität Freiburg zu verfassen und dem damaligen Rektor, Prof. Ch. Rüchardt (Rektor von 1987 bis 1991), mit Kopie an den Dekan der Math. Fakultät zu übermitteln. Diese Umgehung des „Dienstweges“ wurde von meinen damaligen Kollegen in der Mathematik nicht gern gesehen. Man sah zunächst nur die Gefahr, dass eine Aufwertung und Ausweitung der Informatik die Attraktivität des eigenen Fachs schmälern könnte und weniger die Chance des möglichen Zuwachses neuer Aufgaben als „Dienstleister“ für andere Fächer. Meine Erfahrungen aus der Zeit an der Technischen Hochschule Karlsruhe waren da ganz anders: Die Mathematiker dort waren Dienstleistungen für andere Fächer gewohnt, wussten, dass sie gebraucht wurden, und bezogen einen nicht unerheblichen Teil ihrer Bedeutung in der Universität aus dieser Stellung. (Es ist wohl kein Zufall, dass damals ein Mathematiker, Prof. Heinz Kunle, Rektor der Uni Karlsruhe war. Auch die RWTH Aachen hatte viele Jahre, von 1999 bis 2008, einen Mathematiker als Rektor!)

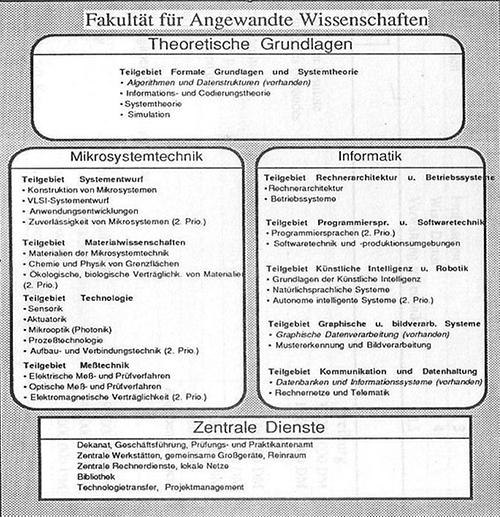

Wir wussten nicht, dass das Rektorat Rüchardt bereits weit fortgeschrittene, allerdings bisher nichtöffentliche Vorstellungen zur Erweiterung der Universität um eine Fakultät für Angewandte Wissenschaften mit den Fachrichtungen Angewandte Informatik, Mikrosystemtechnik, und Materialwissenschaften entwickelt hatte. Unser Vorstoß zum Ausbau der Informatik passte in diese Pläne genau hinein und wurde fortan in die bereits angelaufene Diskussion über die fachliche Ausrichtung einer neu zu gründenden „15. Fakultät für Angewandte Wissenschaften“ einbezogen.

Zu Beginn des Jahres 1989 war das Projekt, eine neue Fakultät mit Schwerpunkten in Lehre und Forschung auf den Gebieten Mikrosystemtechnik, Materialwissenschaften und Informatik zu gründen, durchaus umstritten, weil viele Meinungsführer im Senat und anderen Gremien der Universität nicht nur befürchteten, dass das auf Kosten ihrer Fächer gehen würde, sondern auch, weil damals andere, vermeintlich zur Universität Freiburg besser passende Fächer, wie Gender Studies oder Umweltwissenschaften in Mode waren.

In Februar 1989 fiel der entscheidende Beschluss des Kabinetts Späth, der den „offiziellen“ Auftakt der Planungen der Universität für die neue Fakultät bedeutete. Es ist vielleicht interessant, den ursprünglichen Entwurf des Rektorats vom 7. Februar 1989 mit dem zu vergleichen, was 20 Jahre später vorhanden ist. Zunächst sind die Materialwissenschaften als eigenständige dritte Säule der neuen Fakultät im Verlaufe der Planungen in die Mikrosystemtechnik integriert worden. Dann war das Ziel, keine weitere „Standardinformatik“ als Konkurrenz zu Karlsruhe und Stuttgart und der gerade ebenfalls (durch interne Umschichtungen) entstehenden Informatik in Tübingen zu etablieren sondern eine „Angewandte Informatik“, die nicht nur mit den bereits an der Universität Freiburg vorhandenen Anwendungsfächern in den anderen Fakultäten eng verzahnt ist, sondern auch mit der in derselben Fakultät angesiedelten Mikrosystemtechnik. Aus heutiger Sicht glaube ich sagen zu können, dass diese Ziele erreicht wurden und der Aufbau der Informatik in Freiburg rundum gelungen ist. Es gelang, viele ausgezeichnete junge Wissenschaftler für Freiburg zu gewinnen. Zwei spätere Leibniz Preisträger, S. Albers, die allerdings 2009 an die HU Berlin ging, und W. Burgard, können als Indiz dafür verstanden werden.

Ein aus meiner Sicht wichtiger Faktor für den Erfolg war auch der Umstand, dass die ersten Berufungskommissionen zum Aufbau der neuen Fakultät „senatsunmittelbar“ also ohne eine bestehende Fakultät als Zwischenebene operierten und wir stets externe, also nicht der Uni Freiburg angehörende Experten bei der Auswahl künftiger Kolleginnen und Kollegen hinzugezogen haben. Nicht nur das wissenschaftliche Ansehen der Fakultät ist heute international anerkannt. Auch die von Anfang an gewünschte enge Verzahnung von Mikrosystemtechnik und Informatik wurde nach Anlaufschwierigkeiten erreicht; ein gemeinsam getragenes Graduiertenkolleg und die neuen Studiengänge ESE (Embedded Systems Engineering) und IEMS (Intelligente Eingebettete Mikrosysteme) belegen das. Ich möchte hier die Entstehungsgeschichte der neuen Fakultät nicht wiederholen. Das haben andere bereits ausgiebig getan (vgl. z. B. den Beitrag von Rektor Rüchardt im Jubiläumsband zur 750 Jahr Feier der Gründung der Uni Freiburg, 2004). Zum Erfolg haben viele beigetragen, nicht nur die Rektoren Rüchardt, Löwisch und Jäger, die mit der Fakultät eng verbundene lokale Industrie und die Stadt Freiburg, sondern natürlich vor allem das Land BW, das trotz finanzieller Engpässe letztlich unbeirrt an diesem Projekt festgehalten hat.

Gleichzeitig mit der Erweiterung der Universität Freiburg um eine neue Technische Fakultät waren ähnliche Projekte auch für die Universität Mannheim in BW und die beiden Universitäten Kiel und Lübeck geplant. Alle vier Planungen wurden gleichzeitig dem Wissenschaftsrat vorgelegt und durch ihn im Jahre 1992 begutachtet. Der Wissenschaftsrat stimmte schließlich am 3. Juli 1992 allen vier Projekten und damit auch der Errichtung der neuen Fakultät an der Universität Freiburg zu. Diese Zustimmung war eine notwendige, aber keine hinreichende Voraussetzung für die Beteiligung des Bundes (als Gemeinschaftsaufgabe nach HBFG) [4].

Die Umsetzung der Planungen für Kiel und Lübeck ist nie vollständig gelungen, die Erweiterung der Uni Mannheim um eine Technische Fakultät ist vor wenigen Jahren aufgegeben worden. Nur Freiburg wurde im Wesentlichen so realisiert wie damals geplant. Ein wichtiger Faktor dabei war nach meiner Einschätzung auch, dass in Freiburg die bereits vorhandene Informatik in der Fakultät für Mathematik voll in die Planung und Umsetzung einbezogen wurde. Insbesondere wurde die Ausstattung der Professuren mit Sach- und Personalmitteln auf das Niveau der „neuen“ Professuren angehoben und langfristig abgesichert. Das war keineswegs selbstverständlich. Denn wie heute allgemein üblich wurde meinen Kollegen Peter Widmayer, Heinrich Müller und mir bei ihrer Berufung nur eine „Minimalausstattung“ auf Dauer zugesichert. Der Rest war befristet und drohte nach drei bis vier Jahren wegzufallen. Peter Widmayer und Heinrich Müller waren davon schon nicht mehr betroffen, weil sie nur sehr kurz in Freiburg blieben (P. Widmayer folgte 1992 einem Ruf an die ETH, Heinrich Müller 1992 einem Ruf an die Uni Dortmund.)

Damit war ich plötzlich nicht nur wieder der einzige Informatiker in Freiburg, sondern meine Berufungszusagen liefen auch aus, sodass ich die Gefahr sah, in Freiburg wissenschaftlich auf Dauer nicht überleben zu können. Zugleich stand das Projekt „15. Fakultät“ wegen des Wechsels des Ministerpräsidenten (von Späth zu Teufel, am 22.01.1991) Anfang 1991 auf der Kippe. Da hatte ich das Glück, erneut einen Ruf an eine andere Universität, und zwar an die Uni Trier, zu erhalten. Der damalige Kanzler, Herr Siburg, war vermutlich ohnehin der Ansicht, dass das Land die immensen Kosten für die neue Fakultät nicht aufbringen könne und würde (obwohl - dank HBFG - die Hälfte vom Bund getragen wurde); jedenfalls konnte ich ihn in meinen Bleibeverhandlungen davon überzeugen, dass es erforderlich sei, die bereits vorhandene Informatik so auszustatten, dass sie notfalls auch ohne die neue Fakultät überlebensfähig sei. Andernfalls könne er die Informatik in Freiburg „rückstandslos“ auflösen. Die Verhandlung war erfolgreich und ich blieb in Freiburg.

Als weiterer Glücksfall erwies sich, dass das mit dem Abzug der französischen Truppen in Freiburg freigewordene Gelände am Flugplatz für die neue Fakultät genutzt werden konnte. Bereits 1994 ist die Informatik in die erste sanierte Kaserne, das Geb. 051, eingezogen. Das war nicht nur der Beginn einer stürmischen Entwicklung sondern, wie bei solchen HBFG-Maßnahmen (diese Bund-Länder-Gemeinschaftsaufgaben gibt es heute nicht mehr) üblich, war der Umzug in neue Gebäude auch mit der Neubeschaffung der Ausstattung für Forschung und Lehre verbunden. Wir haben das u.a. dazu genutzt, eine damals top-moderne und teure neue Multimedia Infrastruktur (z.B. ein interaktives Whiteboard mit Rückproduktion, Videokameras, Schnittsoftware u.a.) zu beschaffen, die wir für Experimente im Bereich des Teleteachings und des mediengestützten Unterrichts nutzen wollten. Auf diesem von vielen meiner Fachkollegen meistens etwas argwöhnisch, weil als „unwissenschaftlich“ geltenden Gebiet hatten wir schon in Karlsruhe und auch während der ersten Jahre in Freiburg einige Erfahrungen gesammelt.

Teleteaching#

Mein Interesse für den Einsatz neuer Medien im Hochschulunterricht wurde nämlich schon Ende der 70er Jahre geweckt, als ich noch Mitarbeiter bei Hermann Maurer im AIFB in Karlsruhe war.

Er hat mit seinen damaligen Assistenten (dazu gehörten J. Albert, später Uni Würzburg, H.W. Six, später FU Hagen, und L. Wegner, später Uni Kassel) Videoaufzeichnungen von einer seiner Vorlesungen über „Programmierverfahren“ hergestellt und einer großen Zahl von künftigen Wirtschaftsingenieuren über Fernsehbildschirme im Hörsaal angeboten. Das war aus heutiger Sicht natürlich vergleichsweise wenig professionell und geschah mit sehr beschränkten technischen Mitteln.

Nach seinem Wechsel an die TU Graz hat Hermann Maurer das intelligente Bildschimrtextgerät MUPID entwickelt und als eine wichtige Anwendung für dieses Terminal ein Autoren System (Autool) zur Erstellung tutorieller Unterrichtslektionen.

Mit Hilfe dieses Systems haben dann viele der zahlreichen H. Maurer persönlich bekannten Kollegen interaktive Kurse hergestellt und über dieses Terminal angeboten. Ich selbst habe u.a. einen Kurs über „Geometrische Algorithmen“ sowie einige andere Kurse zu algorithmischen Themen erstellt.

Es wurde aber bald klar, dass die für Hermann Maurer’s Initiative benutzten MUPID-Rechner nicht mehr dem Stand der Technik entsprachen. Auch war der Aufwand für die Herstellung der Unterrichtslektionen zu hoch.

Mein Wechsel nach Freiburg 1987 hatte es erlaubt, im Rahmen der Erstausstattung des Instituts und der im Jahre 1988 erfolgten Berufung von Heinrich Müller von Karlsruhe nach Freiburg damals hochmoderne „Graphic Workstations“ (Silicon Graphics, Iris) zu beschaffen.

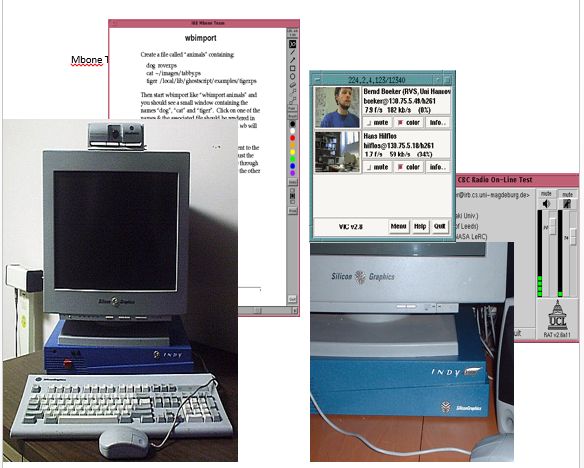

Auf diesen Workstations haben wir die ersten Erfahrungen mit rechnergestützter Präsentation und Übertragung von Lehrveranstaltungen über das Internet gesammelt und dazu die sogenannten MBone Tools (vic, vat, rat, wb) benutzt.

Wir haben also versucht, an die Spitze der damals verfügbaren Technologie zu gehen, ohne allzu viel Rücksicht auf den Bedarf an Speicherplatz und Netz-Bandbreite für die Speicherung und Übertragung von Videos zu nehmen.

Denn die bis heute gültige Erfahrung zeigt, dass solche Beschränkungen rasch durch den technischen Fortschritt wegfallen und es daher viel wichtiger ist, die in die Systementwicklung und Inhaltsaufbereitung investierte Mühe langfristig zu sichern.

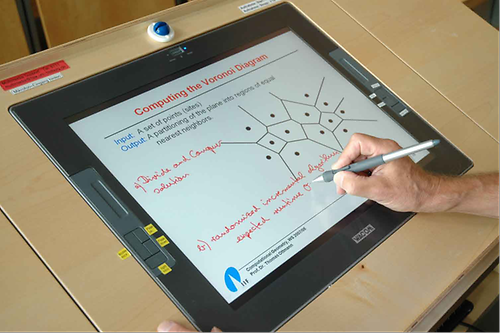

Vorlesungen in der Informatik und vielen anderen Wissenschaften werden heute in der Regel mit Hilfe einer Computerpräsentation gehalten: Der Dozent bereitet seine Folien am Rechner vor und präsentiert, annotiert und kommentiert sie dann „live“ im Hörsaal.

Da liegt es nahe, alle bei diesem „Ereignis“ erzeugten Datenströme, (Folien, handschriftliche oder graphische Annotationen des Dozenten, Audio- und Video- Strom des Dozenten und ggfs. auch der Studierenden, Simulationen und Animationen) direkt bei ihrer Erzeugung in möglichst guter Qualität digital zu erfassen, für die Wiederverwendung aufzubereiten und auf CD oder über das Netz Interessenten zugänglich zu machen. Das ist die Grundidee des „Authoring on the Fly“ (AOF) Ansatzes zur Vorlesungsaufzeichnung.

Inzwischen gibt es viele verschiedene Systeme, die dieses „Presentation Recording“ unterstützen. Man kann sie grob in drei Klassen unterteilen: Screen Grabbing Systeme, VCR Recording und objekt-basierte Aufzeichnung. Wir haben stets die objektbasierte Aufzeichnungsmethode favorisiert, weil hier die ursprüngliche, meistens symbolische Form der Repräsentation der Daten nicht verloren geht und ohne Qualitätsverlust an ganz verschiedene Ausgabeformate angepasst und vielfältig, z.B. für Strukturierung und Suche, genutzt werden kann. Unser Ansatz war und ist noch immer innovativ und bildet den Kern eines kommerziellen Produktes (Lecturnity) das sich erfolgreich am Markt behauptet.

Am Ende des vergangenen und zu Beginn des neuen Jahrtausends lagen unsere multimedialen Experimente unerwartet plötzlich im Mainstream der Entwicklung. Bund und Länder legten hochdotierte Förderprogramme zur multimedialen Unterstützung der Lehre auf, an denen wir maßgeblich beteiligt waren.

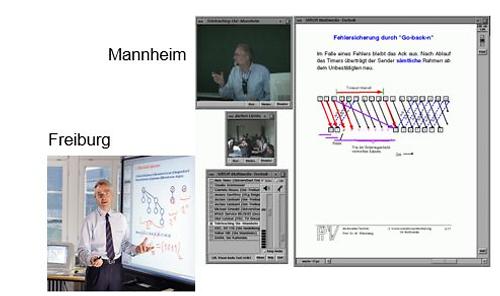

Ich nenne nur die vielen sicher noch bekannte Förderinitiative des Landes BW „Virtuelle Hochschule BW“, Förderzeitraum 1998 bis 2003, mit einem Volumen von insgesamt 25 Mio EUR. Davon entfiel auf das Freiburger Projekt „Viror“ (Virtuelle Hochschule Oberrhein) etwa ein Fünftel. 2001 folgte der Bund mit der Förderinitiative „Neue Medien in der Bildung“, in der 100 Projekte mit einem Fördervolumen von 200 Mio EUR durchgeführt wurden. Eines dieser Projekte war das von uns in Freiburg koordinierte Projekt ULI (Universitärer Lehrverbund Informatik), dessen Ziel es war, Informatik Studierenden an 12 Präsenzuniversitäten die Möglichkeit zu bieten, auch nicht vor Ort angebotene Vorlesungen und Seminare in das eigene Studium zu integrieren. Im Zuge dieser Projekte haben wir u.a. regelmäßig Vorlesungen von der Universität Mannheim (Prof. Effelsberg) und Uni Karlsruhe (Prof. Schmeck) nach Freiburg importiert, einige Vorlesungen von Freiburg an andere Hochschulen exportiert (Algorithmische Geometrie, Algorithmentheorie), und gemeinsame Seminare mit Kollegen aus Karlsruhe und Mannheim über das Netz durchgeführt. Auch für den netzgestützten Weiterbildungsstudiengang Winfoline haben wir so über mehrere Jahre Informatik Inhalte geliefert und Fern-Studierende über das Netz betreut.

Im Zentrum dieser Projekte standen die multimediale Aufbereitung von Inhalten, die Übertragung von Vorlesungen und das kooperative Arbeiten über das Internet, alles Aktivitäten, die heute selbstverständlich klingen, die es aber vor gut 10 Jahren nicht waren. Ein frühes Ergebnis unserer Bemühungen zur Aufbereitung von Inhalten ist das im Jahre 1998 im Spektrum Verlag erschienene Buch „Prinzipien des Algorithmenentwurfs“, das auf live gehaltenen und aufgezeichneten Vorträgen von 10 im Algorithmenbereich tätigen Hochschullehrern basiert [5].

Flankiert wurden diese Lehr-Projekte durch eine Reihe von Forschungs- und Entwicklungsprojekten, die einerseits der Verbesserung der technischen Infrastruktur galten und die in der Regel vom BMBF gefördert wurden, und die andererseits die didaktische und kognitionswissenschaftliche Seite des netzgestützten, multimedialen Unterrichts betrafen und in der Regel durch die DFG gefördert wurden. Hinzu kamen noch einige EU-Projekte, die sich mit dem Aufbau multimedialer digitaler Bibliotheken befassten.

Es zeigte sich recht bald, dass synchrone Lehr-Lern-Szenarien, also die Nutzung des Internets, um die Ortsbindung des Lehrens und Lernens aufzuheben, zwar technisch möglich, aber doch mit so vielen organisatorischen Problemen und Schwierigkeiten, die „Fernstudenten“ richtig einzubeziehen, verbunden war, dass sich diese Form des Lehr-Austausches bis heute nicht durchsetzen konnte. Wir haben daher versucht, das „Live-Ereignis“ Vorlesung möglichst perfekt und dennoch ohne großen Aufwand aufzuzeichnen, die Aufzeichnungen multimedial aufzubereiten, also den Studierenden einen echten „Mehrwert“ gegenüber einer reinen Video-Aufzeichnung zu bieten, und über das Netz orts- und zeitunabhängig verfügbar zu machen. Dazu gehörten auch die entsprechende Ausstattung der Hörsäle und die weitgehende Automatisierung des „Workflows“ (also die Vor- und Nachbereitung der Aufzeichnung und die Einstellung der Aufzeichnung in das Electures Portal der Technischen Fakultät).

Mit großer Hartnäckigkeit haben meine Mitarbeiter und ich so über fast 20 Jahre das Ziel verfolgt, unseren Studierenden die Möglichkeit zu geben, wenigstens einen Teil ihres Studiums „virtuell“, genauer, im Fernstudienmodus zu absolvieren. Zugleich habe ich es immer bedauert, dass Universitäten die Wissenserzeugung und -vermittlung in Vorlesungen nicht optimal nutzen. Denn das Halten von Vorlesungen ist seit Jahrhunderten ein unverrückbarer Bestandteil der Wissensvermittlung an Universitäten, der alle technischen Innovationen überlebt hat, und den ich insbesondere in den systematischen Wissenschaften (Mathematik, Physik, Ingenieurdisziplinen, Informatik) nach wie vor für unverzichtbar halte. Denn in „Vorlesungen“ werden ja nicht einfach, wie vielleicht im Mittelalter, Bücher vorgelesen, sondern teilweise komplexe Inhalte didaktisch aufbereitet und in (hoffentlich) verständlicher Form „live“ vermittelt. Ich habe viele Beispiele hervorragender Lehre dieser von Hochschuldidaktikern oft kritisierten Form der „Ex-cathedra-Lehre“ erlebt, die bedauerlicher Weise nicht konserviert wurde und weder für Studierende nutzbar gemacht wurde noch zum Aufbau eines „institutionellen Gedächtnisses“ einer Universität oder Fakultät beitrug. Darauf, dass Universitäten lernen müssen, diese Form der „Wissensproduktion“ besser zu nutzen, hat D. Tsichritzis schon 1999 hingewiesen [6].

An der Technischen Fakultät der Uni Freiburg hat das von meinen Kollegen und mir auf diesem Gebiet in mehr als 15 Jahren praktizierte Vorbild allerdings seine Wirkung nicht verfehlt: Inzwischen gehört hier das Aufzeichnen von Vorlesungen und Bereitstellen im Electures Portal der Fakultät zu einem von Studierenden rege nachgefragten Routine Dienst. Die Furcht, dass Studierende nicht mehr zu den Dozenten in die Vorlesung kommen, wenn sie dasselbe auch orts- und zeitunabhängig über das Netz geboten bekommen, gibt es zwar immer noch, die offensichtlichen Vorteile für Studierende und Dozierende überwiegen diese Befürchtungen aber. Dazu beigetragen hat auch die Ausstattung unserer Hörsäle mit moderner Projektions- und Aufzeichnungstechnik. Wir können durch viele Untersuchungen belegen, dass gut gemachte und richtig eingesetzte Vorlesungsaufzeichnungen einen wichtigen Beitrag zum Kompetenzerwerb im Studium liefern können. Um Informatikkonzepte und –inhalte zu verstehen und anwenden zu können müssen wir unsere Studierenden nicht zu bestimmten Zeiten in den Hörsaal zwingen. Die gleichen Lernergebnisse und manchmal sogar bessere lassen sich auch mit Vorlesungsaufzeichnungen erzielen, wenn man sie richtig nutzt, z.B. für eine strukturierte und moderierte Gruppendiskussion. (Das ist ganz im Sinne der Bologna Reform. Anwesenheitskontrollen in Vorlesungen sind da eher eine Perversion der an Lernergebnissen, und nicht am „Input“ orientierten Studienreform.)

Wir haben Systeme zur Aufzeichnung von Computer Präsentationen nicht nur zur multimedialen Aufbereitung von Lehrinhalten und zum Kern von Online-Kursen (wie z.B. in Winfoline und IEMS) gemacht. Vielmehr haben die bei Nutzung dieser Systeme gesammelten Erfahrungen und Probleme auch immer wieder neue Entwicklungen angestoßen und nicht leicht zu lösende Forschungsfragen grundlegender Art aufgeworfen. Ich nenne als Beispiel nur das bis heute in keinem dieser Systeme befriedigend gelöste Problem der Darstellung von Handschrift, die mit einem digitalen Stift erzeugt wird.

Um die persönliche Note einer Handschrift zu erhalten und gleichzeitig keine Qualitätseinbußen beim Herauf- oder Herunterskalieren der Pixelspur des Stiftes („digital ink trace“) in Kauf nehmen zu müssen, muss man die Pixelspur noch während der Erzeugung durch eine symbolisch beschriebene Kurve approximieren. Das ist mathematisch anspruchsvoll und technisch nicht einfach zu lösen.

Mein letzter Doktorand hat dafür einen neuen bemerkenswerten Vorschlag (Approximierung durch rationale Bezier Kurven zweiter Ordnung) gemacht, der vielleicht ebenfalls irgendwann Eingang in ein kommerzielles Produkt finden wird.

Rückblick#

Im Rückblick kann ich mit einiger Befriedigung feststellen, dass ich in den letzten 35 Jahren an der Entstehung und Gestaltung einer neuen Disziplin mitwirken konnte. Dazu beigetragen hat auch, dass ich immer wieder mit Kollegen in aller Welt zum Teil über viele Jahre sehr erfolgreich zusammenarbeiten konnte. 1999 hatte ich eine Gastprofessur am Dartmouth College, NH, USA. Am längsten, über viele Jahre zusammengearbeitet habe ich mit Derick Wood an den verschiedenen Orten seiner Tätigkeit in Canada (Hamilton, Waterloo, London Ontario) und an der HUST, Hongkong, und mit Amitava Datta, UWA, Perth Australien.Die ersten 30 Jahre der Forschung und Entwicklung der Informatik waren gekennzeichnet von dem Ziel, Computer zu einem leicht bedienbaren und nützlichen Werkzeug für vielfältige Anwendungen, insbesondere für Alltagsaufgaben zu machen. Dazu wurden Programmiersprachen, Compiler, Betriebssysteme, Datenbank- und Informationssysteme und viele neue Algorithmen entwickelt. Das diesen Entwicklungen zugrunde liegende theoretische Fundament, insbesondere das Konzept des speicherprogrammierbaren von Neumann Rechners hat sich als erstaunlich tragfähig und als (bis heute) sehr stabil erwiesen. Die Kerngebiete des Fachs, die alle auch in Freiburg vertreten sind (Algorithmen, Programmiersprachen und Software-Technik, Rechnerarchitektur und Betriebssysteme, Kommunikation und Datenhaltung) haben sich in dieser Zeit ausdifferenziert, kontinuierlich weiterentwickelt, und haben inzwischen einen stabilen methodischen Kern. Dabei hat sich gleichzeitig die Technik in einem atemberaubenden Tempo weiterentwickelt und verlangt nicht nur von Hochschullehrern für Informatik, sich ständig anzupassen und in neue Systeme einzuarbeiten.

Wir sind heute mit neuen Herausforderungen konfrontiert: Computer sind allgegenwärtig, Rechentechnik, Informations- und Kommunikationstechnik wachsen zusammen, jedermann hat Zugriff auf riesige Mengen digitaler Information, und es scheint, als würden wir langsam die physikalisch-technische Grenze der Performanzsteigerung des Computers erreichen. Jedenfalls hat die Miniaturisierung von Schaltelementen und ihre Verdichtung auf einem einzelnen Chip inzwischen eine Grenze erreicht, die in die Größenordnung der Atom Abstände kommt. Ohne Abkehr vom von Neumannschen Prinzip eines einzelnen Prozessors scheint also eine Performanzsteigerung von Rechnern mit nur einem Prozessor bald nicht mehr möglich zu sein. Das ist der Grund, weshalb Multicore Rechner und GPGPUs (General Purpose Graphic Processing Units) zunehmende Bedeutung erlangen. Allerdings ist man hier noch weit von dem für die Programmierung von von Neumann Rechnern bekannten Abstraktionsniveau mit klarer, hardwareunabhängiger Programmier Schnittstelle entfernt, sodass die Entwicklung effizienter Algorithmen für diese Architektur schwierig ist. Diese und andere neue Anwendungen erfordern also auch eine neue Theorie. Die heute jungen Informatiker haben – wie wir vor 30 Jahren – die Chance, dies mit zu gestalten und so die Basis für die künftige Entwicklung zu legen.

Am Schluss dieses Rückblicks auf mein berufliches Leben könnte der falsche Eindruck entstehen, dass das Private darin keine Rolle gespielt hat.

Das Gegenteil ist richtig: Seit nunmehr 40 Jahren sind meine Frau und ich gemeinsame Wege gegangen. Jeder von uns hat seinen Beruf mit Leidenschaft ausgeübt, sie als Lehrerin, ich als Hochschullehrer. Als wir geheiratet haben, hat natürlich keiner gewusst, was kommen würde. Für sie als Lehrerin wären aber ein dreimaliger Ortswechsel mit Hausbau und dem völligen beruflichen und privaten Neubeginn in unbekannter Umgebung und die zahlreichen Aufenthalte an ausländischen Universitäten gewiss nicht notwendig gewesen. Dass sie, ebenso wie unsere beiden Kinder, meine tatsächlichen oder „gefühlten“ beruflichen Zwänge akzeptiert hat, ist alles andere als selbstverständlich; dafür bin ich ihr sehr dankbar.

Am Ende dieses Vortrages sollte klar sein, was bleibt:

Es sind die grundlegenden Konzepte und Methoden des Fachs, die langfristig Bestand haben und die sich im Laufe der Zeit nur wenig ändern. Sie sind m.E. das Wichtigste, das wir unseren Studenten im Studium vermitteln sollten. Allerdings leben wir in einer Zeit dramatischen Wandels und die Informationstechnik ganz allgemein und die Informatik im Besonderen ist ein wesentlicher Treiber dieses Wandels. Es bleibt eine Herausforderung an die junge Generation von Wissenschaftlern, diesen Wandel mit zu gestalten und die ihm zugrundeliegenden Prinzipien herauszuarbeiten.

Literatur#

[1] E. Börger (Ed.): Computation Theory and Logic, Springer LNCS, vol. 270, 1987[2] J. Bentley, Th. Ottmann. Algorithms for Reporting and Counting Geometric Intersections. IEEE Trans. Comput. C-28, 9, pp. 643-647. 1979.

[3] Th. Ottmann, P. Widmayer: Algorithmen und Datenstrukturen, xvii-716 Seiten, 4. Auflage, Spektrum Akademischer Verlag, Heidelberg, 2002

[4] HBFG: Hochschulbauförderungsgesetz, Gesetz über die Gemeinschaftsaufgabe „Ausbau und Neubau von Hochschulen“

[5] Th. Ottmann (Ed.): Prinzipien des Algorithmenentwurfs, Spektrum Verlag, 1998

[6] Tsichritzis, D.: Reengineering the university. In: Communications of the ACM 42, (6), 1999, 93-100

vor Ihrem 'wechsel nach freiburg'

'... nur mit wirtschaftsingenieuren ... '

jetzt verstehe ich, warum wir so wenig über IT hörten ![]()

-- gamauf gerald antal, Donnerstag, 10. August 2017, 00:14