Fahrerloses Dilemma#

Künstliche Intelligenz auf der Straße: Wie soll ein selbstfahrendes Auto bei Unfallgefahr entscheiden?#

Von der Wiener Zeitung (Samstag, 25. Juni 2016) freundlicherweise zur Verfügung gestellt.

Von

Eva Stanzl

Wien. Wenn Nir Gideon auf der Autobahn überholt, wirkt das fast wie Magie. Der 34-Jährige legt die Hände in den Schoß und schaut zu, wie der Blinker angeht, das Auto die Spur wechselt, beschleunigt und an der hügeligen Landschaft vor Jerusalem vorbeibraust. Gideon testet das autonome Fahren für die israelische Firma Mobileye. Das Unternehmen entwickelt Technologie für Roboterautos, samt Kamerasystem, Algorithmus und speziellem Chip.

Die Kameras erfassen die Gefahren. Der Chip steuert die Elektronik und stoppt das Auto, um Unfälle zu verhindern. Die Technologie ist anders als jene des Rivalen Google, der statt Kameras auf Laserradar setzt. Mobileye arbeitet mit VW, BMW, Volvo und dem Elektroauto-Hersteller Tesla. Denn dass die Straße künftig selbstfahrenden Fahrzeugen gehört, gilt unter Autokonzernen als ausgemacht: Zwischen ihnen ist ein Wettlauf entbrannt. Ihrer Ansicht nach könnten autonome Autos bis zu 90 Prozent der Unfälle auf der Straße vermeiden.

Programme reichen nicht an menschliche Intuition heran#

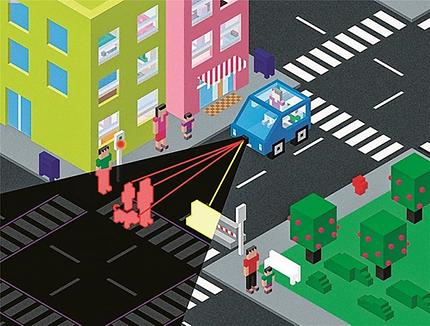

Was ist aber dann, wenn es doch passiert? Wer trägt bei Unfällen die Verantwortung, wenn kein Fahrer, sondern ein Algorithmus am Steuer sitzt? Zu diesem Zweck sind an Gideons weißem Audi acht Kameras befestigt für eine 360-Grad-Sicht. Ein Bildschirm neben dem Lenkrad zeigt an, was die Kameras sehen: Die freie Fläche vor dem Auto ist ungefährlich grün, weiter entfernte Fahrzeuge sind gelb, nahe, potenziell gefährliche rot umrandet. Und letztlich muss das Auto aus allen Daten eine Entscheidung treffen: Was tun, wenn von links ein Fußgänger vor das Auto läuft, rechts aber ein Fahrradfahrer kommt? Und was, wenn fünf Fußgänger plötzlich über die Fahrbahn rennen? Das fahrerlose Auto könnte ausweichen - wenn es (rechts) in eine Betonwand oder (links) in einen Abgrund fährt. Dabei könnte jedoch aber der Passagier zu Tode kommen.

"Damit ein Auto voll autonom wird, muss es menschliche Intuition und ein menschliches Gefühl haben", betont Lior Sethon, Europa-Chef von Mobileye, in einem Interview mit der Austria Presse Agentur. Das bedeutet: Autos müssen ethisch richtige Entscheidungen treffen können.

Um eine öffentliche Debatte dazu anzustoßen, haben französische Forscher der Universität Toulouse US-Bürger befragt, wie selbstfahrende Autos ihrer Meinung nach in Gefahrensituationen agieren sollten. Die Forscher um Jean-Francois Bonnefon führten sechs Online-Befragungen im Zeitraum zwischen Juni und November 2015 durch. Zusätzlich konnten die Testpersonen unterschiedliche Unfall-Situationen interaktiv nachstellen.

Im Allgemeinen fanden die Befragten, dass autonome Wägen den geringstmöglichen Schaden für alle verursachen sollten - selbst wenn dies ihren Passagieren schadet. Jedoch wollte niemand selbst in einem solchermaßen "utilitaristischen" Auto sitzen.

Somit würde sich laut der Studie kaum jemand ein selbstfahrendes Auto kaufen, das bei Gefahr dem Prinzip des größten Guts für die Meisten folgt. Stünde daneben ein Wagen, der zuallererst die eigenen Interessen schützt, würden die meisten Menschen dieses Modell nehmen. Jedoch würden die Befragten sich wünschen, dass allen stets utilitaristische Autos fahren. Und somit erzeugen Fragen, die der Mensch situativ-intuitiv entscheidet, unauflösliche Widersprüche aus, wenn sie auf die künstliche Intelligenz umgelegt werden müssen.

Wenn die Prognosen zur geringen Unfallhäufigkeit halten, würden solche Dilemmata freilich selten auftreten. "Wenn aber Millionen von Wägen unterwegs sind, wird selbst das Unwahrscheinliche wahrscheinlich - und vielleicht sogar unvermeidlich", warnt der Psychologe Joshua Greene vom Zentrum für Hirnforschung der Universität Harvard in einem Kommentar zu der Studie, und: "Selbst wenn nie Gefahr im Verzug ist, müssen autonome Autos so programmiert werden, dass sie im Notfall richtig reagieren."

Bonnefon und seine Kollegen räumen überdies ein, dass autonome Gefährte auch die Wahrnehmung des Autos an sich verändern könnten. Heute sehen wir die eigenen vier Räder als persönlichen Besitz. Die Idee, dass sie uns töten könnten, ist uns fremd und hat etwas von einem Betrug, der unter keinen Umständen passieren darf. Das könne sich ändern, so Bonnefon, wenn das Auto nur noch ein Glied im Verkehrssystem ist, austauschbar wie ein U-Bahn-Waggon oder eine Straßenbahn. Dann könne es sein, dass die Menschen durchaus für Modelle optieren, die die Sicherheit insgesamt erhöhen.

Dornigste Herausforderung der künstlichen Intelligenz#

Kritik wird anfallen, egal, für welche ethischen Prinzipien die Hersteller optieren. "Erzeuger werden daher wenige Anreize verspüren, ihre Arbeitsgrundlagen transparent zu machen", betont Greene: "Bei utilitaristisch angelegten Algorithmen wird es einen Aufschrei geben, weil diese Autos ihre Passagiere zu opfern gewillt sind - und für Programme, die Passagiere schützen, Proteste, weil die Wägen mehr Leben kosten als nötig."

"Die Frage, wie eine ethische Maschine zu bauen ist, ist eine der dornigsten Herausforderungen der künstlichen Intelligenz", so Bonnefon. Anders als Politiker, Philosophen und eigensinnige Verwandte genießen Software-Ingenieure nämlich nicht den Luxus der unbestimmten Abstraktion. Sie können ihren Maschinen nicht über Zahlen eingeben, die Rechte anderer zu respektieren, tugendhaft zu sein oder nach Gerechtigkeit zu streben. "Zumindest nicht, solange wir keine moralischen Kriterien haben, die präzise festlegen, was erfüllt sein muss, damit es Tugend ist, und welche Tauschgeschäfte gerechtfertigt sind", so Greene: "Die Studie zeigt uns, wie schwierig es sein wird, autonome Maschinen zu bauen, die unseren ethischen Empfindungen entsprechen. Bevor wir ihnen nämlich Werte geben können, müssten wir uns überlegen, wie wir klare, konsequente und beständige Werte schaffen könnten." Kann sein, dass die Ethiker gerade hier Gummi geben müssen.

Weiterführendes#

- Thema Verkehr: (Essaysammlung)