Vom digitalen Bild zum maschinellen Sehen#

Franz Leberl, August 2017

Inhaltsverzeichnis

- Vom digitalen Bild zum maschinellen Sehen

- Eine Pionierleistung der Technischen Universität Graz

- Es begann im Weltraum

- Digitalbilder erobern viele Labors

- Nobelpreis 2009

- Digitalkameras

- Konsum-Kameras

- Spezialkameras am Beispiel der Luftbilder

- UltraCam

- Vom Einzelbild zu Bildfolgen

- Digitale Bilder und ihr Informatik-Umfeld

- Algorithmen

- Ausblick

Eine Pionierleistung der Technischen Universität Graz #

Robotik, automatische Navigation, autonomes Bewegen und Fahren, industrielle Qualitätsprüfung, medizinische Bildgebung, Biometrie, Prozess- und Situationsüberwachung vertrauen heute allesamt auf die rasanten Fortschritte in der Computer Vision. Dieses Thema begann in der Elektrotechnik, weil der Fokus zunächst auf bildgebenden Sensoren lag. Dort entwickelte es sich zur „digitalen Bildverarbeitung“ mit dem Ziel von „schönen Bildern“. Die Informatik entdeckte das Gebiet erst ab etwa 1985, als die Betonung weg von der Erzeugung digitaler Bilder hin zur deren Analyse und der damit verbundenen Algorithmik wanderte. Computer Vision war eine neue Bezeichnung für die akademischen Tagungen CVPR, ICCV, ECCV, ACCV [CV = Computer Vision]. Das Thema bewegte sich ins Zentrum der Informatik. Die neueste 2017-CVPR Tagung in Hawaii hatte 6.000 registrierte, meist universitäre Teilnehmer. Es gibt heute kaum ein akademisches Informatik-Team, in welchem die Computer Vision nicht eine tragende Rolle einnimmt.

Es war eine Pionierleistung der TU Graz, 1992 ein Universitätsinstitut zu diesem Thema einzurichten. Und ich hatte das Privileg, dieses Institut gestalten zu dürfen. Dass Mancher zu meiner bunt bebilderten 1993-Antrittsvorlesung meinte, es werde hier ein Institut für Unterhaltungsmedien gestartet, war durch die erbrachten technischen Leistungen bald vergessen. Wir verwenden in unserem Universitätsinstitut an der TU Graz den Begriff „Maschinelles Sehen“ als Übersetzung des englischen „Computer Vision“.

Es bleibt allerdings anzumerken, dass sich schon 1980 das damalige Forschungszentrum Graz [heute Joanneum Research] auf die Einrichtung eines neuen Institutes für digitale Bildverarbeitung Graz [DIBAG] eingelassen hat. In der Gründungsphase ab 1980 bis zu meinem Ausscheiden im Februar 1984 war ich mit dem Aufbau dieses Institutes befasst.

1984 waren dort mehr als 50 Personen beschäftigt. Graz entwickelte sich mit diesem Forschungsinstitut und dem Universitätsinstitut zu einem Zentrum des maschinellen Sehens.

Es begann im Weltraum#

Erste digitale Bilder entstanden im Jahr 1964 via die Ranger-Rakete #7 von der Mondoberfläche. Vidikon-Bilder wurden zur Erde gefunkt und im Labor als Zahlenreihe analysiert. Kurz darauf kamen erstmals digitale Bilder im Rahmen der Mariner-4 Mission zum Planeten Mars zur Erde. Bis dahin waren Weltraumbilder mittels analoger Fernseh-Kameras erzeugt worden, und diese Analogsignale wurden zur Erde gefunkt. Neu war, dass nun analoge Signale am Sensor A/D-gewandelt und als Zahlenreihe übertragen wurden. Erste Publikationen berichteten etwa von Methoden, aus diesen Bildern die Höhe von Kraterrändern zu messen.

Ich war ein Glückspilz, dass ich 1974 an das Jet Propulsion Laboratory im kalifornischen Pasadena kommen konnte, und dort als Mitarbeiter des California Institute of Technology die Projekte der frühen digitalen Bildverarbeitung in der Weltraumforschung entdecken durfte. Dort bestand im Jahr 1974 eine Organisationseinheit für Digitale Bildverarbeitung [Digital Image Processing}. Von meiner Ausbildung als Photogrammeter und meiner holländischen Arbeit in der Luftbildmessung und Radarbildverarbeitung in Entwicklungsländern war ich mit Messverfahren in Filmbildern vertraut, für die neuartigen Digitalbilder durfte ich solche Verfahren im Team überlegen. Aus der 1972-Mondmission Appollo-17 waren 3 ganze Umrundungen des Mondäquators mittels eines analogen Side-Looking Radarsystems ALSE entstanden. Die 50 Meter lange und nur 10 cm breite Filmrolle wurde mir zur Analyse anvertraut. Durch diese Radarbildprojekte auf dem Mond, aber auch in der Amazonasregion, in der meist dunklen Arktis mit ihrem Meereseis, in den NASA Shuttle Imaging Radar Projekten und bei der Erforschung des Planeten Venus in der NASA Magellan-Mission entwickelte ich mich zum „Mister Radargrammetrie“.

Digitalbilder erobern viele Labors#

Zunächst leuchtete schnell ein, dass die digitalen Bilder den großen Vorteil hatten, dass man sie im Computer verarbeiten konnte. Das war objektiver als die visuelle Analyse von Filmaufzeichnungen und natürlich automatisierbar. Die meisten Digitalbilder entstanden aus digitalisierten Video-Signalen oder aus abgetasteten Filmbildern. Eine wesentliche Bildquelle waren auch nicht-optische Sensoren wie Radar-, Wärme- und Unterwasser Sonar-Systeme. Ein sehr frühes Anwendungsgebiet auf der Erde war die Fernerkundung. Ab etwa 1966 wurden Bilder aus Flugzeug-getragenen Multispektralkameras analog aufgezeichnet und digital verarbeitet. Dies kulminierte 1972 im ersten massiven Satellitenkamerasystem, dem LANDSAT-Programm der NASA, in einer weltweiten Verbreitung von digitalen Bildern und ihrer Verarbeitung.

Wo immer Filmbilder eine technisch-wissenschaftliche Anwendung hatten, setzte sich rasch eine digitale Verarbeitung durch. In der Medizin dauerte es nicht lange, bis Röntgen-Bilder digitalisiert und im Computer verarbeitet wurden. Dies war auch die Periode, in welcher die Computertomographie erfunden und rasanten Einzug in der Medizin hielt: 1971 wurde der erste CAT-Scanner in Betrieb genommen, 1979 erhielten die Erfinder Godfrey Hounsfield und Allan Cormack den Medizin-Nobelpreis.

R. Beichel ICG 2006

Das Gebiet nahm einen enormen und raschen Aufschwung. Die Sensorik blieb lange Zeit analog, aber Video und andere Signale wurden A/D-gewandelt. Außerdem begann die computergerechte Aufbereitung des großen Bestands an Filmarchiven durch Filmabtastung. Es entstand ein signifikanter Markt für Film-Scanner. Im Grafik-Gewerbe und in den Druckereien wurde damit sehr schnell auf die Computerbearbeitung von Bildern umgestellt. Das Teilgebiet der Reprographie war ein frühes Opfer des Übergangs zu Digitalbildern und verschwand vom Markt.

Ich entwickelte daher im Rahmen einer US-Firmengründung im Jahr 1984 eine Technologie zur Präzisionsabtastung von großformatigen Filmbildern (Firma Vexcel Corporation, Boulder Colorado). „Präzision“ bezeichnet hier eine geometrische Genauigkeit im Bereich von etwa ± 1 µm über das Bildformat, welches in der Luftbildmessung meist 25 cm x 25 cm umfasst. Eine Nachfolgetechnologie entstand ab 1993 in der österreichischen Schwesterfirma Vexcel Imaging GmbH und entwickelte sich zum Weltmarktführer in der Präzisionsabtastung. Scanner wurden bis 2006 ausgeliefert.

Nobelpreis 2009#

Die Computerverarbeitung von Bildern wurde durch eine davon unabhängige Entwicklung enorm dynamisiert: Etwa 1970 entdeckten zwei Forscher in den Bell Laboratories, wie man mittels sogenannter Charge-Coupled Devices [CCDs] Bilder machen kann. Das begann mit einigen in einer Zeile aufgereihten Bildelementen [Picture Elements oder Pixel]. Die Zeile gewann rasch an Länge, und es gelang der Sprung auf 2 Dimensionen, zunächst mit sehr schmalen Formaten von vielleicht 100 x 100 Bildpunkten. Digitale Flächensensoren überzeugten durch geringeres Rauschen als Filmbilder und einen größeren Dichteumfang. Es dauerte nur etwa 5 Jahre, bis erste digitale Kameras in der Astronomie zum Einsatz kamen. In den darauf folgenden zwei Dekaden entstand eine Vielzahl an kommerziellen digitalen Kamera-Produkten, die Flächensensoren wuchsen, sodass die heute übliche Dimensionen von CCD-Flächensensoren etwa 7K x 4K Pixel betragen [etwa in einer kommerziellen Luftbildkamera UltraCam]. Farbe wurde mittels eines mit „Bayer-Pattern“ bezeichneten Zuganges erfasst. Schon zirka 2000 wurden mehr digitale Kameras verkauft als solche auf Filmbasis. Der Verfall des Films wird durch den Niedergang der Firma Kodak sichtbar.

Die Technologie der CCDs hatte einen solchen Schwung entfaltet, dass deren Erfinder in den Bell Labs, Willard Boyle und George E. Smith, 2009 mit dem Nobelpreis für Physik ausgezeichnet wurden.

Heute konkurrieren CMOS-Sensoren mit CCD-Sensoren. Erstere sind billiger in der Herstellung und verbrauchen weniger Strom. Aber sie liefern einen geringeren Dichteumfang und höheres Rauschen. Allerdings reicht die Leistungsfähigkeit der CMOS Sensoren, um sie in den Kameras von Smartphones einzusetzen. Das Smartphone mit seiner Kamerafunktion hat wiederum den Markt für digitale Konsum-Kameras zerstört.

Digitalkameras#

Konsum-Kameras#

Der Ersatz des Films durch eine CCD-Sensorfläche war eine recht geradlinige Entwicklung ohne große Komplexität. Damit wurde die Welt durch Digitalkameras überschwemmt. Und weil durch den Verzicht auf Film die mit einem Digitalbild verbundenen Kosten verschwunden waren, entstand eine wahre Bilderflut. Das Filmkleinbild mit seinem Format von 24 mm x 36 mm war schnell durch CCD-Sensoren mit 4K x 2,6K-Pixeln übertroffen, denn dies lieferte Bildpunkte einer Größe von 9 µm x 9 µm und eine Grauwertauflösung von 12 Bit oder 4096 Grauwerten. Film hingegen lieferte einen Grauwertumfang von nur 8 Bit oder 256 Grauwerten.

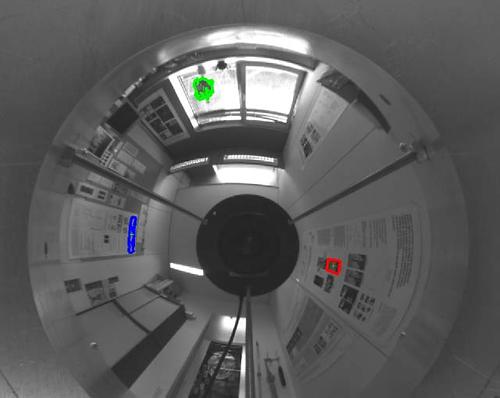

Die Massenerzeugung von Digitalkameras reduzierte die Fix-Kosten und erleichterte damit die Installation solcher Kameras allerorten, entlang von Straßen, bei Geschäftseingängen, in Einkaufszentren usw. Da keine variablen Bildkosten bestehen, können beliebig viele Bilder erzeugt und gespeichert werden.

Spezialkameras am Beispiel der Luftbilder#

Obwohl nun nachweislich für die Konsumenten etwa im Jahr 2000 die Filmkamera von der Digitalkamera verdrängt war, galt dies nicht für die hochtechnische Erzeugung von Luftbildern. Das Bildformat mit 25 cm x 25 cm müsste durch ein Digitalbild von etwa 11K x 11K abgelöst werden. Solche CCD-Sensoren gab es nicht. Es war also bis 2000 keine Lösung für digitale Luftbildkameras bekannt. Die Firma Leica (Schweiz) umrundete das Problem durch Verwendung einer Kamera mit nur Zeilensensoren. Ein unruhiges Flächenbild entstand durch die kinematische Vorwärtsbewegung der Kamera und das wiederholte Auslesen der Zeilen. Die Firma Zeiss (Deutschland) erzeugte ein großformatiges Bild durch Aneinanderfügung von 4 Flächen-Kameras. Diese Lösungen waren sehr kostspielig und hatten Mühe, die erwarteten Genauigkeiten von ±1 µm nachzuweisen. Dadurch waren sie gegenüber Filmkameras zunächst nur beschränkt konkurrenzfähig Dies eröffnete die Gelegenheit für ein innovatives Konzept.

UltraCam#

Als Reaktion auf die damals ungeschickt wirkenden Lösungen der Firmen Leica und Zeiss fühlten wir uns in Graz bei der Firma Vexcel Imaging ermutigt, ein alternatives, innovatives und kostengünstiges Konzept einer Luftbildkamera mit einer Bildbreite von 11K Pixel zu entwickelten, die UltraCam. Aus kostengünstigen Komponenten gebaut, erforderte das System einen hohen Software-Aufwand, um eine hohe geometrische Genauigkeit zu sichern. 8 Objektive und 13 kleinere CCD-Flächensensoren produzierten sehr genaue, rauschfreie Bilder mit hohem Dichteumfang. Nach ersten Auslieferungen im Jahr 2003 eroberte dieses Produkt die Weltmarktführerschaft und wird heute in mehr als der Hälfte aller Luftbildunternehmen verwendet.

Vom Einzelbild zu Bildfolgen#

Zu Zeiten der Filme war ein Bild mit relativ hohen Material- und Laborkosten verbunden und es galt in der Luftbildmessung, die Zahl der verwendeten Bilder zu minimieren. Um 3-dimensionale Szenenmodelle herzustellen, verwendete man Bildpaare, also 2 Bilder pro Objektpunkt. Nicht nur war das die minimale Zahl an Bildern zur Rekonstruktion des 3D Raumes, es entsprach auch dem menschlichen Sehmodell mit 2 Augen und dem menschlichen binokularen (Stereo-)Sehen.

Der Übergang zu kostenfreien Digitalbildern erlaubte die hemmungslose Vervielfachung der Bilder. Das musste aber mit der Verfahrensentwicklung einhergehen, sodass man im Computer eben nicht 2, sondern vielleicht 10 oder 20 Bilder pro Objektpunkt verarbeiten musste, der Computer verfügte damit über eine Vielzahl von Augen. Der Vorteil war eine höhere Robustheit automatischer Bildbearbeitungsverfahren und die Verbesserung der Genauigkeit durch erhöhte Redundanz.

Digitale Bilder und ihr Informatik-Umfeld#

Digitale Kameras und andere Sensoren hätten niemals die rasante Entwicklung genommen, wenn sich nicht das Informatik-Umfeld dynamisch entwickelt hätte. Denn der typische Bildprozess berührt nahezu alle Elemente der Informatik:

Sensor-Plattform ![]() Bilderfassung

Bilderfassung ![]() Bildübertragung

Bildübertragung ![]() Bildspeicherung

Bildspeicherung ![]() Bildanalyse

Bildanalyse ![]() Visualisierung

Visualisierung

(1) Wir benennen hier die Plattformen wie Satelliten, Flugzeuge, Drohnen, Fahrzeuge, Handhaltung, Mikroskope oder medizinische Systeme. Bewegte Plattformen müssen navigieren, müssen vorgegebene Stationen berühren und stellen hohe Navigationsanforderungen. (2) Bilder werden nicht nur mittels herkömmlichen Kameras erfasst, sondern auch durch Wärme- und Multispektral-Kameras, aber auch mit Mikrowellensensoren [Radar], Schallgeräten [Sonar], Röntgen oder tomographischen Apparaten. Die Apparate selber sind computergesteuert. (3) Diese Bilder müssen von einem Ort zu einem anderen transferiert werden, wozu Kommunikationskanäle mit ausreichender Bandbreite notwendig sind. (4) Dann gilt es, die Daten zu speichern und vorzuhalten. (5) Schließlich werden mittels immer komplexeren Verfahren die Bildinhalte analysiert. (6) Ergebnisse werden sichtbar gemacht.

All diese Systemkomponenten haben von glücklichen Leistungserhöhungen im Sinne des Moore’schen Gesetzes profitiert. Wie oft waren die Rechnerleistungen in der Vergangenheit nicht an der Grenze des Erfolges? Und einige wenige Quartale später war die Rechnerleistung bei weitem ausreichend. Mit der Erfindung der Graphical Processing Unit GPU wurde gar die Rechnerleistung als eine Einschränkung des Möglichen ausgeschaltet.

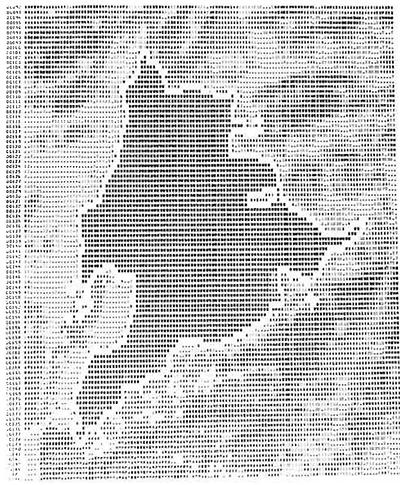

Im Jahr 1978 war die Visualisierung eines Bildes auf Papier [„Hardcopy“] noch ein großes Hindernis. Bild 8 zeigt einen Papierausdruck durch Übereinander-Drucken von Zeichen. Die am Fußboden ausgebreiteten Papierbahnen wurden mittels Leiter von oben auf Film fotografiert. Heute hat jeder Haushalt einen Filmdrucker für Digitalfotos, der höchsten Qualitätsansprüchen genügt.

Und gerade als die Vibrations- und Vakuum-empfindlichen konventionellen Plattenspeicher in vibrierenden, hochfliegenden Flugzeugen ein Problem darstellten, kamen die SSD-Speicher zu Hilfe, die gegen Kälte, Vibrationen und niedrigem Luftdruck unverwundbar waren.

In der Periode von 1979 bis 1993 war ich Mitglied des NASA Science Teams zur Erforschung des Planeten Venus in der Magellan Mission. Dazu wurde der gesamte Planet 3x mit Radarbildern aus einem Sensor in einer Venus-Umlaufbahn bedeckt. Das Ergebnis war 1992 der größte Bilddatensatz mit 400 GBytes. Daten-Management war ein großes Thema. Bilder waren zu ordnen und man wollte und musste schnell auf jedes Bild zugreifen können.

Die Mühen der NASA-Magellan-Mission wurden durch die Entwicklung der sozialen Medien seit etwa 2004 hinweggespült. Facebook speichert heute 250 Milliarden Bilder und stellt dazu 300 PBytes an Speicher zur Verfügung. Auf jedes Bild kann jederzeit zugegriffen werden. Täglich erweitert sich der Bestand um 350 Millionen. Die Bild-Übertragung in sehr große Speicherreservoirs scheint heute ein gelöstes Thema zu sein. Es bleibt die monumentale Frage, was in all diesen Bildern erfasst wurde und enthalten ist und ob sie zueinander zugeordnet werden. Das große Thema heute ist die Analyse der Bilder.

Algorithmen#

Die zwei zentralen Fragen der Computer Vision sind die Bildüberlagerung [„Image Matching“] und die Klassifizierung [„Image Classification“]. Die Bildüberlagerung liefert die 3D Form der Objekte durch Erfassung von Stereo-Parallaxen und Ableitung von Punktwolken. Die Überlagerung dient auch der Zusammenfügung von Einzelbildern in einen Bildstapel zur Erweiterung der Redundanz bei der Klassifizierung. Bilder müssen mit der Genauigkeit eines Bruchteils eines Pixels einander zugeordnet werden.

Die Bildklassifizierung spricht Bildelemente an, welche durch die Segmentierung erzeugt werden. Die Zuordnung einer Bedeutung zu diesen Bildelementen erfolgt mittels Klassifikatoren in Merkmalsräumen und mit Optimierung. Durch die hohe Redundanz der Bilder und durch die hohe Dimensionalität der Merkmalsräume ist der Komplexität der Verfahren keine Grenze gesetzt.

Ein populäres Ergebnis moderner Bildanalyse sind 3D Stadtmodelle. Diese werden aus Luftbildern und Bildern aus Fahrzeugen in den Straßen, auch aus handgehaltenen Kameras erzeugt. Und auf eine erste Erzeugung dieser Modelle folgt die Forderung nach Aktualisierung.

einem PC mit herkömmlichem Prozessor. Mithilfe von 4 GPUs reduziert sich die Rechenzeit um einen Faktor 100.

Ausblick#

Es ist an der TU Graz gelungen, eine traditionelle Trennung der Computer-Vision von der Computer-Grafik zu vermeiden. Das ist besonders hilfreich, wenn wir an die neuen Themen der Virtuellen und Augmentierten Wirklichkeit denken [Virtual und Augmented Reality]. Dort sind die großen Forschungsthemen eng an die Computer Vision angelehnt. Es wird automatisch mittels Kamerabildern in Echtzeit navigiert, mittels Datenbrille wird die Umwelt fotografisch erfasst und den errechneten Inhalten der Umwelt gegenübergestellt. Wir bezeichnen dieses kombinierte Fachgebiet als Maschinelles Sehen und Darstellen. Anderweitig spricht man auch vom Visual Computing.

Der Informatik wird manchmal vorgeworfen, dass sie dem Überwachungsstaat und dem Militarismus zu Dienste sei. Als Teilgebiet sei die Computer Vision in besonderem Masse geeignet, dem Staat zuzuarbeiten. Automatisches Navigieren könne nicht nur dem netten Autofahrer von nebenan, sondern auch der Waffensteuerung dienen, Bilder sind nicht nur in Facebook-Biografien den Freunden zugänglich, sondern dienen auch der staatlichen Überwachung. Exotische Sensorik mittels Radarbildern dient nicht nur der verbesserten Wettervorhersage durch Erfassung des arktischen Meereseises, oder einer polizeilichen Überwachung von Öltankern, wenn sie am offenen Meer illegal ihren Öl-Abfall entsorgen, sondern auch der Beobachtung militärischer Einrichtungen. Ich bezweifle, dass man hier zwischen der Informatik und dem Teilgebiet Computer Vision unterscheiden kann.

In einem nicht-militarisierten Umfeld wie dem Österreichs scheinen diese Sorgen weit hergeholt. Und es scheint, als sei aller technische Fortschritt auch immer eine potentielle Erweiterung der obrigkeitlichen Möglichkeiten, inklusive seiner Wehreinrichtungen, aber auch der Möglichkeiten böser Menschen.

Wir haben in der Bildverarbeitung und dann in der Computer Vision seit 1970 eine unglaublich aufregende Entwicklung erlebt und mitgestalten dürfen. Wie wird es weitergehen? Da halte ich es mit der Vorhersage von Mark Weiser, bis zu seinem Tod Leiter von Xerox-PARC [Palo Alto Research Center], der 1991 meinte, es komme eine Zeit, da werde der eine Ehepartner zuhause den anderen erinnern, beim Supermarktbesuch eine Packung Supercomputer mitzunehmen, etwa so wie man heute eine Packung Leuchtmittel kauft. Dies würde [nicht nur] die Computer Vision enorm beflügeln.